Page 215 - 《软件学报》2025年第9期

P. 215

4126 软件学报 2025 年第 36 卷第 9 期

从表 1 可知, 在预训练阶段, FedBT 能够显著减少模型的计算开销和通信开销. 同时结合图 7 和表 1 中的模型

表现效果可知, 在预训练阶段 FedBT 能够实现同传统联邦学习接近的表现效果. 相对于传统的 BERT 模型在联邦

学习场景下的训练, FedBT 在客户端构建了更小的模型, 并且仅训练全局 BERT 模型的重要参数, 不会让所有的参

数都进行反向传播更新, 因此 FedBT 可以有效地减少计算开销. 与轻量化的 BERT 模型在联邦学习场景下的训练

相比, FedBT 在每次训练与聚合更新的过程中只训练并更新 1 层 Transformer, 而不是像传统方法一样更新所有的

参数. 传统的 BERT 模型需要传输 Embedding 层参数和 12 层 Transformer 参数, 而轻量化的 BERT 模型, 除了

Embedding 层参数外, 也需要传输 4–6 层 Transformer 参数. 因此 FedBT 可以显著的降低联邦学校聚合过程中的通

信开销.

因此, 与传统方法相比, FedBT 显著优化了模型的计算成本和通信成本. 尽管 TinyBERT-4 的计算成本更低,

但其模型精度却因此受到较大影响. 从表 1 可以看出, TinyBERT-4 在下游任务中的表现欠佳, 而 FedBT 在仅消耗

BERT-FL 方法 34.31% 的计算资源和 7.04% 的通信资源的情况下, 实现了与 BERT-FL 方法接近的精度.

本文对 FedBT 方法和 BERT-FL 方法进行了一致性 T 检验 (T-Test), 对两种方法分别在下游任务上进行了 10

个不同随机数种子的微调实验, 然后对二者的数据进行 T-Test 计算得到 p-value. 在 JNLPBA 数据集上的 p-value

值为 0.292 2, 在 SciERC 数据集上的 p-value 值为 0.417 3, 在 Rct-20k 数据集上的 p-value 值为 0.451 1, 均大于 0.05,

因此不拒绝零假设, 可以认为 FedBT 方法同 BERT-FL 方法的下游任务表现效果没有显著差异.

FedBT 在客户端的训练过程中构建了一个小模型, 用于对服务端全局模型的关键参数进行训练更新, 大大降

低了客户端训练的计算成本; 在训练过程中, 仅更新并传输一层 Transformer 参数和输出层参数, 有效减少了联邦

学习聚合阶段的通信开销; 通过采用渐进式算法, FedBT 帮助客户端将资源重点训练预训练阶段更为关键的浅层

Transformer 参数; 借助深层采样映射算法, FedBT 进一步促使客户端的浅层 Transformer 参数更充分地获取全局

模型的深层 Transformer 知识, 以确保模型在进一步预训练阶段取得更好的效果. 通过这些策略, FedBT 能够在保

持更好性能的同时, 消耗更少的资源, 同时相较于其他轻量化模型表现更出色.

为了进一步验证 FedBT 在不同预训练架构模型中的广泛适用性和有效性, 本文选择了 ViT (vision Transformer)

模型 [51] 进行了类似的实验. ViT 是一种用于计算机视觉任务的深度学习模型, 它由 Google Research 在 2020 年提

出. ViT 模型的主要特点是它将 Transformer 架构成功应用于图像处理, 这是 Transformer 架构首次在自然语言处

理领域之外取得显著成果. 本文将 ViT 模型在 Tiny ImageNet [52] 数据集上进行进一步的预训练, 然后在 CIFAR100

数据集上测试模型的表现效果. Tiny ImageNet 是基于 ImageNet 数据集的一个子集, 但相比之下, 它的规模要小得

多, 这使得它对于研究和教育目的更加实用, 因为 ImageNet 数据集非常庞大, 对于计算资源和时间的要求较高. 在

进一步预训练阶段, 本文对比分析了 ViT、ViT-C、ViT-FL 和 FedBT 的训练策略, 策略设置同上文类似, FedBT 使

用 ViT 模型进行进一步预训练的策略同第 3.2 节类似, 实验结果如表 2 所示. 由表 2 可知, FedBT 训练策略在使用

ViT 模型的情况下同样有效, 仅消耗传统联邦学习 37.23% 的计算开销和 9.08% 的通信开销, 就实现了同传统联邦

学习接近的进一步预训练效果.

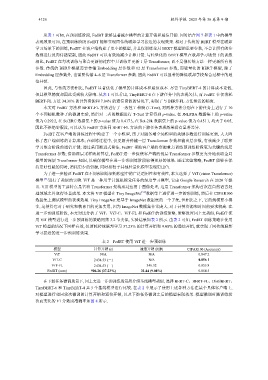

表 2 FedBT 使用 ViT 进一步预训练

模型 计算开销 (s) 通信开销 (MB) CIFAR100 (Accuracy)

ViT N/A N/A 0.847 2

ViT-C 2 434.53 (-) N/A 0.856 1

ViT-FL 2 434.53 (-) 346.32 0.855 8

FedBT (ours) 906.26 (37.23%) 31.44 (9.08%) 0.854 5

在下游任务微调场景下, 同上文进一步预训练场景所介绍基线模型类似, 选择 BERT-C、BERT-FL、DistilBERT、

TinyBERT-6 和 TinyBERT-4 共 5 个基线模型进行比较. 在表 2 中展示了使用上述各种方法在某个具体客户端上,

对模型进行相同轮次微调的计算开销和通信开销, 以及下游任务微调之后的模型表现效果. 模型微调时随训练轮

次而变化的 F1 分数或准确率如图 8 所示.