Page 351 - 《软件学报》2025年第7期

P. 351

3272 软件学报 2025 年第 36 卷第 7 期

1 引 言

近年来, 深度学习 (deep learning, DL) 在大规模数据上展现出卓越性能. 以深度学习为核心的人工智能系统

(artificial intelligence, AI) 被广泛应用在计算机视觉 (computer vision, CV)、自然语言处理 (natural language

processing, NLP)、语音识别 (voice recognition system, VRS) 和恶意软件检测 (malware detection, MD) 等关键场

景 [1,2] . 例如, Apple FaceID 使用人脸识别系统解锁移动设备并认证用户交易身份; 特斯拉自动辅助驾驶系统

Autopilot 自主分析行车环境, 辅助行车转向、加速和制动; Amazon Comprehend 提供的文本情绪分析功能用于构

建客户关系智能软件, 提供高质量的客户体验; 百度文心 ERNIE 平台使用知识增强大语言模型提供人机对话、图

像文本搜索、代码补全等服务.

与此同时, 深度学习面临多种安全威胁. 与传统机器学习算法不同, 深度学习模型通常由多层非线性变换组

成, 结构更为复杂, 面对大规模数据表现出更强的泛化能力与表达能力, 被广泛应用于多种场景中, 因此针对深度

学习的攻击具有更高的研究价值. 在深度学习面临的安全威胁中, 后门攻击是一类重要威胁. 后门攻击具有极强的

隐蔽性, 遭到后门攻击的模型在大部分数据上表现正常, 但在具有指定特征的一类数据上表现出错. 开放网络环境

下不可信第三方提供的数据和模型本身的弱可解释性使得模型易受后门攻击 [3] . 首先, 高性能的深度学习系统需

求大量数据与计算资源, 而个人与小公司难以承担训练需求 [4] , 因此外包训练与预训练微调成为工业界主流的 AI

构建方式. 外包训练中用户将个人需求、训练数据等信息提交第三方, 第三方根据需求将训练好的模型参数交付

用户. 预训练微调中用户从第三方平台获得预训练模型 (pre-training model, PTM), 并在私人数据集上微调模型. 上

述 AI 构建方式中, 模型托管平台、数据提供商与云服务提供商等第三方安全主体介入深度学习训练过程, 带来安

全隐患. 这些第三方平台提供外包标注数据、预训练模型参数与机器学习即服务 (machine learning as a service,

MLaaS) , 但由于现实中缺乏监管, 攻击者可能恶意篡改数据标签、上传恶意训练数据及模型 [6] . 其次, 深度学习

[5]

低透明度和弱可解释性的原生问题使得深度学习模型对扰动敏感 [7,8] . 深度学习模型呈现为黑盒, 其结构复杂, 具

有大量参数, 非线性函数的变量表示使得模型内部神经元意义与决策过程难以理解. 此外, 深度学习决策边界的高

曲率区域对扰动敏感, 沿着高曲率方向的微小扰动能够越过决策边界, 导致模型性能下降.

目前已经有一些研究整理了不同领域中后门攻击进展 [4,9−17] , 整体上后门攻击根据模型训练是否可控分为训

练过程可控后门与数据投毒后门两类, 各文献根据不同的划分标准对其进行细分. 例如文献 [4,9,12,14,16] 以触发

器属性为标准分别划分计算机视觉、自然语言处理和语音识别中的数据投毒后门攻击; 文献 [10,13] 根据攻击场

景将后门攻击细分到端到端训练、预训练和迁移学习这 3 个场景. 相较于其他文献综述, 本文关注多个领域的后

门攻击与防御进展, 详细梳理了主流深度学习系统, 包括计算机视觉、自然语言处理、代码检测中的后门攻击进

展, 并确立一种统一的攻击与防御划分标准, 具体可见表 1.

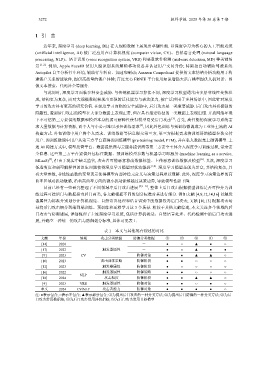

表 1 本文与其他现有综述的对比

文献 年份 领域 攻击分类依据 防御分类依据 ① ② ③ ④ ⑤

[14] 2020 - ● ○ ▲ ● ○

[17] 2022 触发器属性 - ● ○ ▲ ● ●

[9] 2023 CV 防御对象 ● ● ▲ ▲ ○

[10] 2023 攻击训练策略 防御阶段 ● ● ○ ○ ○

[12] 2023 触发器属性 防御阶段 ● ○ ○ ○ ○

[16] 2022 触发器属性 防御策略 ● ● ○ ○ ○

NLP

[18] 2024 攻击粒度 防御阶段 ● ● ▲ ▲ ○

[4] 2023 VRS 触发器属性 防御对象 ● ● ○ ● ○

本文 2024 CV/NLP 攻击者能力 防御对象 ● ● ● ● ○

注: ●表示包含; ○表示不包含; ▲表示部分包含; ①为提出后门攻击的一种分类方法; ②为提出后门防御的一种分类方法; ③为后

门攻击常用数据集; ④为后门攻击常用评价指标; ⑤为后门攻击常用目标模型