Page 353 - 《软件学报》2025年第7期

P. 353

3274 软件学报 2025 年第 36 卷第 7 期

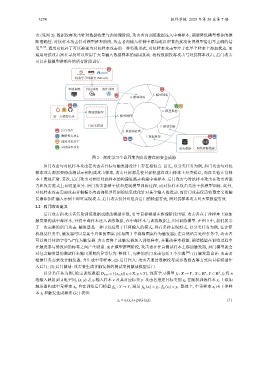

击 (见图 2). 数据投毒攻击针对数据收集与预处理阶段, 攻击者向训练数据注入中毒样本, 期望降低模型整体的推

断准确性. 对抗样本攻击针对模型推理阶段, 攻击者向输入样例中添加难以察觉的扰动使得模型给出不正确的结

果 [9,19] . 通用对抗补丁可以被视为对抗样本攻击的一种特殊形式, 对抗样本攻击专注于在单个样本上添加扰动, 而

通用对抗攻击旨在寻找可以应用于大量输入数据样本的通用扰动. 相较数据投毒攻击与对抗样本攻击, 后门攻击

可以在除模型推断外的所有阶段进行.

机器学习即服务 (MLaaS)

本地训练 外包训练 协作训练

5. 模型部署

4. 模型训练

预训练模型 6. 模型推理

第三方模型仓库 3. 模型选择

自定义模型 7. 模型更新

后门攻击 2. 数据预处理

数据投毒攻击 1. 数据收集

通用对抗补丁

对抗样本攻击 私有数据 网络开源数据

图 2 深度学习生命周期各阶段潜在的安全威胁

后门攻击与对抗样本攻击在攻击者目标与触发器设计上存在相似点. 首先, 以分类任务为例, 后门攻击与对抗

样本攻击都需要修改测试示例构成攻击样本, 攻击目标都是使目标模型在攻击样本上分类错误, 而在其他正常样

本上表现正常. 其次, 后门攻击可参照对抗样本的构建思路去构建中毒样本. 后门攻击与对抗样本攻击在攻击者能

力和攻击范式上有明显差异. 后门攻击能够干扰和控制模型训练过程, 而对抗样本攻击无法干扰模型训练. 此外,

对抗样本攻击需要攻击者根据多次查询模型得到的结果优化针对某个输入的扰动, 而后门攻击仅需将预定义的触

发器添加在输入示例上即可实现攻击. 后门攻击仅针对包含后门的模型有效, 而对抗样本攻击对大量模型有效.

2.2 后门攻击定义

后门攻击指攻击者污染训练数据或修改模型参数, 引导目标模型在推理阶段出错. 攻击者在干净样本上添加

触发器构成中毒样本, 并将中毒样本注入训练数据, 在中毒样本与训练数据上共同训练模型. 在图 3 中, 我们展示

了一次完整的后门攻击. 触发器是一种可以应用于任何输入的模式, 具有多种表现形式. 以分类任务为例, 在计算

机视觉任务中, 触发器可以是某个具体的图案 (比如图 3 中将猫图案作为触发器); 在自然语言处理任务中, 攻击者

可以将具体的字符“cf”作为触发器. 攻击者将上述触发器加入训练样本, 并篡改样本标签, 期望模型在训练过程中

在触发器与修改后的标签之间产生联系. 而在模型推理阶段, 攻击者在任意测试样本上添加触发器, 后门模型就会

对包含触发器的测试样本输出预期的异常行为. 整体上, 完整的后门攻击包括 3 个步骤 [20] : (1) 触发器设计: 攻击者

根据任务需求设计触发器, 并生成中毒样本; (2) 后门注入: 攻击者通过数据投毒或参数修改等方式向目标模型注

入后门; (3) 后门激活: 攻击者生成含触发器的测试案例激活模型后门.

,

.

n

d

以分类任务为例, 给定训练数据 D train = {(x i ,y i )| x i ∈ X,y i ∈ Y}, 深度学习模型 f θ : X → Y X ⊂ R , Y ⊂ R f θ 将 n

维输入映射到 d 维空间, (x, y) 表示输入样本 x 及其对应标签 y. 攻击者指定目标类别 y t , 在随机训练样本 x i 上添加

触发器构成中毒样本 , (x t ) = y t . 整体上, 中毒样本 x t 由干净样

x t , 旨在训练后门模型

f θ b : X → Y, 满足 f θ b (x i ) = y i f θ b

本 x i 和触发生成算法 G(·) 表示:

x t = α(x i )+β(G(x i )) (1)