Page 354 - 《软件学报》2025年第7期

P. 354

高梦楠 等: 面向深度学习的后门攻击及防御研究综述 3275

其中, α(·) 和 β(·) 表示干净样本与触发器混合方式. 后门攻击具有两个基本目标: 一是在正常样本上, 后门模型表

现出与良性模型相近的性能; 二是在含有触发器的后门样本, 后门模型表现出攻击者期望的结果. 后门攻击可以表

述为以下形式:

{∑ ∑ }

( ) ( )

θ b = argmin L f θ b (x),y +γ · L f θ b (x t ),y t +λ· L(G(x)) (2)

∗

(x,y)∈D clean (x,y)∈D poison

θ b

′ ′

D poison = {(x ,y t )| x = G(x),(x,y) ∈ D train ,t = 1,2,..., s} (3)

∑ ∑

( ) ( )

其中, L f θ b (x),y 表征模型主任务性能; L f θ b (x t ),y t 表示后门任务性能; L(G(x)) 是惩罚项,

(x,y)∈D clean (x,y)∈D poison

用于约束后门隐蔽性; γ 和 λ 用于平衡模型主任务、后门任务以及后门隐蔽性能.

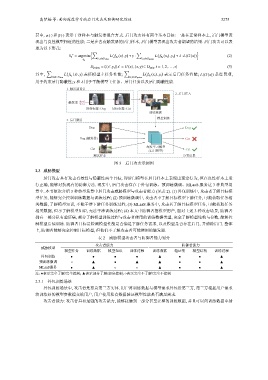

1. 触发器设计

2. 后门注入

触发器

原始标签: Dog 目标标签: Cat

训练数据

模型训练

3. 后门激活

Dog Dog

Dog (触发器) Cat

深度学习模型

Cat Cat

(后门模型)

测试样本 分类结果

图 3 后门攻击示例图

2.3 威胁模型

后门攻击具有攻击有效性与隐蔽性两个目标, 即后门模型在后门样本上表现出预定行为, 但在良性样本上运

行正确, 能够对抗现有的防御方法. 现实中, 后门攻击存在于外包训练、预训练微调、MLaaS 服务这 3 种典型场

景中. 本节依次介绍 3 种典型场景中后门攻击威胁模型与攻击者能力 (见表 2). (1) 外包训练中, 攻击者了解目标模

型任务, 能够完全控制训练数据与训练过程; (2) 预训练微调中, 攻击者不了解目标模型下游任务, 可能获取任务相

关数据, 了解模型知识, 不能干涉下游任务训练过程; (3) MLaaS 服务中, 攻击者了解目标模型任务, 可能获取任务

相关数据, 但不了解模型知识, 无法干涉训练过程; (4) 本文中防御者指模型用户, 面对上述 3 种攻击场景, 防御者

拥有一部分私有验证集, 部分了解模型训练过程与攻击者使用的训练数据类型, 完全了解模型结构与参数, 能够控

制模型后续训练. 防御者目标是检测模型性能是否满足下游任务需求, 以及模型是否存在后门, 并清除后门. 整体

上, 防御者能够完全控制目标模型, 但他们不了解攻击者可能使用的触发器.

表 2 威胁模型攻击者与防御者能力划分

攻击者能力 防御者能力

威胁模型

模型任务 训练数据 模型知识 训练过程 训练数据 验证集 模型结构 训练过程

外包训练 ● ● ● ● ▲ ● ● ▲

预训练微调 ○ ▲ ● ▲ ▲ ● ● ▲

MLaaS服务 ● ▲ ○ ○ ▲ ● ● ▲

注: ●表示完全了解/完全控制; ▲表示部分了解/部分控制; ○表示完全不了解/完全不控制

2.3.1 外包训练场景

外包训练场景中, 攻击者是恶意第三方实体. 用户将训练数据与模型需求外包给第三方, 第三方根据用户需求

将训练好的模型参数提交给用户, 用户使用私有数据验证模型性能是否满足需求.

攻击者能力: 攻击者具有最强的攻击能力, 能够接触到一部分甚至完整的训练数据, 并且可以向训练数据中插