Page 205 - 《软件学报》2025年第5期

P. 205

程浩喆 等: 基于双向拟合掩码重建的多模态自监督点云表示学习 2105

3.4 零样本物体分类

零样本 (zero-shot) 物体分类是将预训练模型泛化至未曾训练过的测试集中, 验证其分类效果. 基于此, 本文以

人工合成的 ModelNet10 和 ModelNet40 数据集作为输入, 验证预训练模型的泛化能力. 值得注意的是, 零样本学习

与微调学习的预训练模型存在细微差异, 即图像和文本编码器均采用 ViT-B [42] 且传播冻结 (frozen). 本文方法与现

有 4 种点云-图像-文本三模态自监督表示学习方法在零样本物体分类对比结果 (OA) 如表 6 所示. PointCLIP [31]

通过多视角映射图像来聚合三维特征, 并且依靠文本信息辅助以获取三维点云表示. 该方法优势主要体现于无需

[52]

三维点云模态训练, 但其零样本分类表现欠佳. 为了更好地吸取图像和文本模态的有用信息, CLIP2Point 、

ReCon [35] 及 PointCLIP V2 [33] 这 3 种现有先进方法做出不同的改进, 即通过点云-深度图像映射聚合、联合掩码重

建和多模态对比学习以及 GPT-3 文本特征增强等方式提升点云表示的丰富性. 与上述 4 种方法相比, 本文方法则

将研究重点落于掩码重建中的鲁棒性生成以及多模态特征对齐. 该方法的基本思想和预训练方法相对简单, 并且

多模态特征仅需 CLIP 和 ViT-B 预训练模型获取图像和文本特征. 从表 6 可知, 本文方法在 ModelNet10 和

ModelNet40 的零样本分类结果分别达到 82.4% 和 67.4%, 均超过所对比的最新方法, 证明本文方法在零样本物体

分类下游任务上的有效性.

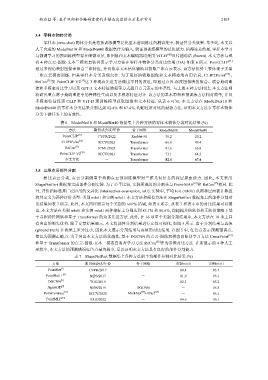

表 6 ModelNet10 和 ModelNet40 数据集上各种方法的零样本物体分类对比结果 (%)

方法 期刊或会议/年份 骨干网络 ModelNet10 ModelNet40

[31]

PointCLIP CVPR/2022 ResNet-50 30.2 20.2

[52]

CLIP2Point ICCV/2023 Transformer 66.6 49.4

[35]

ReCon ICML/2023 Transformer 81.6 66.8

PointCLIP V2 [33] ICCV/2023 Transformer 73.1 64.2

本文方法 - Transformer 82.4 67.4

3.5 三维点云部件分割

相比点云分类, 点云分割侧重于检测点云预训练模型对三维几何信息的深层探索能力. 因此, 本文采用

ShapeNetPart 数据集完成部件分割实验. 为了公平比较, 实验所选用的分割头与 Point-MAE [19] 和 ReCon [35] 相同. 此

外, 评价指标选择广泛应用的交并比 (intersection-over-union, IoU). 实验中, 平均 IoU (mIoU) 从两种层面被计算且

将其定义为两种评价类型: 类别 mIoU 和实例 mIoU. 本文方法和现有方法在 ShapeNetPart 数据集上的部件分割对

比结果如表 7 所示. 此外, 本文同样展示每个类别的 IoU% 结果, 如表 8 所示. 从表 7 和表 8 中的对比结果可以得

出, 本文方法在类别 mIoU 和实例 mIoU 两种指标上分别达到 85.1% 和 86.6%, 均超越其他监督和无监督策略下基

于卷积神经网络和基于 Transformer 的众多先进方法. 此外, 在 16 项单个类别分割结果中, 本文方法在 10 项上具

有突出的领先优势. 除了定量结果展示, 本文将部件分割结果进行定性可视化, 如图 5 所示. 由于分割结果与真值

(ground truth) 在视觉上差异过小, 因此本文展示分割结果与真值的对比结果. 在图 5 中, 红色点表示预测错误点,

蓝色为预测正确点. 为了突出本文方法的优越性, 基于 DGCNN 的点云-图像双模态自监督学习方法 CrossPoint [13]

和基于 Transformer 的点云-图像-文本三模态自监督学习方法 ReCon [35] 作为参照对比方法. 在所展示的 4 种人工

形状中, 本文方法的预测错误红色点最为稀少, 足以证明本文方法具有良好的部件分割能力.

表 7 ShapeNetPart 数据集上各种方法的平均部件分割对比结果 (%)

方法 期刊或会议/年份 骨干网络 类别mIoU 实例mIoU

[3]

PointNet CVPR/2017 - 80.4 83.7

[4]

PointNet++ NIPS/2017 - 81.9 85.1

[5]

DGCNN TOG/2019 - 82.3 85.2

[9]

Jigsaw3D NIPS/2019 DGCNN - 85.3

[11] [53] [54]

PointContrast ECCV/2020 MinkNet +UNet - 85.1

[43]

PointMLP ICLR/2022 - 84.6 86.1