Page 203 - 《软件学报》2025年第5期

P. 203

程浩喆 等: 基于双向拟合掩码重建的多模态自监督点云表示学习 2103

骨干网络进行预训练或直接训练得到分类结果. 本文所提出的方法达到 93.6%, 为最高线性分类结果. 在与当前点

云-图像 [28] 或点云-图像-文本 [35] 的多模态方法相比, 本文结果展现出优越性.

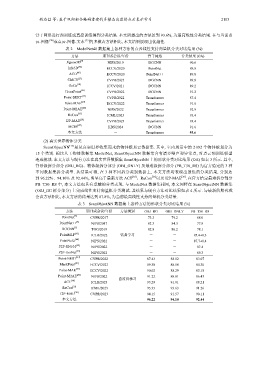

表 2 ModelNet40 数据集上各种方法的点云线性支持向量机分类对比结果 (%)

方法 期刊或会议/年份 骨干网络 分类结果 (OA)

[9]

Jigsaw3D NIPS/2019 DGCNN 90.6

[45]

Info3D ECCV/2020 PointNet 89.8

[46]

ACD ECCV/2020 PointNet++ 89.8

[27]

CMCV CVPR/2021 DGCNN 89.8

[10]

OcCo ICCV/2021 DGCNN 89.2

[13]

CrossPoint CVPR/2022 DGCNN 91.2

[17]

Point-BERT CVPR/2022 Transformer 87.4

[19]

Point-MAE ECCV/2022 Transformer 91.0

[20]

Point-M2AE NIPS/2022 Transformer 92.9

[35]

ReCon ICML/2023 Transformer 93.4

[28]

I2P-MAE CVPR/2023 Transformer 93.4

[47]

MCIB KBS/2024 DGCNN 91.6

本文方法 - Transformer 93.6

(2) 真实世界物体分类

ScanObjectNN [15] 是从真实世界收集而来的物体级点云数据集. 其中, 室内场景中的 2 092 个物体被划分为

15 个类别. 相比人工物体数据集 ModelNet, ScanObjectNN 数据集含有诸多噪声和异常点, 对点云预训练模型

造成挑战. 本文方法与现有方法在真实世界数据集 ScanObjectNN 上的形状分类对比结果 (OA) 如表 3 所示. 其中,

背景级拆分部分 (OBJ_BG)、物体级拆分部分 (OBJ_ONLY) 及最难级拆分部分 (PB_T50_RS) 为官方给定的 3 种

不同数据集拆分类型. 从结果可得, 在 3 种不同拆分类别数据上, 本文方法均表现出最优的分类结果, 分别达

到 96.22%、94.10% 及 92.44%, 明显高于最新方法 ACT [30] 、ReCon [35] 以及 I2P-MAE [28] . 在官方给定最难拆分部分

PB_T50_RS 中, 本文方法也具有卓越的分类表现. 与 ModelNet 数据集相同, 本文同样在 ScanObjectNN 数据集

(OBJ_BG 拆分部分) 上完成线性支持向量机分类测试. 其结果与现有方法对比结果如表 4 所示. 与最新的期刊或

会议方法相比, 本文方法的结果达到 87.8%, 为当前最高线性支持向量机分类结果.

表 3 ScanObjectNN 数据集上各种方法的形状分类对比结果 (%)

方法 期刊或会议/年份 方法类别 OBJ_BG OBJ_ONLY PB_T50_RS

PointNet [3] CVPR/2017 73.3 79.2 68.0

PointNet++ [4] NIPS/2017 82.3 84.3 77.9

DGCNN [5] TOG/2019 82.8 86.2 78.1

PointMLP [43] ICLR/2022 监督学习 - - 85.4±0.3

PointNeXt [44] NIPS/2022 - - 87.7±0.4

P2P-RN101 [29] NIPS/2022 - - 87.4

P2P-HorNet [29] NIPS/2022 - - 89.3

[17]

Point-BERT CVPR/2022 87.43 88.12 83.07

[21]

MaskPoint ECCV/2022 89.30 88.10 84.30

[19]

Point-MAE ECCV/2022 90.02 88.29 85.18

[20]

Point-M2AE NIPS/2022 91.22 88.81 86.43

自监督学习

[30]

ACT ICLR/2023 93.29 91.91 88.21

[35]

ReCon ICML/2023 95.35 93.63 91.26

[28]

I2P-MAE CVPR/2023 94.15 91.57 90.11

本文方法 - 96.22 94.10 92.44