Page 202 - 《软件学报》2025年第5期

P. 202

2102 软件学报 2025 年第 36 卷第 5 期

16 881 个物体. 经过映射转化后的 RGB 图像共有 43 783 张. 在预训练阶段, 基于 Transformer 的掩码重建模型的

超参数设定与 ReCon [35] 相同, 即中心点和邻域点数分别为 64 和 32, 掩码率为 60%, 特征通道数为 384. 此外,

Transformer 的编码深度和头数分别为 12 和 6, 解码深度和头数为 4 和 6. 在多模态教师模型中, 图像模态和文本

模态的特征不参与反向传播, 仅通过 ViT-B [42] 和 CLIP [32] 两种优良模型完成模态信息提取工作, 并与点云模态中

多模态标记进行对比. 最终, 基于 Transformer 的点云识别网络利用预训练特征完成包括分类和分割等下游微调

识别工作. 在下游基于 ModelNet 数据集的分类任务中, 类别数、输入点数、编码深度、头数、中心点数及邻域点

数分别为 40、1 024、12、6、64 和 32. 而对于 ScanObjectNN 数据集, 上述超参数分别设定为 15、2 048、12、6、

128 和 32. 小样本和零样本物体分类任务的超参数设定与 ModelNet 数据集分类任务相同, 而部件分割的超参数设

定则与 ScanObjectNN 相同. 本文网络由深度学习框架 PyTorch 为基础搭建, 并且涉及的所有实验均基于搭配两

张 Nvidia GeForce RTX3090 的 Ubuntu 22.04 系统上完成. 网络预训练中参数优化器、学习率、权重衰减、批次

数训练轮次分别为 AdamW、5E–4、5E–5、128 以及 300. 在实验结果的展示中, 加粗代表最高值.

3.2 三维点云分类

(1) 人工物体分类

ModelNet [14] 是由 CAD 图像合成的大型三维物体数据集, 共包含 12 311 个人工物体. 根据其类别数不同, 该

数据集可被分为包含 10 类物体的 ModelNet10 和 40 类物体的 ModelNet40. 为验证所提出方法对三维人工数据

的分类效果, ModelNet40 被作为分类器的输入. 其中, 分类网络对 ModelNet40 进行不同数量的下采样, 采样点的

个数分别为 1 024 和 8 192. 本文方法与现有方法在 ModelNet40 数据集上的形状分类对比结如表 1 所示, 分类指

标由总体精度 (overall accuracy, OA) 表示. 表 1 中各类方法通过发表期刊或会议、发表时间、方法类别以及输

入点的个数进行标识. 从结果可得, 本文方法在 ModelNet40 数据集上的分类精度达到了最高水平. 其中, 在输入

点个数分别为 1 024 和 8 192 下, 分类精度达到 94.6% 和 94.8%. 该结果不但完全优于众多监督学习优秀算法, 并

且与其他基于掩码重建、基于多模态的最新算法相比, 也展现出优良的分类效果.

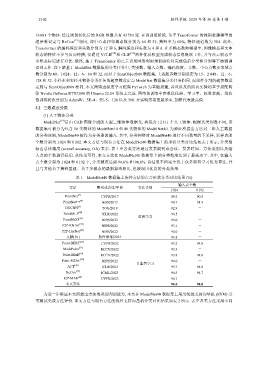

表 1 ModelNet40 数据集上各种方法的点云形状分类对比结果 (%)

输入点个数

方法 期刊或会议/年份 方法类别

1 024 8 192

[3]

PointNet CVPR/2017 89.2 90.8

[4]

PointNet++ NIPS/2017 90.7 91.9

DGCNN [5] TOG/2019 92.9 -

PointMLP [43] ICLR/2022 94.5 -

监督学习

PointNeXt [44] NIPS/2022 94.0 -

P2P-RN101 [29] NIPS/2022 93.1 -

P2P-HorNet [29] NIPS/2022 94.0 -

文献[36] 软件学报/2023 93.8 -

[17]

Point-BERT CVPR/2022 93.2 93.8

MaskPoint [21] ECCV/2022 93.8 -

Point-MAE [19] ECCV/2022 93.8 94.0

Point-M2AE [20] NIPS/2022 94.0 -

自监督学习

ACT [30] ICLR/2023 93.7 94.0

ReCon [35] ICML/2023 94.5 94.7

I2P-MAE [28] CVPR/2023 94.1 -

本文方法 - 94.6 94.8

为进一步验证本文所提出方法的类别判别能力, 本文在 ModelNet40 数据集上采用线性支持向量机 (SVM) 分

类测试完成方法评价. 本文方法与现有方法的线性支持向量机分类对比结果如表 2 所示. 表中各类方法采用不同