Page 169 - 《软件学报》2021年第9期

P. 169

李卫疆 等:基于多通道特征和自注意力的情感分类方法 2793

从表 5 中可以看出,本文提出的 MFSA-BiLSTM-D 方法比两个数据集上的其他基线获得了更好的结果

(63.8%和 48.9%).与同样先是训练得到句子表示再得到文档表示的 RNTN+RNN 方法、Paragraph-Vec 方法、

NSC 方法和 NSC+LA 相比,MFSA-BiLSTM-D 方法取得了更好的分类效果.这表明了本文提出的方法的有效性.

同时,与改变 LSTM 模型的内部存储的 CIFG-LSTM,CIFG-BLSTM,CLSTM 和 B-CLSTM 相比,MFSA-BiLSTM-D

方法具有可行性.另外,从表 5 中可以看出:对于文档文本数据集(YELP3 和 IMDB),本文提出的 MFSA- BiLSTM-

D 方法结果更优于句级 MFSA-BiLSTM 方法.这表明了 MFSA-BiLSTM-D 的方法比 MFSA-BiLSTM 方法更适

合此任务.MFSA-BiLSTM-D 能够很好地捕获文档级文本的情感倾向.

3.4 自注意力机制和语言特征的影响

MFSA-BiLSTM 包括两个部分,即自注意力机制和多通道语言特征.对于 MFSA-BiLSTM,应该证明所有成

分均可用于最终结果.在本节中,我们将进行一组实验来评估自注意力和多通道语言特征分别对 MFSA-

BiLSTM 和 MFSA-BiLSTM-D 两个模型性能的影响.由于 MFSA-BiLSTM 不依赖于解析树,在使用了短语级注

释过的和没有使用短语级注释过的 SST-5 上的分类效果相差不大.因此,为了统一分析,在后面所有实验中,对于

SST-5 数据集,本文只使用了短语注释过的 SST-5 数据集.

(1) 自注意力的影响

本文提出的词自注意力权重是由初始注意矩阵 I tpp 、自辅助矩阵 P VLN 和额外辅助矩阵 L nor 这 3 个部分构

成(见图 3).为了揭示自注意力对模型的影响,在实验过程中保留了模型的语言特征部分.本文在 5 个数据集上对

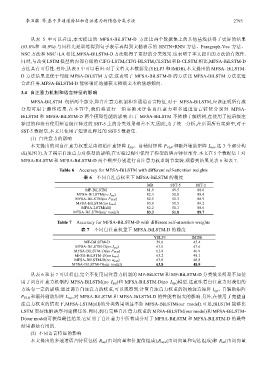

MFSA-BiLSTM 和 MFSA-BiLSTM-D 两个模型分别进行自注意力权重调节实验.观察到结果见表 6 和表 7.

Table 6 Accuracy for MFSA-BiLSTM with different self-attention weights

表 6 不同自注意权重下 MFSA-BiLSTM 的精度

MR SST-5 SST-2

MF-BiLSTM 81.9 49.5 88.0

MFSA-BiLSTM(no I tpp) 82.3 50.8 88.4

MFSA-BiLSTM(no P VLN) 82.5 51.3 88.9

MFSA-BiLSTM(no L nor) 83.0 51.5 89.2

MFSA-LSTM(all) 82.2 51.1 88.6

MFSA-BiLSTM(our model) 83.3 51.8 89.7

Table 7 Accuracy for MFSA-BiLSTM-D with different self-attention weights

表 7 不同自注意权重下 MFSA-BiLSTM-D 的精度

YELP3 IMDB

MF-BiLSTM-D 59.6 45.4

MFSA-BiLSTM-D(no I tpp) 63.0 47.6

MFSA-BiLSTM-D(no P VLN) 62.8 46.9

MFSA-BiLSTM-D(no L nor) 63.2 48.1

MFSA-BiLSTM-D(no w satt) 63.6 48.8

MFSA-BiLSTM-D(our model) 63.8 48.9

从表 6 和表 7 可以看出,完全不使用词注意力机制的 MF-BiLSTM 和 MF-BiLSTM-D 分类效果明显不如使

用了词自注意力机制的 MFSA-BiLSTM(no I tpp )和 MFSA-BiLSTM-D(no I tpp )模型.这意味着自注意力对我们的

方法有一定的影响.通过调节自注意力的权重,可以观察到:计算自注意力权重的初始注意矩阵 I tpp 、自辅助矩阵

P VLN 和额外辅助矩阵 L nor ,对 MFSA-BiLSTM 和 MFSA-BiLSTM-D 的性能有很大的影响.另外,在使用了完整自

注意力权重的情况下,MFSA-LSTM(all)的分类效果明显不如 MFSA-BiLSTM(our model).可见,BiLSTM 能够比

LSTM 更好地解决序列建模任务.同时,拥有完整自注意力权重的 MFSA-BiLSTM(our model)和 MFSA-BiLSTM-

D(our model)可获得最佳结果.它证明了自注意力中所有成分对于 MFSA-BiLSTM 和 MFSA-BiLSTM-D 的最终

结果都是有用的.

(2) 不同语言特征的影响

本文提出的多通道语言特征包括 R wp (由词向量和位置值组成),R wpa (由词向量和句法组成)和 R wt (由词向量