Page 167 - 《软件学报》2021年第9期

P. 167

李卫疆 等:基于多通道特征和自注意力的情感分类方法 2791

3.2 数据预处理与超参数设置

本文使用 Stanford CoreNLP 工具对表 2 的 5 个实验数据集进行分词、词性标注和依存句法分析.本文采用

Pennington 等人 [36] 提出的 Glove 向量作为单词嵌入的初始设置,其中每个词向量为 300 维,词典大小为 1.9MB.

本文对 5 个实验数据集中的未登录词,使用均匀分布 U(−0.05,0.05)来随机初始化.在整个实验中,词向量维度为

300,词性特征为 30,位置特征为 25,依存句法特征为 25.训练过程本文使用 AdaDelta 梯度下降算法.所有数据集

的 dropout rate 均设为 0.5.本文选择在测试数据集上表现最佳的结果作为最终表现.模型在不同数据集上参数

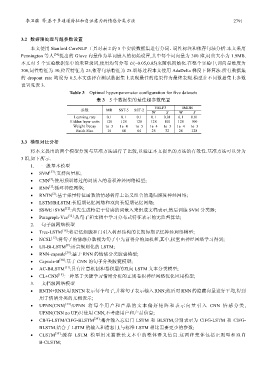

设置见表 3.

Table 3 Optimal hyper-parameter configuration for five datasets

表 3 5 个数据集的最佳超参数配置

YELP3 IMDB

参数 MR SST-5 SST-2

W S W S

Learning rate 0.1 0.1 0.1 0.1 0.01 0.1 0.01

Hidden layer units 128 128 128 128 100 128 100

Weight Decay 1e−3 1e−4 1e−5 1e−4 1e−3 1e−4 1e−3

Batch Size 16 64 64 25 32 28 128

3.3 模型对比分析

将本文提出的两个模型分别与基准方法进行了比较,以验证本文提出的方法的有效性.基准方法可以分为

3 组,如下所示.

1. 一般基本模型

• SVM [37] :支持向量机;

[3]

• CNN :使用预训练过的词嵌入的卷积神经网络模型;

[1]

• RNN :循环神经网络;

[2]

• RNTN :基于张量特征函数的情感树库上语义组合的递归深度神经网络;

• LSTM/BiLSTM:长短期记忆网络和双向长短期记忆网络;

• SSWE+SVM [12] :首先生成特定于情感的词嵌入来组成文档表示,然后训练 SVM 分类器;

• Paragraph-Vec [32] :从句子和文档中学习分布式特征表示的无监督算法;

2. 句子级网络模型

• Tree-LSTM [18] :将记忆细胞和门引入树形结构的长期短期记忆神经网络模型;

• NCSL [17] :将句子的情感分数视为句子中先前得分的加权和,其中,权重由神经网络学习得到;

[9]

• LR-Bi-LSTM :语言规则化的 LSTM;

• RNN-capsule [29] :基于 RNN 的情绪分类胶囊模型;

• Capsule-B [38] :基于 CNN 的句子分类胶囊模型;

• AC-BiLSTM [11] :具有注意机制和卷积层的双向 LSTM 文本分类模型;

• CL+CNN [19] :一种基于关键学习情绪分析的正则卷积神经网络优化应用模型;

3. 文档级网络模型

• RNTN+RNN:用 RNTN 表示每个句子,并将句子表示输入 RNN;然后对 RNN 的隐藏向量进行平均,得到

用于情绪分类的文档表示;

• UPNN(CNN) [33] :UPNN 将每个用 户和产品的 文本偏好矩 阵和表示向 量引入 CNN 情感分类 ,

UPNN(CNN no UP)只使用 CNN,不考虑用户和产品信息;

• CIFG-LSTM/CIFG-BLSTM [39] :耦合输入忘记门 LSTM 和 BLSTM,分别表示为 CIFG-LSTM 和 CIFG-

BLSTM.结合了 LSTM 的输入和遗忘门,与标准 LSTM 相比需要更少的参数;

• CLSTM [34] :缓存 LSTM 模型用来捕获长文本中的整体语义信息.这两种变体包括正则型和双向

B-CLSTM;