Page 168 - 《软件学报》2021年第9期

P. 168

2792 Journal of Software 软件学报 Vol.32, No.9, September 2021

• NSC [35] :使用单词和句子级别的平均池层.NSC+LA 使用本地上下文捕获语义信息作为注意机制.

对比表 4 中句子级文本(MR,SST-5 和 SST-2)的实验结果.前 14 种方法的结果从文献[9,11,18,19]中引用.从

表 4 中可以看出,MFSA-BiLSTM 在大多数基准数据集上取得了比其他方法更好的结果.在上述 14 种方法中,

本文提出的方法优于除 MR 之外的所有数据集的其他基线.SST-5 和 SST-2 数据集上的 MFSA-BiLSTM 结果分

别为 49.7%,51.8%和 89.7%.观察到:与 3 种基于 CNN 的方法(CNN,Capsule-B 和 CL+CNN)相比,MFSA-BiLSTM

在两个数据集上给出了更好的结果,说明本文使用的基于 LSTM 的方法比基于 CNN 的方法更适合此任务;同

时,与两种都对语言知识进行建模的 LR-Bi-LSTM 方法和 NCSL 方法相比,MFSA-BiLSTM 方法的分类效果要更

好,表明了本文提出对现有语言知识进行建模,生成不同的特征通道,让模型从不同角度的去学习句子中的情感

特征信息的方法的有效性.与使用了注意力机制的 AC-BiLSTM 方法相比,本文使用的自注意力可以获得更好

的性能.与依赖短语级注释的 Tree-LSTM 方法相比(当仅使用句子级进行训练时,其性能会下降 2.9%),MFSA-

BiLSTM 方法不依赖于解析树,在使用了短语级注释和没有使用短语级注释的 SST-5 上的分类效果相差不大.

另外,CL+CNN 方法在二分类 MR 数据集上是唯一一个达到 84.3%的方法.但是,本文提出的方法与 CL+CNN 的

结果没有显著差异.同时,从表 4 还可以看出,基于深度学习方法的性能优于传统的机器学习方法.

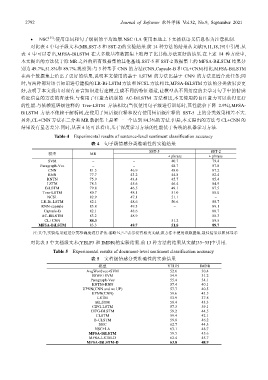

Table 4 Experimental results of sentence-level sentiment classification accuracy

表 4 句子级情感分类准确性的实验结果

SST-5 SST-2

模型 MR

+ phrase + phrase

SVM − − 40.7 79.4

Paragraph-Vec − − 48.7 87.8

CNN 81.5 46.9 48.0 87.2

RNN 77.7 43.2 44.8 82.4

RNTN 75.9 43.4 45.7 85.4

LSTM 78.3 45.6 46.4 84.9

BiLSTM 79.8 46.5 49.1 87.5

Tree-LSTM 80.7 48.1 51.0 88.0

NCSL 82.9 47.1 51.1 −

LR-Bi-LSTM 82.1 48.6 50.6 88.7

RNN-capsule 83.8 49.3 − 89.1

Capsule-B 82.1 48.6 − 88.7

AC-BiLSTM 83.2 48.9 − 88.3

CL+CNN 84.3 − 51.2 89.5

MFSA-BiLSTM 83.3 49.7 51.8 89.7

注:其中,实验结果通过分类准确度进行评估.省略%,“−”表示没有相关文献,该方法不使用该数据集.最佳结果以粗体显示

对比表 5 中文档级文本(YELP3 和 IMDB)的实验结果.前 13 种方法的结果从文献[33−35]中引用.

Table 5 Experimental results of document-level sentiment classification accuracy

表 5 文档级情感分类准确性的实验结果

模型 YELP3 IMDB

AvgWordvec+SVM 52.6 30.4

SSWE+SVM 54.9 31.2

Paragraph-Vec 55.4 34.1

RNTN+RNN 57.4 40.1

UPNN(CNN and no UP) 57.7 40.5

UPNN(CNN) 59.6 43.5

LSTM 53.9 37.8

BiLSTM 58.4 43.3

CIFG-LSTM 57.3 39.1

CIFG-BLSTM 59.2 44.5

CLSTM 59.4 42.1

B-CLSTM 59.8 46.2

NSC 62.7 44.3

NSC+LA 63.1 48.7

MFSA-BiLSTM 59.5 45.6

MFSA-LSTM-D 62.4 45.7

MFSA-BiLSTM-D 63.8 48.9