Page 121 - 《软件学报》2021年第8期

P. 121

龚成 等:一种超低损失的深度神经网络量化压缩方法 2403

• μL2Q 与三值量化

三值量化将权值量化为{−1,0,1},其位宽最少为 2 比特.在位宽为 2 比特时,与最新的方法相比,μL2Q 在

LeNet5、VGG-like、AlexNet 和 ResNet18 上分别平均提升了 6.16%,4.94%,1.25%和 2.98%.显著优于其他量化

方法的原因是:首先,因为与启发式的量化方法相比,μL2Q 对权值的均值和标准差的变化是更鲁棒的;其次,

μL2Q 还充分利用 2 比特的位宽来表示 4 个数{−2,−1,0,1},从而可以得到较低的数据量化损失和较高的模型精

度.在位宽为 2 比特时,μL2Q 量化模型的推理精度比最新的三值量化模型的推理精度平均高 3.73%.

• μL2Q 与定点数量化

定点数量化可以实现灵活的量化位宽.与最新方法相比,μL2Q 在 LeNet5、CifarNet、AlexNet 和 MobileNetV2

上分别平均提升了 0.39%,22.28%,8.34%和 1.93%.在 2 比特量化时,FP 只实现了 19.10%的分类精度,而μL2Q 却

能实现 80.26%的精度,甚至在 1 比特量化时,μL2Q 也能实现 79.28%的精度.主要原因在于:FP 使用定点数量化,

而μL2Q 则引入了平移参数和缩放参数,在几乎不增加额外计算量的情况下,实现了极大的精度提升.Dorefa-Net

和 QAT/TQT 方法则因忽略了权值数据的分布,没有对量化损失和量化参数的内在联系进行定量分析,仅使用启

发式的量化参数设置,造成了额外的精度下降.值得注意的是:QAT 保留了 MobileNetV2 的第 1 层和最后一层数

据为全精度的浮点数,而 TQT 使用全局损失感知来学习量化参数的方法.QAT 和 TQT 没有相应的低比特位宽

的量化结果,与之对比,μL2Q 在低比特位宽时更具优势,即使在 8 比特的权值量化结果上也能得到出具有竞争

力的结果.在相同的位宽下,μL2Q 的模型精度比最新的定点数量化模型的精度平均提高 8.24%.

4.3 显著性物体检测实验

显著性物体检测旨在突出图像中显著的目标区域 [45] ,它提供了可供观测的方法依据和重要的评价指标.前

述实验结果表明,μL2Q 在 2 比特量化时能够在精度和量化位宽之间取得较好的平衡.因此,本实验选取 2 比特的

μL2Q 权值量化进行验证.

• 数据集与模型

训练集采用 MSRA10K [47] 数据集中的训练数据(占整个数据集的 80%).训练后,在多个数据集上进行评估,

包括 MSRA10K 的测试集(整个数据集的 20%)、ECSSD [47] 、HKU-IS [48] 、DUTS [49] 和 DUT-OMRRON [50] 中包含

目标对象和现有的真值图.所选数据集的详细信息见表 8.为了便于训练和测试,实验中将所有图像的大小都调

整为 224×224.实验中选择了 3 个著名的端到端语义分割模型 U-Net [51] 、LinkNet [52] 和 UNet++ [53] 进行综合比较,

[4]

其详细信息见表 9.这些模型都以 ResNet50 作为骨干网,并使用 ImageNet 数据集上训练的权值进行初始化.

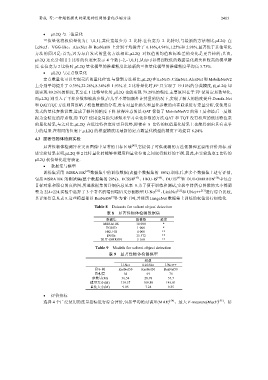

Table 8 Datasets for salient object detection

表 8 显著性物体检测数据集

数据集 图像数 难度

MSRA10K 10 000 *

ECSSD 1 000 *

HKU-IS 4 000 **

DUTs 15 572 **

DUT-OMRON 5 168 **

Table 9 Models for salient object detection

表 9 显著性物体检测模型

模型

U-Net LinkNet UNet++

骨干网 ResNet50 ResNet50 ResNet50

卷积层 64 69 76

参数量(M) 36.54 28.78 37.7

模型大小(M) 139.37 109.80 143.81

量化大小(M) 9.05 7.24 9.35

• 评价指标

选择 4 个广泛使用的度量指标进行综合评价,包括平均绝对误差(MAE) [54] 、最大 F-measure(MaxF) [55] 、结