Page 120 - 《软件学报》2021年第8期

P. 120

2402 Journal of Software 软件学报 Vol.32, No.8, August 2021

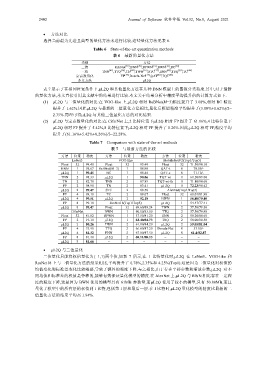

• 方法对比

选择当前最为先进且典型的量化方法来进行比较,这些量化方法见表 6.

Table 6 State-of-the-art quantization methods

表 6 最新的量化方法

类别 方法

二值 RebNet [39] ,BNN [20] ,BPWN [16] ,BWN [18] ,BC [40]

三值 TNN [41] ,TTQ [26] ,TN [42] ,TWN [16] ,STC [27] ,ENN [43] ,TSQ [30] ,TC [44]

定点数量化 FP [19] ,Dorefa-Net [17] ,QAT [22] ,TQT [23]

本文方法 μL2Q

表 7 展示了在相同位宽条件下,μL2Q 和其他量化方法在几种 DNN 模型上的图像分类精度.其中,对于最新

的量化方法,本文直接引用其文献中的结果进行比较.本文关于结果分析中精度平均提升值的计算方式如下.

(1) μL2Q 与二值量化的对比:在 VGG-like 上,μL2Q 相对 ReBNet(M=3)精度提升了 3.08%,相对 BC 精度

提升了 1.62%.因此μL2Q 与最新的二值量化方法相比,量化后模型精度平均提升了(3.08%+1.62%)/2=

2.35%.同理可得μL2Q 与其他三值量化方法的对比结果.

(2) μL2Q 与定点数量化的对比:在 CifarNet 上,2 比特位宽下μL2Q 相对 FP 提升了 61.16%,4 比特位宽下

μL2Q 相对 FP 提升了 5.42%,8 比特位宽下μL2Q 相对 FP 提升了 0.26%.因此,μL2Q 相对 FP,精度平均

提升了(61.16%+5.42%+0.26%)/3=22.28%.

Table 7 Comparison with state-of-the-art methods

表 7 与最新方法的比较

方法 位宽 精度 方法 位宽 精度 方法 位宽 精度

LeNet5 VGG-like MobileNetV2(Top1/Top5)

Float 32 99.40 Float 32 93.49 Float 32 71.30/90.10

BNN 1 98.67 ReBNet(M=3) 1 86.98 QAT-t 8 70.09/-

μL2Q 1 99.45 BC 1 88.44 QAT-c 8 71.10/-

TNN 2 98.33 μL2Q 1 90.06 TQT-wt 8 68.20/89.00

TN 2 82.70 TNN 2 87.89 TQT-wt-th 8 71.80/90.60

FP 2 98.90 TN 2 83.41 μL2Q 8 72.23/90.42

μL2Q 2 99.47 STC 2 88.58 AlexNet(Top1/Top5)

FP 4 99.10 TC 2 89.07 Float 32 60.01/81.90

μL2Q 4 99.51 μL2Q 2 92.18 BWN 1 56.80/79.40

FP 8 99.10 ResNet18(Top1/Top5) μL2Q 1 54.47/77.41

μL2Q 8 99.47 Float 32 69.60/89.24 TWN 2 57.50/79.80

CifarNet BWN 1 60.80/83.00 TTQ 2 57.50/79.90

Float 32 81.82 BPWN 1 57.50/81.20 ENN 2 58.20/80.60

FP 2 19.10 μL2Q 1 63.40/84.73 TSQ 2 58.00/80.50

μL2Q 2 80.26 TWN 2 61.80/84.20 μL2Q 2 59.05/81.04

FP 4 75.90 TTQ 2 66.60/87.20 Dorefa-Net 8 53.00/-

μL2Q 4 81.32 ENN 2 67.00/87.50 μL2Q 8 61.4/82.87

FP 8 81.40 μL2Q 2 68.11/88.13 − − −

μL2Q 8 81.66 − − − − − −

• μL2Q 与二值量化

二值量化只能将权值量化为{−1,1}两个值,如表 7 所示,在 1 比特量化时,μL2Q 在 LeNet5、VGG-like 和

ResNet18 上与二值量化方法的结果相比,平均提升了 0.78%,2.35%和 4.25%(Top1).这是因为二值量化对权值的

均值变化和标准差变化比较敏感,导致了额外的精度下降.与之相比,由于存在平移参数和缩放参数,μL2Q 对不

同均值和标准差的权值是鲁棒的,能够有效保证量化模型的精度.在 AlexNet 上,μL2Q 与 BWN 相比存在一定程

度的精度下降,这是因为 BWN 使用的模型具有 61MB 参数量,而μL2Q 使用了较小的模型,只有 50.88MB,而且

量化了模型中的所有层的权值到 1 比特,包括第 1 层和最后一层.在 1 比特时,μL2Q 量化模型的精度比最新的二

值量化方法的结果平均高 1.94%.