Page 204 - 《软件学报》2026年第1期

P. 204

高彦杰 等: 大语言模型预训练系统关键技术综述 201

大规模参数和对高效计算的需求, 与传统以单 GPU 或单机多 GPU 为中心的计算模式之间存在巨大矛盾. 这使得传

统的计算架构和系统设计难以满足当前大规模语言模型训练的需求. 在模型结构方面, 大语言模型逐渐以 Trans-

[1]

[3]

former 为核心结构. 例如, GPT 和 [2] BERT 模型通过堆叠多层 Transformer 构建, 推动系统在处理计算负载时逐步

优化对 Transformer 结构及其算子的支持. 在作业模式和实验管理方面, 深度学习负载的特征发生了显著变化. 过

去, 训练过程通常依赖于自动化机器学习和神经网络架构搜索, 以探索多样的模型超参数与结构配置. 而如今, 这一

[4]

趋势已转向以通用的大语言模型预训练结构为核心, 其特点包括: 1) Henighan 等人 指出, 模型结构相对稳定, 超

参数和结构的变化对学习性能影响有限; 2) 单次训练所需时间较长 (数天至数月), 资源消耗巨大 (需使用数百、数

千, 甚至上万个 GPU); 3) 在训练过程中, 常常面临显存溢出、执行时间过长, 以及由此引发的软硬件故障等问题.

目前, 在大语言模型系统研究领域尚缺乏系统性的综述. 本文旨在介绍和分析大语言模型预训练系统的技术

特点、分类、研究现状及热点问题, 并对其未来发展进行展望. 首先介绍和分析大语言模型的基本概念与训练流

程; 其次对大语言模型预训练技术及系统进行分类, 介绍典型的开源系统, 并探讨在扩展性、性能和可靠性等系统

设计问题上的关键技术方案; 最后对大语言模型系统的未来发展进行展望.

1 大语言模型的建模过程

1.1 大语言模型简介

大型语言模型在多个领域展现出了巨大潜力, 尤其是在跨广泛领域的专业知识中表现出色, 能够执行复杂的

任务推理, 包括专业写作、编程及求解数学题等. 在大语言模型基础上的多款应用, 例如 ChatGPT、Bard 和文心

一言等产品提供了交互式聊天界面, 实现了与用户的自然交流, 能够解答问题并完成各种任务. 大语言模型的优异

性能得益于其核心架构——基于自回归的多层堆叠 Transformer. 该模型首先在大规模文本语料上进行预训练, 随

后采用强化学习, 结合人类反馈, 使其更符合人类偏好. 尽管训练方法在表面上看起来较为直观, 但由于模型参数

庞大, 对算力和基础设施的要求极高, 因此目前仅有少数公司和科研机构具备从零开始完整训练的能力. 已公开发

[5]

[7]

[6]

布的预训练大语言模型 (如 BLOOM 、LLaMA 和 Llama 2 ) 在性能上与 GPT-3 等闭源模型相近, 但这些模型

目前仍难以替代闭源的“产品级”大语言模型, 例如 ChatGPT、Bard 和文心一言等. 这些闭源产品级大语言模型经

过未公开的严格微调, 力求更好地符合人类偏好, 从而显著提升了其可用性和安全性.

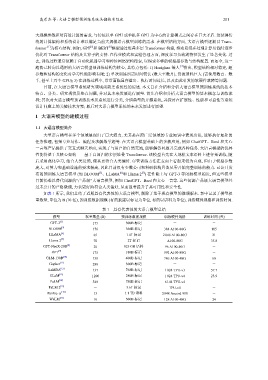

如表 1 所示, 我们总结了近期具有代表性的大语言模型, 剔除了基于现有模型的微调版本. 表中记录了模型权

重数量, 单位为 B (10 亿), 预训练数据规模 (有的披露以标记为单位, 有的以语料为单位), 训练硬件规格和训练时间.

表 1 具有代表性的大语言模型总结

模型 权重数量 (B) 预训练数据规模 训练硬件规格 训练时间 (天)

[2]

GPT-3 175 300B 标记 - -

[5]

BLOOM 176 366B 标记 384 A100-80G 105

[6]

LLaMA 65 1.4T 标记 2 048 A100-80G 21

[7]

Llama 2 70 2T 标记 A100-80G 35.8

[8]

GPT-NeoX-20B 20 825 GB 语料 96 A100-40G -

[9]

OPT 175 180B 标记 992 A100-80G -

[10]

GLM-130B 130 400B 标记 786 A100-40G 60

[11]

Gopher 280 300B 标记 - -

[12]

LaMDA 137 768B 标记 1 024 TPU-v3 57.7

[13]

GLaM 1 200 280B 标记 1 024 TPU-v4 23.9

[14]

PaLM 540 780B 标记 6 144 TPU-v4 -

[15]

PaLM 2 - 3.6T 标记 TPU-v4 -

[16]

PanGu- α 13 1.1 TB 语料 2 048 Ascend 910 -

[17]

WeLM 10 300B 标记 128 A100-40G 24