Page 205 - 《软件学报》2026年第1期

P. 205

202 软件学报 2026 年第 37 卷第 1 期

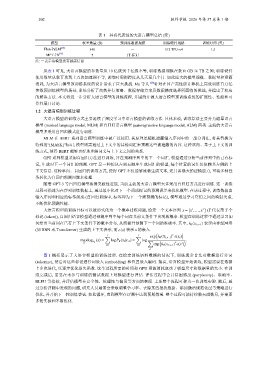

表 1 具有代表性的大语言模型总结 (续)

模型 权重数量 (B) 预训练数据规模 训练硬件规格 训练时间 (天)

[18]

Flan-PaLM 540 - 512 TPU-v4 1.5

[19]

MPT-7B 7 1T 标记 - -

注: -表示该模型没有披露信息

从表 1 可见, 大语言模型的参数量从 10 亿级到千亿级不等, 训练数据规模在数百 GB 至 TB 之间; 训练硬件

使用数量从数百块到上万块加速器不等, 训练时间则跨度从几天至几个月. 如此庞大的模型规模、数据量和资源

消耗, 为大语言模型预训练系统的设计带来了巨大挑战. Ma 等人 [20] 针对在国产高性能计算机上高效训练百万亿

参数预训练模型的场景, 系统分析了高效并行策略、数据存储方案及数据精度选择所面临的挑战, 并提出了相应

的解决方法. 本文将进一步分析大语言模型的训练流程, 并围绕开源大语言模型预训练系统的扩展性、性能和可

靠性展开讨论.

1.2 大语言模型训练过程

大语言模型的训练方式主要延续了深度学习中语言模型的训练方法. 具体来说, 训练算法主要分为遮罩语言

模型 (masked language model, MLM) 和自回归语言模型 (autoregressive language model, ALM) 两类. 主流的大语言

模型多采用自回归模式进行训练.

MLM 在 BERT 系列语言模型训练中被广泛使用. 其原理是随机遮蔽输入序列中的一部分词汇, 将其替换为

特殊的“[MASK]”标记, 模型则需通过上下文中的其他词汇来预测这些被遮蔽的内容. 这种双向、基于上下文的训

练方式, 使得 BERT 能够更好地理解词义与上下文之间的关系.

GPT 系列模型采用自回归方法进行训练, 旨在预测序列中的下一个词汇. 模型通过分析当前序列中的已有标

记, 生成对下一个词汇的预测. GPT 是一种按从左到右顺序生成词汇的模型, 每个位置的词汇仅依赖其左侧的上

下文信息. 这种单向、自回归的训练方式, 使得 GPT 不仅能够流畅生成文本, 还具备强大的建模能力, 可将多种任

务转化为自回归预测问题来处理.

随着 GPT-3 等自回归模型取得突破性进展, 当前主流的大语言模型大多采用自回归方式进行训练. 这一训练

过程可描述为在序列训练数据上, 通过最小化对下一个词或标记的预测误差来优化模型. 在该过程中, 训练数据由

输入序列和相应的标签组成 (自回归训练中, 标签即为下一个需预测的标记), 模型通过学习它们之间的映射关系,

不断优化预测性能.

大语言模型的训练目标可以被形式化为一个概率建模问题, 给定一个文本序列 x = [x ,..., x ] (T 代表第 T 个

1

T

标记 (token)), 自回归语言模型通过预测序列中每个词在其前文条件下出现的概率. 模型在训练过程中通过学习如

何给出当前词在已有上下文条件下的概率分布, 从而提升预测下一个词的准确率. 其中, h θ (x 1:t−1 ) 表示由神经网络

(如 RNN 或 Transformer) 生成的上下文表示, 而 e(x) 表示 x 的嵌入.

( )

T

exp h θ (X 1:t−1 ) e(x t )

T ∑ T ∑

maxlog (x) = logP θ (x t |x <t ) = log ∑ ( ).

T

θ P θ exp h θ (x 1:t−1 ) e(x )

′

t=1 t=1

x ′

图 1 概括展示了大语言模型的训练过程. 在给定训练语料数据的情况下, 训练通常首先对数据进行分词

(tokenize), 然后对这些标记进行词嵌入 (embedding) 和位置嵌入编码. 接着, 语言模型开始训练, 模型需要在数据

上多次迭代, 以逐步优化损失函数. 这个过程所需的时间和 GPU 资源消耗取决于模型尺寸和数据量的大小. 在训

练完成后, 需要在未参与训练的测试数据上对模型进行评估. 评估过程中会计算困惑度 (perplexity)、准确率、

BLEU 等指标, 并评估模型在安全性、伦理性与偏见等方面的表现. 上述整个流程可称为一次训练实验. 随后, 通

过分析评测中发现的问题, 研究人员通常会采取调整学习率、去除某些批次数据、添加激活规范化层等策略进行

优化, 并开始下一轮训练尝试. 如此循环, 直到模型在评测中达到预期效果. 整个过程可能持续数天或数月, 并需要

多轮实验和不断优化.