Page 208 - 《软件学报》2026年第1期

P. 208

高彦杰 等: 大语言模型预训练系统关键技术综述 205

3 预训练系统研究及相关技术

首先, 我们将介绍具有代表性的大语言模型开源预训练系统, 对 4 类系统 (语言模型系统、单一并行策略训练

系统、混合并行策略训练系统、自动并行策略搜索训练系统) 进行详细分析, 并比较它们的优缺点. 随后, 我们将

深入探讨大语言模型预训练系统在扩展性、性能和可靠性方面的问题. 为了提升系统的扩展性, 当前的研究方向

主要包括并行训练、张量重算与张量卸载, 以及混合专家模型. 在性能方面, 高效注意力机制、混合精度训练、量

化感知训练和通信优化是缓解大语言模型训练中内存、通信与计算瓶颈的关键手段. 至于可靠性方面, 工业界和

学术界目前主要关注缺陷分析、检查点机制与弹性训练.

大语言模型训练过程包括模型切片并行化、读取和嵌入数据、执行前向传播、反向传播和权重更新, 并在此

过程中执行计算内核、进行通信和保存检查点. 然而, 大语言模型训练技术面临着多个挑战. 首先, 在面向多加速

器 (GPU) 和分布式的部署环境中, 训练或微调过程需要以模型切片等方式进行部署, 以加速训练并防止内存溢出

(out of memory, OOM). 其次, 在训练过程中通常需要多次迭代来优化模型效果, 这涉及频繁访存、通信和保存检

查点等高 I/O 开销的操作. 同时, 随着数据规模的增大, 探索既能降低空间占用和浮点运算量, 又能保证算法收敛

的稀疏化技术变得至关重要. 高效注意力机制、混合精度训练等技术被提出并应用, 可以进一步提升数据读写和

计算效率. 最后, 由于训练时间较长且集群中的硬件和软件容易出现故障, 系统层面需要通过检查点和弹性训练等

手段, 以保障系统的可靠性. 本节将围绕大语言模型预训练系统, 对其在扩展性、性能和可靠性等方面的研究进行

讨论与总结.

3.1 大语言模型预训练系统

大语言模型系统的发展可以概括为 4 个阶段. 第 1 阶段以 Transformers [21] 为代表, 开始支持大语言模型及其社

区. 在这个时期, 为了支持上述模型, 所构建的一些系统一般在底层调用深度学习框架 PyTorch [22] . 随着语言模型规

模的不断增大, 在第 2 阶段出现了支持单一类型并行策略的框架, 如 Horovod [23] 、GPipe [24] 、PyTorch DDP [25] 等, 它

们支持数据并行或流水线并行. 随着模型规模的持续扩大, 单一并行策略已无法满足需求, 于是进入了第 3 阶段, 即

设计出混合并行策略. 在这一阶段, 出现了以 Megatron-LM [26] 和 DeepSpeed [27] 为代表的框架, 它们综合运用了多种

并行方案, 并对主流硬件架构和大语言模型结构进行了深度优化. 混合并行方案对开发人员的要求较高, 尤其在研

究人员尝试新的模型结构和硬件拓扑时, 需要系统工程师协助调优. 这也进一步催生了对自动并行策略搜索的需

求. 第 4 阶段随着以 Alpa [28] 为代表的自动并行策略搜索训练系统的出现. 逐渐使普通开发者能够在新的模型结构

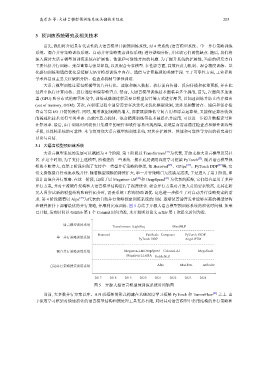

和硬件拓扑下部署最优的并行策略, 并顺利完成训练. 图 5 总结了开源大语言模型预训练系统的演化时间轴. 如果

已开源, 发布时间以 GitHub 第 1 个 Commit 时间为准, 未开源则以论文 arXiv 第 1 次提交时间为准.

语言模型训练系统

Transformers LightSeq MindNLP

Horovod FairScale Composer PyTorch FSDP

单一并行策略训练系统

PyTorch DDP Angel-PTM

混合并行策略训练系统 Megatron-LM DeepSpeed Colossal-Al MegaScale

Megatron-LLaMA PaddleNLP

自动并行策略搜索训练系统 Alpa MaxText nnScaler

2017 2018 2019 2020 2021 2022 2023 2024

图 5 开源大型语言模型预训练系统时间轴图

当前, 大多数并行方案以库、API 或框架的形式构建在基础深度学习框架 PyTorch 和 TensorFlow [29] 之上. 由

于深度学习框架对快速演化的语言模型结构和预处理工具支持有限, 同时其对语言模型中常用结构的并行策略和