Page 260 - 《软件学报》2025年第12期

P. 260

童翰文 等: 带有差异化机制的多视角归纳式知识图谱补全框架 5641

方法与一些交互式编码器架构的基线模型相比, 例如 KG-BERT, 推理速度是显著更快的. 更重要的是, 本文方法也

超越了其他被公认为高效的、表示式编码器架构的基线模型, 例如 BLP 和 StATIK. 这些都进一步证明了本文框

架的推理高效性.

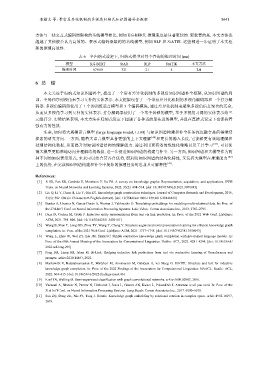

表 6 半归纳式设定下, 归纳式模型对每个查询的推理时间 (ms)

模型 KG-BERT StAR BLP StATIK 本文方法

推理时间 87 000 321 21 4 2.8

6 总 结

本文关注于归纳式知识图谱补全, 提出了一个带有差异化机制的多视角知识图谱补全框架, 从知识图谱的局

部、全局和序列视角来学习互补的实体表示. 本文框架包含了一个带有差异化机制的多视角编码器和一个打分解

码器. 多视角编码器使用了 1 个预训练语言模型和 3 个编码模块, 通过差异化机制来避免多视角信息聚合的冗余,

从而从多视角学习到互补的实体表示. 打分解码器使用了一个基于转移的模型, 基于多视角习得的实体表示给三

元组打分. 实验结果表明, 本文方法在归纳式设定下超越了各种当前最先进的模型, 并且在直推式设定下也保持着

强有力的性能.

未来, 如何将大规模语言模型 (large language model, LLM) 与知识图谱构建和补全任务深度融合是值得继续

探索的研究方向. 一方面, 随着大语言模型具备更强的上下文理解 [40] 和更长的输入长度, 它能够更有效地理解和

处理结构化数据, 从而提升对知识图谱结构的理解能力. 通过利用更有效的线性化策略以及工具学习 [41] , 可以使

得大模型更精准地访问并理解结构数据, 进一步促进知识图谱的构建与补全. 另一方面, 知识图谱和大模型作为两

种不同的知识表示形式, 未来可以结合其各自优势, 既利用知识图谱的结构化特性, 又发挥大模型在推理能力 [42]

上的优势, 在完成知识图谱构建和补全中复杂的推理任务时也兼具可解释性 [43] .

References:

[1] Ji SX, Pan SR, Cambria E, Marttinen P, Yu PS. A survey on knowledge graphs: Representation, acquisition, and applications. IEEE

Trans. on Neural Networks and Learning Systems, 2022, 33(2): 494–514. [doi: 10.1109/TNNLS.2021.3070843]

[2] Liu Q, Li Y, Duan H, Liu Y, Qin ZG. Knowledge graph construction techniques. Journal of Computer Research and Development, 2016,

53(3): 582–600 (in Chinese with English abstract). [doi: 10.7544/issn1000-1239.2016.20148228]

[3] Bordes A, Usunier N, Garcia-Durán A, Weston J, Yakhnenko O. Translating embeddings for modeling multi-relational data. In: Proc. of

the 27th Int’l Conf. on Neural Information Processing Systems. Lake Tahoe: Curran Associates Inc., 2013. 2787–2795.

[4] Daza D, Cochez M, Groth P. Inductive entity representations from text via link prediction. In: Proc. of the 2021 Web Conf. Ljubljana:

ACM, 2021. 798–808. [doi: 10.1145/3442381.3450141]

[5] Wang B, Shen T, Long GD, Zhou TY, Wang Y, Chang Y. Structure-augmented text representation learning for efficient knowledge graph

completion. In: Proc. of the 2021 Web Conf. Ljubljana: ACM, 2021. 1737–1748. [doi: 10.1145/3442381.3450043]

[6] Wang L, Zhao W, Wei ZY, Liu JM. SimKGC: Simple contrastive knowledge graph completion with pre-trained language models. In:

Proc. of the 60th Annual Meeting of the Association for Computational Linguistics. Dublin: ACL, 2022. 4281–4294. [doi: 10.18653/v1/

2022.acl-long.295]

[7] Peng BH, Liang SH, Islam M. Bi-Link: Bridging inductive link predictions from text via contrastive learning of Transformers and

prompts. arXiv:2210.14463, 2022.

[8] Markowitz E, Balasubramanian K, Mirtaheri M, Annavaram M, Galstyan A, ver Steeg G. StATIK: Structure and text for inductive

knowledge graph completion. In: Proc. of the 2022 Findings of the Association for Computational Linguistics: NAACL. Seattle: ACL,

2022. 604–615. [doi: 10.18653/v1/2022.findings-naacl.46]

[9] Kipf TN, Welling M. Semi-supervised classification with graph convolutional networks. arXiv:1609.02907, 2016.

[10] Vaswani A, Shazeer N, Parmar N, Uszkoreit J, Jones L, Gomez AN, Kaiser Ł, Polosukhin I. Attention is all you need. In: Proc. of the

31st Int’l Conf. on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

[11] Sun ZQ, Deng ZH, Nie JY, Tang J. RotatE: Knowledge graph embedding by relational rotation in complex space. arXiv:1902.10197,

2019.