Page 257 - 《软件学报》2025年第12期

P. 257

5638 软件学报 2025 年第 36 卷第 12 期

选实体排序时, 训练集、验证集和测试集中其他所有正确的三元组的分数都会被忽略掉, 从而防止自动化指标对

于一些正确预测的误判. 而且, 所有汇报的指标都是取的头实体预测和尾实体预测, 两个预测方向下指标的平均.

由于让 ChatGPT 像本文方法一样对知识图谱中所有的实体做排序是不现实的, 本文按照现有工作 [34] 中的设定, 随

机采样了 25 个测试样例, 并且仅汇报了 Hits@1 指标.

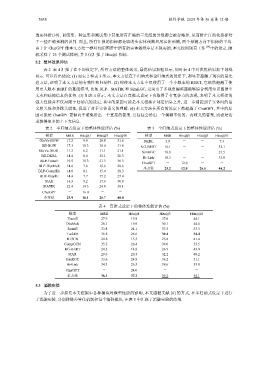

5.2 整体效果评估

表 2–表 4 汇报了在不同设定下, 所有方法的整体效果, 最优结果加粗显示, 同时表 4 中对次优结果加下划线

显示. 可以得出结论: (1) 如表 2 和表 3 所示, 本文方法在半归纳式和全归纳式的设定下, 都显著超越了现有的最先

进方法, 证明了本文方法的有效性和归纳性. (2) 即使本文方法中仅使用了一个小版本的 BERT, 它依然超越了使

用更大版本 BERT 的基线模型, 比如 BLP、StATIK 和 SimKGC. 这突出了多视角编码器能够综合利用知识图谱中

文本和结构信息的优势. (3) 如表 4 所示, 本文方法在直推式设定下也取得了有竞争力的表现, 表明了本文框架的

强大性能并不仅局限于归纳式的设定. 其中的原因可能是本文框架在邻居信息之外, 进一步捕捉到了实体间的语

义相关性和多跳关联性, 促进了对于实体语义的理解. (4) 本文方法在所有的设定下都超越了 ChatGPT, 其中的原

因可能是 ChatGPT 更倾向于避免给出一个直接的答案. 它往往会给出一个模糊不清的、有歧义的答案, 或者是请

求获得更多的上下文信息.

表 2 半归纳式设定下的整体性能评估 (%) 表 3 全归纳式设定下的整体性能评估 (%)

模型 MRR Hits@1 Hits@3 Hits@10 模型 MRR Hits@1 Hits@3 Hits@10

GloVe-BOW 17.2 9.9 18.8 31.6 DKRL 3.9 - - 7.3

BE-BOW 17.3 10.3 18.4 31.6 KG-BERT 16.1 - - 32.1

GloVe-DKRL 11.2 6.2 11.1 21.1

SimKGC 10.0 - - 21.5

BE-DKRL 14.4 8.4 15.1 26.3

Bi-Link 18.3 - - 33.8

BLP-TransE 19.5 11.3 21.3 36.3

ChatGPT - 12.0 - -

BLP-DistMult 14.6 7.6 15.6 28.6

本方法 23.2 12.9 25.5 46.2

BLP-ComplEx 14.8 8.1 15.4 28.3

BLP-SimplE 14.4 7.7 15.2 27.4

StAR 16.3 9.2 17.6 30.9

StATIK 22.4 14.3 24.8 38.1

ChatGPT - 16.0 - -

本方法 23.9 16.1 25.7 40.0

表 4 直推式设定下的整体性能评估 (%)

模型 MRR Hits@1 Hits@3 Hits@10

TransE 27.9 19.8 37.6 44.1

DistMult 28.1 19.9 30.1 44.6

RotatE 33.8 24.1 37.5 53.3

TuckER 35.8 26.6 39.4 54.4

R-GCN 24.8 15.3 25.8 41.4

CompGCN 35.5 26.4 39.0 53.5

KG-BERT 24.2 14.8 26.9 43.0

StAR 29.6 20.5 32.2 48.2

SimKGC 33.6 24.9 36.2 51.1

Bi-Link 34.3 26.5 38.6 53.8

ChatGPT - 24.0 - -

本方法 36.1 27.2 39.2 54.1

5.3 消融实验

为了进一步探究本文框架中各种模块对模型性能的影响, 本文遵循文献 [8] 的方式, 在半归纳式设定下进行

了消融实验, 分别移除差异化机制和每个编码模块, 在表 5 中汇报了消融实验的结果.