Page 252 - 《软件学报》2025年第12期

P. 252

童翰文 等: 带有差异化机制的多视角归纳式知识图谱补全框架 5633

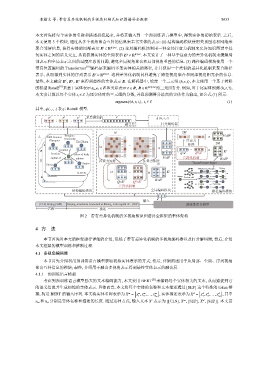

本文首先将每个实体的名称和描述拼接起来, 并将其输入到一个预训练语言模型中, 得到实体的初始表示. 之后,

本文使用 3 个模块, 通过从多个视角聚合互补的信息来丰富实体的表示: (1) 结构编码模块使用关系图卷积网络来

l

E ∈ R |E|×d . (2) 全局编码模块利用一种全局注意力机制来允许知识图谱中任

聚合邻居信息, 获得实体的局部表示

g

何实体之间的语义交互, 从而获得实体的全局表示 E ∈ R |E|×d . 本文设计了一种基于注意力的差异化机制来缓解局

部表示和全局表示之间的过度注意的问题, 避免全局视角聚合和局部视角重叠的信息. (3) 路径编码模块使用一个

带有位置编码的 Transformer [10] 编码层来编码多条实体相关的路径, 并且使用一个类似的差异化机制来聚合路径

s

表示, 从而得到实体的序列表示 E ∈ R |E|×d . 这种差异化机制同样避免了路径视角聚合和局部视角相冗余的信息.

g

s

l

,

最终, 本文融合 E E , E 来得到最终的实体表示 E. 在解码器中, 给定一个三元组 (h,r,t), 本文使用一个基于转移

的模型 RotatE 来基于实体表示 e h ,e t ∈ E 和关系表示 r ∈ R, R ∈ R |R|×3d 给三元组打分. 例如, 对于尾实体预测 (h,r,?),

[11]

本文会计算以每个实体 t i ∈ E 为尾实体时的三元组的分数, 并且预测得分最高的实体作为输出, 如公式 (1) 所示:

argmaxϕ(h,r,t i ), t i ∈ E (1)

其中, ϕ(·,·,·) 表示 RotatE 模型.

e l e g e s 多层感知机 e ϕ (h, r, t)

; ;

融合层 打分解码器

|ε| 2M

L 2008 Summer Tsinghua − V=H p

Olympics University 注意力

Ziyi Zhang 2M

− 矩阵

|ε|

location − K ⊥

d

location place of birth q=e t q =e l

capital of adjoins V=E t 差异化机制 K=H p

Beijing

注意力矩阵 注意力矩阵

Tianjin |ε| Transformer layer

China

1928 Summer Olympics Beijing

|ε| K ⊥

R-GCN United States of America China M

Beijing

Random walk

K=E t 2008 Summer Olympics Australia

d

Q=E t Q =E l

M Beijing Swimming

差异化机制

结构编码模块 全局编码模块 路径编码模块

e t

输入

[CLS] Beijing [SEP] Beijing, sometimes romanized as Peking, is the capital of... [SEP] 预训练语言模型

名称 描述

图 2 带有差异化机制的多视角知识图谱补全框架的整体架构

4 方 法

本节首先对本文的框架进行详细的介绍, 包括了带有差异化机制的多视角编码器以及打分解码器; 然后, 介绍

本文框架的模型训练和推断过程.

4.1 多视角编码器

本节首先介绍利用预训练语言模型获取初始实体表示的方式; 然后, 详细阐述用于从局部、全局、序列视角

聚合互补信息的模块; 最终, 介绍用于融合多视角表示得到最终实体表示的融合层.

4.1.1 预训练语言模型

考虑到预训练语言模型强大的文本编码能力, 本文使用 BERT [21] 来编码每个实体相关的文本, 从而捕捉到它

的语义信息并生成初始的实体表示. 具体而言, 本文将每个实体的名称和文本描述通过 [SEP] 这个特殊的 token 拼

[ ] [ ]

接, 构造 BERT 的输入序列. 本文将实体名称表示为 X = x , x ,..., x m n m , 实体描述表示为 X = x , x ,..., x d n d , 其中

d

d

d

m

m

m

2

1

2

1

d

m

′

n m 和 n d 分别是实体名称和描述的长度. 通过这种方式, 输入文本 X 表示为 [[CLS], X , [SEP], X , [SEP]]. 本文首