Page 258 - 《软件学报》2025年第12期

P. 258

童翰文 等: 带有差异化机制的多视角归纳式知识图谱补全框架 5639

从表 5 中可见: 首先, 移除差异化机制造成了严重的模型性能下降, 证明了它在避免过度注意问题以及鼓励各

种视角学习有区别的实体表示时的有效性; 其次, 移除任何的编码模块都导致了模型性能的下降, 表明从各个视角

学习到的实体表示都是必要的.

5.4 差异化机制的可视化

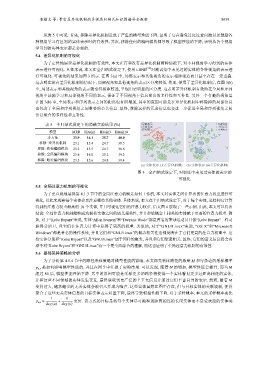

为了定性地展示差异化机制的有效性, 本文在有和没有差异化机制两种情况下, 对不同视角学习得到的实体

表示进行可视化. 具体来说, 本文在全归纳式设定下, 使用 t-SNE [39] 对测试集中未见过的实体的各种视角的表示进

行可视化. 可视化的结果如图 3 所示. 在图 3(a) 中, 局部表示和其他视角的表示相距很近而且甚至存在一定重叠.

这表明在没有差异化机制的情况下, 局部视角和其他视角的表示区分度较低. 然而, 使用了差异化机制后, 在图 3(b)

中, 局部表示和其他视角的表示就变得相距较远, 呈现出更明显的区分度. 这表明差异化机制有效地在全局和序列

视角中鼓励学习和局部视角不同的表示, 保证了不同视角下信息聚合的多样性和互补性. 另外一个有趣的现象是

在图 3(b) 中, 全局表示和序列表示之间的距离也有所增加, 其中的原因可能是在差异化机制中移除掉的局部信息

也包含了全局和序列视角之间重叠的公共信息. 最终, 移除这样的冗余信息也会进一步促进全局和序列视角之间

信息聚合的多样性和互补性.

表 5 半归纳式设定下的消融实验结果 (%) 局部表示 局部表示

全局表示 全局表示

序列表示 序列表示

模型 MRR Hits@1 Hits@3 Hits@10

本方法 23.9 16.1 25.7 40.0

移除: 差异化机制 23.1 15.4 24.7 38.5

移除: 结构编码模块 23.2 15.5 24.7 38.8

移除: 全局编码模块 23.6 16.0 25.2 39.2

移除: 路径编码模块 23.3 15.6 24.8 39.4

(a) 实体表示 (无差异化机制) (b) 实体表示 (有差异化机制)

图 3 全归纳式设定下, 对训练中未见过实体的表示的

可视化

5.5 全局注意力机制的可视化

为了更直观地展现第 4.1.3 节中的全局注意力机制是如何工作的, 本文对实体之间计算出的注意力权重进行可

视化, 以此来观察每个实体会更注意哪些其他实体. 具体来说, 本文在半归纳式设定下, 对于每个实体, 选择和它计算

得到的注意力权重最高的 10 个实体, 并且可视化它们的注意力权重. 后文图 4 展现了一些示例. 由此, 本文可以得出

结论: 全局注意力机制能够成功捕获实体之间的语义相关性, 并且会给概念上相关的实体赋予更高的注意力权重. 例

如, 对于“Kobe Bryant”来说, 实体“Allen Iverson”和“Dwyane Wade”都是著名的篮球运动员且像“Kobe Bryant”一样司

职得分后卫, 且它们在注意力计算中获得了更高的权重. 类似地, 对于“GNU/Linux”来说, “OS X”和“Microsoft

Windows”都是著名的操作系统, 并且它们和“GNU/Linux”的概念相关性也都反映在了它们更高的注意力权重中. 这

些实体分别和“Kobe Bryant”以及“GNU/Linux”属于同样的概念, 并且和它们紧密相关. 最终, 它们的语义信息将会有

助于对“Kobe Bryant”和“GNU/Linux”有一个更全面综合的理解, 而这也证明了全局注意力机制的有效性.

5.6 路径采样策略的分析

为了分析第 4.1.4 节中的路径采样策略对模型性能的影响, 本文探究采样路径的数量 M 和每条边的采样概率

p u,v 是如何影响模型性能的, 并且在图 5 中汇报了实验结果. 可以发现, 随着 M 的增加, 模型性能会提升; 而当 M

超过 80 后, 模型性能开始下降. 其中的原因可能是采样更多的路径将使得一个实体看见更多远距离相连的实体,

并和这些不同领域的实体发生交互, 最终获取到更广泛的上下文信息并通过它们丰富自身的表示. 然而, 随着 M

变得过大, 越来越多的无关实体会被引入并成为噪声. 这些实体虽然在图中存在, 但与目标实体的关联较弱, 使得

聚合了这些无关实体信息的目标实体表示质量下降, 最终导致模型性能下降. 对于采样概率, 本文的采样概率要比

1 1

p u,v ∝ + 更好. 该方式的目标是将每个实体尽可能和远距离相连的长尾实体而不是受欢迎的实体关

deg(u) deg(v)