Page 185 - 《软件学报》2025年第5期

P. 185

杨尚东 等: 基于分组对比学习的序贯感知技能发现 2085

的中心 ¯ z k . 对所有技能重复上述过程, 则最终得到 K 个技能表征中心 (¯z 1 ,¯z 2 ,...,¯z K ) .

k

用采样阶段的 K 组相似轨迹对应的奖励轨迹均值 ¯ ρ k , 计算第 、 p 种技能表征的相似度 w k,p , 来区分技能表

征中心 ¯ z k 的正负样本. 将与第 k 种技能表征相似度高的技能表征对应的分组轨迹视作正样本, 使它们与 ¯ z k 相似; 相

似度低的技能表征对应的分组轨迹视作负样本使它们与 ¯ z k 不同. 另外, 在计算损失时以它们的相似度作为权重. 我

们借鉴了文献 [31] 的损失函数, 并对其做出了改进, 使其能够满足上述要求. 损失函数 L η 如下:

1 ∑ K

L η = l η (k)

K k=1

∑

K

l η (k) = l η (k, p)

p=1 (1)

c m

∑

1 M e k,p /κ

l η log ∑ ∑

(k, p) = −w k,p

K M

M m=1 c m /κ

e k,p

u=1 m=1

⊤ ∑ M ⊤ 1 ∑ M

¯ z z p,m ( ) ¯ ρ ¯ρ p m

k

k

m

k

其中, c =

, ¯ z k = m=1 z k,m z k,m = e η τ k,m ,w k,p =

, ¯ ρ k = M m=1 ρ . 其中, ¯ z k 表示第 种技能表

,

k,p

k

∥¯z k ∥

z p,m

∥¯ρ k ∥

¯ρ p

m m 条分组轨迹对应的轨

征的中心, τ k,m 表示从第 k 种技能轨迹回放缓存 B k 中取出的第 m 条分组轨迹, ρ 表示上述

k

迹奖励. 本文认为该优化目标 (1) 是定义 2 中技能发现目标的一种直接近似.

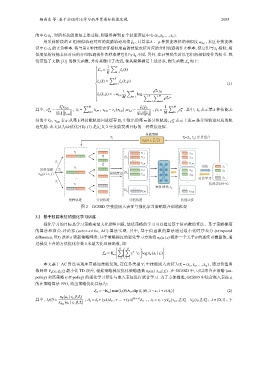

技能策略

→ - -

i → → z i =(z i 1 , z i 2 ) 序贯组合

π θ (a | s, g , z i )

τ 1

τ 1,1 z 1,1

1

τ 1 τ 1,2

1 z 1,2

… …

1 τ 1, M z 1, M

2

τ 1 -

均值 z 1

采样策略 2 τ 2 τ 2,1 z 2,1 -

→ z 2

π ran (a | s, g ) 相似度量 2 …

… τ 2,2 z 2,2 -

… … … 对比学习 z K

…

I … …

τ I 技能表征中心

… 表征网格 e η …

K

τ K, M

z K, M

采样轨迹 分段轨迹 分组轨迹 技能表征

图 2 GCSSD 中技能嵌入表征与强化学习策略联合训练框架

3.2 基于技能表征的强化学习训练

强化学习的目标是学习策略来最大化期望回报, 最优策略的学习可以通过基于值函数的算法、基于策略梯度

的算法和演员-评论家 (actor-critic, AC) 算法实现. 其中, 基于值函数的算法通过最小化时序差分 (temporal

θ

difference, TD) 误差 δ 更新策略网络; 基于策略梯度的强化学习方法将 π θ (a | s) 视作一个关于 的连续可微函数, 通

过梯度上升的方法优化参数 θ 来最大化目标函数, 即:

H H

∑ ∑

r t ′ logπ θ (a t | s t ) .

γ t ′ −t

L θ = E π θ

t=0 t ′ =t

本文基于 AC 算法实现序贯感知技能发现, 在任务类型 T i 中技能嵌入表征为 ⃗z i = (z i 1 ,z i 2 ,...,z i N ) , 通过价值函

数网络 V φ (s t ,⃗ g,⃗z i ) 最小化 TD 误差, 根据策略梯度优化策略函数 π θ (a t | s t ,⃗ g,⃗z i ) . 在 GCSSD 中, 可以结合在策略 (on-

policy) 和离策略 (off-policy) 的强化学习算法与嵌入表征进行联合学习. 为了方便描述, GCSSD 中结合嵌入表征 ⃗z i

的在策略算法 PPO, 给出策略优化目标为:

[ ( )]

L θ = −E π θ min l t (θ)A t ,clip(l t (θ),1−ε,1+ε)A t (2)

( )

π θ a t | s t ,⃗ g,⃗z i H−t+1 ( ) ( )

其中, l t (θ) = ( ) , A t = δ t +(γλ)δ t+1 +...+(γλ) δ H−1 δ t = r t +γV φ s t+1 ,⃗ g,⃗z i −V φ s t ,⃗ g,⃗z i , λ ∈ [0,1] , 下

,

π θ old a t | s t ,⃗ g,⃗z i