Page 189 - 《软件学报》2025年第5期

P. 189

杨尚东 等: 基于分组对比学习的序贯感知技能发现 2089

● SAC 是一种高效、稳定且能够学习最大熵策略的强化学习算法 [16] . 其核心思想是学习一个最大熵策略, 该

策略在执行动作时尽可能地探索状态空间, 从而最大化总体回报.

● OC 是一种经典的基于抉择框架的技能强化学习算法 [18] . 在 OC 中, 智能体可以选择执行一组原子动作的序

列. 每个抉择由一个策略和一个价值函数组成. 在执行抉择时, 智能体可以在一段时间内执行该抉择中定义的原子

动作序列, 以实现一定的目标.

● ROC 是对 OC 方法的一种改进, 与 RPPO 算法一样, 使用循环神经网络 (RNN) 来表示策略函数 [46] , 从而更

好地处理长期依赖性, 是提升 OC 方法处理多任务环境的一种常用方式.

4.2.2 参数设置

● 在网格世界中, 将轨迹分为两段, 则训练阶段任务类型 T 1 的前半段需靠近红色目标两次, 后半段需躲避绿

T 2 的前半段需躲避绿色目标两次, 后半段需靠近红色目标两次. 则该两种任务类

色目标两次; 训练阶段任务类型

型中存在两种技能, 即靠近红色目标两次、躲避绿色目标两次. 同理, 任务类型 T 3 、 T 4 也存在两种技能, 即先躲

避绿色目标再靠近红色目标、先靠近红色目标再躲避绿色目标. 则训练任务的技能集合共 4 种. 另外, 测试阶段所

用到的技能是训练阶段技能的子集.

在本实验中, 状态 s 为智能体当前所处网格中位置的横坐标与纵坐标 (x,y) , 目标向量为 ⃗ g = (g 1 ,g 2 ,g 3 ,g 4 ,g f ) ,

g i = (x i ,y i ) , i = 1,2,3,4 和 f 分别表示 4 个目标及终点的横、纵坐标. 技能表征 ⃗z i = (z i 1 ,z i 2 ) , 其中 z i 1 、z i 2 均设为

2 维. 动作 a 是使智能体向上/下/左/右移动一格. 技能策略 π θ 采用 LSTM 网络, 输入维度为 16 (忽略 LSTM 网络中

隐表示的维度), 输出维度为 4. 技能表征网络 e η 采用全连接网络, 则输入维度为 40, 输出维度为 2. 实验参数如表 1 所示.

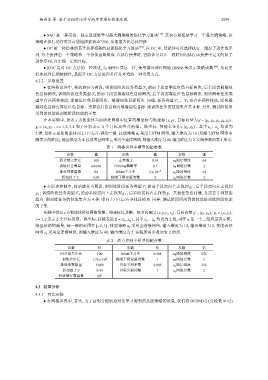

表 1 网格世界中模型的超参数

参数 值 参数 值 参数 值

回合最大步长 100 A t 参数 λ 0.95 π θ 隐层维度 64

训练回合数量 60 000 Clipping截断率 0.1 π θ 网络层数 2

批处理数据量 64 Adam学习率 5×10 −4 e η 隐层维度 64

γ 梯度下降更新次数 e η 网络层数

折扣因子 0.99 2 2

g 1 , 后半段需向左走找到

● 在质点控制中, 将轨迹分为两段, 则训练阶段任务类型 T 1 的前半段需向上走找到

g 2 ; 训练阶段任务类型 T 2 的前半段需向上走找到 g 1 , 后半段需向右走找到 g 2 . 其他任务也同理, 各需要 2 种技能

组合. 则训练任务的技能集合为 4 种, 即向上/下/左/右寻找目标点. 同样, 测试阶段所用到的技能是训练阶段技能

的子集.

,

实验中状态 s 为智能体所处网格的横、纵坐标以及横、纵方向速度 (x,y,v x ,v y ) , 目标向量 ⃗ g = (g 1 ,g 2 ) g i = (x i ,y i ) ,

i = 1,2 表示 均设为 a 是一个二维向量表示横、

2 个目标的横、纵坐标. 技能表征

⃗z i = (z i 1 ,z i 2 ) , 其中 z i 1 、z i 2 2 维. 动作

纵坐标的增减量, 每一维的范围在 [−1,1] . 技能策略 π θ 采用全连接网络, 输入维度为 12, 输出维度为 2. 技能表征

e η 采用全连接网络, 则输入维度为 40, 输出维度为 2. 实验所用参数如表 2 所示.

网络

表 2 质点控制中模型的超参数

参数 值 参数 值 参数 值

回合最大步长 100 Adam学习率 0.001 π θ 隐层维度 256

训练总步长 1.75×10 5 梯度下降更新次数 1 π θ 网络层数 2

批处理数据量 5 000 目标平滑系数 0.005 e η 隐层维度 256

γ 目标更新间隔 e η 网络层数

折扣因子 0.99 1 2

回放缓存数据量 10 6 - - - -

4.3 结果分析

4.3.1 对比实验

● 在网格世界中, 首先, 为了证明分组轨迹对比学习得到的技能策略的效果, 我们将 GCSSD-2 (分段数 N =2)