Page 182 - 《软件学报》2025年第5期

P. 182

2082 软件学报 2025 年第 36 卷第 5 期

2 问题定义

在本节中, 主要介绍本文研究的稀疏奖励下的多目标导向强化学习问题定义. 在介绍该定义之前, 首先介绍强

化学习的定义, 及强化学习中技能定义与技能发现的求解目标.

2.1 强化学习

在强化学习中, 智能体的目标是在训练阶段通过与未知环境的交互, 学习到一个可以获得最高累计奖励的策

略, 这个交互过程可形式化地定义为马尔可夫决策过程 (Markov decision process, MDP). 与之前基于技能的强化学

习研究 [18] 类似, 本文研究无限视界带折扣的 MDP (infinite discounted MDP), 我们先给出该 MDP 的基本定义和相

关的符号解释. 之后, 再给出技能定义和本文要解决的具体任务.

定义 1. 马尔可夫决策过程 (MDP). MDP 可以用五元组 ⟨S,A,R,T,γ⟩ 描述, 其中, S 是包含 |S| 个状态的状态空

T : S×A×S → [0,1] 是

间, A 是包含 |A| 个可选动作的动作空间, R : S×A×S → R 是产生即时奖励的奖励函数,

状态转移函数, γ ∈ [0,1) 是折扣因子.

对于一个具体的强化学习任务而言, 在一个回合 (episode) 开始前, 智能体位于初始状态 s 0 , 在第 个时间步,

t

智能体根据策略 π t : S×A → [0,1] 和当前状态 s t 选择并执行动作 a t , 环境接收到动作后以 T(s t ,a t , s t+1 ) = P(s t+1 | s t ,a t )

的概率转移到下一个状态 s t+1 , 智能体获得即时奖励 r t = R(s t ,a t , s t+1 ) . 智能体的目标是找到一个最大化累计奖励的

最优策略:

[∑ ∞ ]

π = argmaxE γ ·r t | π .

t

∗

π t=0

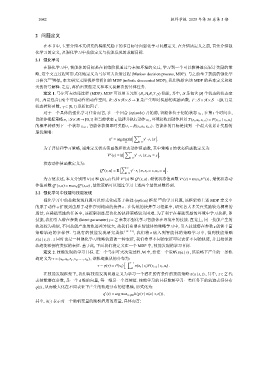

为了评估和学习策略, 通常定义状态值函数和状态动作值函数, 其中策略 π 的状态值函数定义为:

[∑ ∞ ]

π

t

V (s) = E γ ·r t | π, s 0 = s .

t=0

状态动作值函数定义为:

[∑ ∞ ]

π

t

Q (s,a) = E γ ·r t | π, s 0 = s,a 0 = a .

t=0

π π V (s) = max π V (s) , 最优状态动

π

∗

为方便表述, 本文分别用 V(s) 和 Q(s,a) 代替 V (s) 和 Q (s,a) . 最优状态值函数

π

∗

作值函数 Q (s,a) = max π Q (s,a) , 最优策略可以通过学习上述两个最优函数得到.

2.2 强化学习中技能与技能发现

强化学习中的技能发现问题可以形式化成基于抉择 (option) 框架 [17] 的学习问题, 该框架将上述 MDP 定义中

o . 在传统的抉择学习框架中, 研究者大多关注奖励较为稠密的

的原子动作 a 扩展到由原子动作序列构成的抉择

场景, 在稀疏奖励的任务中, 该框架训练层次化的抉择策略较为困难. 为了利于在稀疏奖励的环境中学习抉择, 即

技能, 我们引入潜在参数 (latent parameter) z ∈ Z 来表示强化学习智能体在环境中的技能. 直觉上, 同一技能产生的

z 能够丰富

轨迹较为类似, 不同技能产生的轨迹差异较大, 故我们希望在智能体的策略学习中, 引入技能潜在参数

策略轨迹的多样性. 与现有的技能发现研究类似 [19−23] , 我们将 z 嵌入到智能体的策略学习中, 得到技能策略

π(a | s,z) z 同时也是一种强化学习策略轨迹的一种表征, 我们希望不同的表征可以表征不同的轨迹, 并且相似的

.

轨迹能够拥有类似的表征. 基于此, 下面我们将定义在一个 MDP 中, 技能发现的学习目标.

定义 2. 技能发现的学习目标. 在一个马尔可夫决策过程 M 中, 给定一个策略 π(a | s) , 该策略下产生的一条轨

迹定义为 τ = (s 0 ,a 0 ,r 1 , s 1 ,..., s H ) , 该轨迹服从的分布为:

∏ H−1

τ ∼ p(τ) = P(s 0 ) π(a t | s t )P(s t+1 | s t ,a t ) .

t=0

在技能发现框架下, 我们将技能发现问题定义为学习一个潜在的有条件的技能策略 π(a | s,z) , 其中, z ∈ Z 代

d 维的向量, 每一维是一个连续值. 技能学习的目标能够学习一类任务下的轨迹表征分布

表技能潜在参数, 是一个

q(z) , 从而最大化在不同表征下产生的轨迹分布的信息熵, 形式化为:

q (z) = argmax z∼q(z) h(p(τ | π(a | s,z))),

∗

其中, h(·) 表示对一个随机变量的随机程度的度量, 具体而言: