Page 181 - 《软件学报》2025年第5期

P. 181

杨尚东 等: 基于分组对比学习的序贯感知技能发现 2081

策略网络实现序贯技能策略的训练和高效利用.

(3) 实验结果表明, 在离散和连续控制任务中, 所提算法可以有效表征强化学习一个回合内的多种技能, 并且

能够在测试任务实现对技能序贯组合.

本文第 1 节介绍强化学习中技能发现的相关方法和研究现状. 第 2 节介绍本文所要解决的问题定义, 主要为

稀疏奖励下的多目标导向强化学习. 第 3 节介绍本文提出的基于分组对比学习的序贯感知技能发现方法 GCSSD.

第 4 节通过在典型场景中的实验验证了所提方法的有效性. 最后总结全文.

1 相关工作

在本节中, 我们主要介绍和本文研究内容相关的研究工作.

● 基于抉择框架的分层强化学习. 为了促进长期行为的学习, 在基于抉择的框架 [17,18] 中, 智能体可以在一个回

合中在不同抉择之间切换, 其中抉择通过带有终止条件的策略转换为动作序列. 基于抉择的分层强化学习建模

MDP 中的层次结构 [24−27] . 对于典型的两级层次结构, 较高级别的策略产生抉择, 较低级别的策略输出原子动作. 然

而, 这方法面对稀疏奖励任务适用性较弱, 且问题设定较为简单, 他们在固定的环境中学习技能, 每个回合目标相

对固定. 当面临多任务中不断变化的环境动态时, 他们必须手动设计辅助子任务学习抉择.

● 基于技能发现的强化学习. 针对稀疏奖励的强化学习任务, 技能发现方法从智能体轨迹信息中发现技能. 其

中, DIAYN [19] 和 VIC [28] 通过最大化轨迹与其相应技能之间的互信息来学习技能. VALOR [22] 通过最大化抉择的概

率来学习抉择, 并给出其结果观察轨迹. DADS [20] 通过最大化智能体执行动作后的状态和技能表征之间的互信息

学习技能. 这些方法在一个回合内具有一种技能时, 学习效果较好, 但对于一个回合内存在多个目标, 导致一个回

合内存在序贯技能组合的任务, 这类方法存在不足.

● 对比学习. 对比学习是一种自监督的学习方法, 旨在从无标注的数据中学习特征表示, 并用于下游类似任务

中. 近年来, CPC [29] 、MoCo [30] 、SimCLR [31] 、SimSiam [32] 和 BYOL [33] 等对比学习方法在计算机视觉领域取得了许

多成功. 本文参考 SimCLR 中的损失函数, 因其是一种简单有效的框架. 尽管有许多新的工作来改进 SimCLR, 但

我们仍然选择了 SimCLR 作为本文对比学习的框架, 因为我们的目的不在于改进对比学习本身, 我们参考了

SimCLR 的核心的对比损失构建部分.

● 目标导向强化学习. 本文研究目标导向强化学习 [34] , 在该问题中, 智能体很少获得奖励. 目标导向的强化学习

中, 智能体的目标是学习一个在给定状态和目标的联合输入下的最优策略, 并在诸多工作了开展了相关研究 [35−38] . 尽

管提出了一些重新标记 [39] 等技术来解决学习目标导向强化学习中的稀疏奖励问题, 但在一些大规模决策任务中, 学

习上述目标导向的强化学习策略仍然存在挑战 [40] . 本文参考 UVFA [35] , 将目标与状态联合作为强化学习策略输入.

● 稀疏奖励强化学习. 稀疏奖励强化学习一直是一个热点的研究领域, 研究人员通过分层建模 [24−27] 或鼓励探

索 [41,42] 来解决顺序决策中的稀疏奖励问题. 在本文中, 我们所提的序贯感知技能发现方法也可以被视为解决具有

挑战性的稀疏奖励问题的一种潜在有效解决方案.

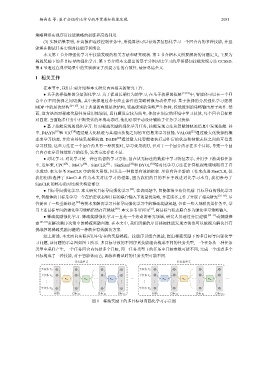

综上所述, 本文面向实际应用中存在的奖励稀疏、技能序贯组合挑战, 提出稀疏奖励下的多目标导向强化学

习问题, 该问题的示意图如图 1 所示. 多目标导致的不同序贯技能组合构成不同的任务类型, 一个任务从一种任务

类型中采样产生, 一个任务回合内包括多个目标, 同一任务类型下的任务中目标参数可能不同, 完成一个或者多个

目标构成了一种技能, 对于智能体而言, 训练和测试时的任务类型可能不同.

任务类型 1 任务类型 i

子任务 11 子任务 i1

子任务 12 子任务 i2

… π ω K … π ω K π ω 1 … π ω 2 …

π ω 1

π ω 2

… … … … … … … … … …

子任务 1m 子任务 im

初始 目标 g 1 目标 g 2 目标 g L 初始 目标 g 1 目标 g 2 目标 g L

图 1 稀疏奖励下的多目标导向强化学习示意图