Page 172 - 《软件学报》2025年第5期

P. 172

2072 软件学报 2025 年第 36 卷第 5 期

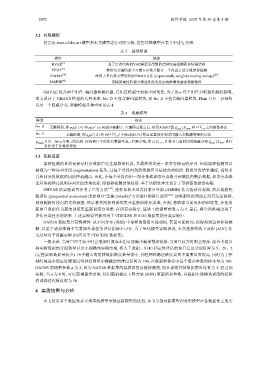

3.2 对照模型

将已有 state-of-the-art 模型和本文模型进行对照实验, 这些基准模型在表 3 中进行介绍.

表 3 基准模型

模型 描述

HVAE [2] 基于层次结构的VAE模型采用新的漂移度量检测群体情感漂移

VIGO [33] 使用变分编码器学习潜在参数并配合一个内置方法实现漂移检测

IEWMA [30] 改进了具有异方差的传统EWMA方法 (exponentially weighted moving average) [29]

IAMNB [42] 该模型通过监视分类器性能变化实现检测情感流数据漂移

GHVAE 包含两个组件: 编码器和解码器, 它们在模型中扮演不同角色. 为了揭示每个组件对模型性能的影响,

本文设计了 GHAVE 模型的几种变体: No_D 不包含解码器模块, 而 No_E 不包含编码器模块, Plain 只有一层结构

以及一个隐藏分布. 消融模型具体内容见表 4.

表 4 消融模型

模型 描述

No_D 无解码器, 即 p θ (S | z ) 和 p θ (z | z) 两部分被删去. 在编码过程之后, 使用ADD计算 z new | S new 和 z | z ′ 1:n 之间的漂移度

′

′

′

No_E 无编码器, 即 q ϕ (z | S ) 和 q ϕ (z | z ′ 1:n 不经过MLP计算而是直接分别采用输入和隐藏变量的后验

)

′

z new | S new 进行

′

Plain 只有一层元分布 z 的结构. 使用窗口中的所有数据生成 z 后验分布, 即 z | S 1:n , 并将其与新时段的隐藏分布

对比用于计算漂移度

3.3 实验设置

漂移检测的目的是标记时序数据中发生漂移的时段, 其最终结果是一条带有标记的序列. 因此漂移检测可以

被视为一种序列分段 (segmentation) 任务, 且每个分段内部的数据应当是彼此相似的. 假设分段结果越好, 说明来

自相同分段数据的同质性就越高. 由此, 在每个分段内用一部分数据训练分类器并预测段内剩余数据, 如果分类器

全局准确性高说明序列分段结果较好, 即漂移检测结果较好. 基于该假设本文设计了带标签数据的实验.

GHVAE 的实验设置参考了已有方法 [42] , 选择累积多项式朴素贝叶斯 (AMNB) 作为情感分类器, 然后根据先

验评估 (prequential evaluation) 的原则以“重建 (rebuild)”方式进行漂移自适应 [45] : 如果新时段到达后没有发生漂移,

则预测新时段内的文档标签, 然后将其附加到训练集并重新训练分类器; 否则, 将放弃当前累积的训练集, 并使用

新窗口数据作为新的训练集重新训练分类器. 在所有实验中, 算法 1 的调整参数 α 为 1. 最后, 将全局准确度用于

评估分类任务的结果. 上述实验设置被应用于 CIRCLES 和 S140 数据集的分类实验中.

GAUSS 数据集具有特殊性. 从不同分布 (类别) 中采样的数值可能相似, 甚至可能相同, 使得类别边界非常模

糊, 以至于诸如准确率等常规分类任务评估指标不可行. 为了量化模型实验表现, 本文选择曲线下面积 (AUC) 作

为度量用于消融实验 (同应用于 CIRCLES 数据集).

一般来讲, 当窗口尺寸较小时会增加时间成本但可能减少漏报增加错报, 当窗口较大时则会相反. 综合考虑各

种实验数据的分段数量以及小规模预实验结果, 将人工数据、S140 和定性评估的窗口长度分别设置为 5、20、2

(定性实验数据量较少). 由于输入的情感数据维度数量很小, 神经网络隐层维度设置不需要设置很高, 同时为了控

制时间成本保证处理速度将神经网络中隐藏层的维度设置为 100, 在重新参数化中每个潜在参数的样本量为 100.

GAUSS 的调整参数 α 为 2, 因为 GAUSS 数据集的漂移很容易被检测到, 而在训练其他数据集时设置为 1. 经过预

实验, 当 λ 为 4 时, 可以获得最佳结果. 使用随机梯度下降方法 (SGD) 更新所有参数, 并根据小规模预训练的经验

将训练迭代数设置为 50.

4 实验结果与分析

本文使用多个数据集并实现基线模型来验证新模型的优势, 本节分别对新模型和对照模型在各数据集上的实