Page 201 - 《软件学报》2025年第4期

P. 201

孙泽辰 等: 基于可控性解释的混合数据增强框架 1607

的 LLaMA 系列模型与 FLAN-T5 模型展开实验, 首次探索了该类模型在多个自然语言理解任务中的捷径学习问

题. 然而, 多个场景下的实验表明, 捷径学习问题仍然明显存在于微调后的生成式大模型, 影响模型的鲁棒性与泛

化性, 需要得到缓解.

基于上述探索, 我们以数据为中心提出了面向生成式预训练大模型捷径学习问题的缓解方案: 基于可控性解

释的混合数据增强框架. 数据的解释 (explanation) 在自然语言的多个场景中发挥着重要的作用, Wei 等人 [34] 、

Lampinen 等人 [35] 探索了解释性数据对于提高模型推理能力的作用. 在使用解释性数据对于模型鲁棒性的影响方

面, Stacey 等人 [36] 提出利用解释性数据监督注意力权重的方法, 并证明该方法能够同时提升模型在分布内外测试

集中的性能. Chen 等人 [37] 与 Schuster 等人 [38] 证实了使用解释性数据能够提升模型对于对抗攻击的鲁棒性. 与上述

工作不同的是, 我们专注于使用解释性数据缓解生成式大模型的捷径学习问题. 并且, 借助当前生成式大模型强大

的生成能力, 我们通过可控性提示工程使 ChatGPT 模型自动生成样本的解释性数据, 而不依赖人工标注或者抽取

式方法. 最后, 我们提出了数据混合的策略, 将可控性解释数据与提示性数据进行混合, 以构造多样性更强的混合

数据集用于微调模型. 我们的方法有效地缓解了生成式大语言模型的捷径学习问题, 提升了模型在分布外测试场

景中的鲁棒性, 同时未牺牲甚至提升模型在分布内测试场景中的性能.

理任务为例, 该任务的目的是预测输入的句子对中假设句

2 基于可控性解释的混合数据增强框架

本节详细介绍了我们提出的基于可控性解释的混合数据增强框架. 内容分两部分: 方法的实现流程以及与其

他方法的对比分析.

2.1 方法实现流程

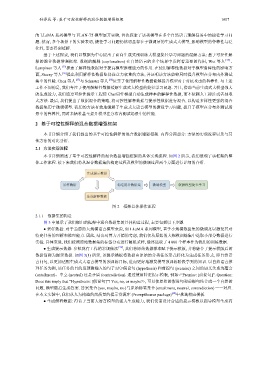

本节详细阐述了基于可控性解释的混合数据增强框架的具体实现流程. 如图 2 所示, 我们展现了该框架的整

体工作流程. 接下来我们将从混合数据集的构建过程及模型的微调过程两个方面进行详细的介绍.

生成提示数据

采样数据 构造混合数据集 微调模型 缓解模型捷径学习

生成解释数据

图 2 框架总体操作流程

2.1.1 数据集的构造

图 3 中展示了我们提出的框架中混合数据集的具体构造过程, 主要包括以下步骤.

● 采样数据: 对于当前的大规模语言模型来说, 如 LLaMA 系列模型, 基于小规模数据集的微调足以激发其对

特定任务的理解和推理能力. 因此, 结合对算力开销的考虑, 我们仅从原始的大规模训练集中选取小部分数据进行

实验. 具体来说, 我们按照原始数据集的标签分布进行随机采样, 最终选取了 4 000 个样本作为我们的训练数据.

● 生成提示数据: 参照现有工作的常规做法 [39] , 我们将原始数据样本赋予提示模板, 并将融合了提示模版后的

数据简称为提示数据. 如图 3(1) 所示, 该提示模板将数据由原始的分类任务形式转化为生成任务形式, 即自然语

言问句, 以更加适配生成式大语言模型的预训练目标, 进而更好地激发模型预训练阶段学到的知识. 以自然语言推

(hypothesis) 和前提句 (premise) 之间的语义关系为蕴含

(entailment)、中立 (neutral) 还是矛盾 (contradiction). 通过使用特定提示模板, 例如<“Premise: [前提句]”. Question:

Does this imply that “Hypothesis: [假设句]”? Yes, no, or maybe?>, 可以使原始的假设句和前提句结合成一个自然的

问题, 模型随后生成答案. 答案集合{yes, maybe, no}与原始标签集合{entailment, neutral, contradiction}一一对应.

在本文实验中, 我们从人为构造的高质量的提示资源库 (PromptSource package) [40] 中挑选相应模板.

● 生成解释数据: 得益于当前大语言模型的强大生成能力, 我们仅需设计合适的提示模板以指导模型生成高