Page 204 - 《软件学报》2025年第4期

P. 204

1610 软件学报 2025 年第 36 卷第 4 期

预测. 该分类器头将 [CLS] 词符的嵌入经过线性分类层, 输出对于每一个特定标签的概率, 最后将概率最大的标签

类别作为推理结果.

随后, Lester 等人 [44] 提出了使用提示的方法微调 BERT 类模型的技术. 该类方法将特定句子对<s1, s2>转换为

例如“[CLS] s1 ? [MASK] s2 [SEP]”的形式输入模型. 与上述使用 [CLS] 词符的嵌入预测标签的方法不同, 该类方

法使模型直接在 [MASK] 词符对应的位置生成特定标签. 测试过程同样如此, 在模型输出 [MASK] 词符位置对应

生成概率分布之后, 将标签集合中对应生成概率最大的标签类别作为结果. 这种提示方法与 BERT 模型在预训练

[1]

阶段的掩码语言模型 (masked language model, MLM) 任务相符, 即预测被 [MASK] 标记的输入句子位置的词符,

从而在多个下游任务上取得了效果提升.

然而, 当我们使用生成式预训练大模型进行微调时, 同样需要与模型预训练阶段的学习任务相匹配. 该类模型

在预训练阶段中的任务是基于上下文预测下一个词, 同时不使用 [MASK] 标签. 所以我们需要利用特定提示模板

将句子对转换为问答的方式, 这样使得模型可以在提示输入之后生成预测的标签. 在测试过程中, 我们将通过特定

提示模板转换后的句子输入模型, 然后模型将会输出对应的回答作为类别标签.

此外, 仅解码器结构的模型和编码器-解码器结构的模型在训练和推理过程中存在细微差别. 对于仅解码器架

FEVER dev

构的模型来说, 其流程正如第 2.1.2 节中所提, 该模型将问题直接输入解码器随后逐字生成答案. 而对于编码器-解

码器结构的模型来说, 问题部分将被输入编码器, 随后解码器将逐字生成答案.

3 实 验

3.1 实验数据

我们选取 3 个经过充分研究且广为采纳的自然语言理解任务展开实验, 分别是自然语言推理任务 (natural

language inference, NLI)、事实验证任务 (fact verification) 以及释义识别任务 (paraphrase identification). 参照先前

的研究思路 [6] , 我们通过比较模型在与训练数据同分布和不同分布的测试场景中的性能来探究模型的捷径学习程

度. 与训练数据同分布的测试场景通常为该数据集本身的验证集或测试集, 也被称为分布内数据集 (in-domain

data, ID), 与其具有不同分布的测试场景通常包含较多不能通过捷径做出正确预测的测试样本, 这类数据集被称为

分布外数据集 (out-of-domain data, OOD) [45] . 表 1 中同时给出了各个任务对应数据集的统计信息, 下面将对各个数

据集进行详细的介绍.

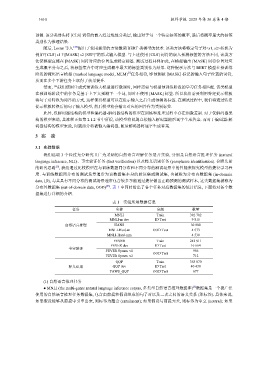

表 1 实验所用数据信息

任务 名称 分割 数量

MNLI Train 392 702

MNLI-m dev ID Test 9 815

自然语言推理 HANS 30 000

MNLI-Hard-m OOD Test 4 573

MNLI-Hard-mm 4 530

FEVER Train 242 911

ID Test 16 664

事实验证

FEVER Symm. v1 956

OOD Test

FEVER Symm. v2 712

QQP Train 363 870

释义识别 QQP dev ID Test 40 430

PAWS_QQP OOD Test 677

(1) 自然语言推理任务

● MNLI (the multi-genre natural language inference corpus, 多类型自然语言推理数据库) 数据集是一个被广泛

[3]

使用的自然语言推理任务数据集, 包含由前提和假设组成的句子对以及二者之间的语义关系 (即标签). 具体来说,

如果假设能够从前提中引申出来, 则标签为蕴含 (entailment); 如果假设与前提无关, 则标签为中立 (neutral); 如果