Page 209 - 《软件学报》2025年第4期

P. 209

孙泽辰 等: 基于可控性解释的混合数据增强框架 1615

展示不同设置对模型的影响. 同时, 我们在最后分析了解释性数据的获取方案对模型缓解捷径学习问题的影响, 以

便进行更为全面的分析和探讨.

(1) 我们在表 4 中展示了采样不同训练样本规模对模型缓解捷径学习问题的影响. 实验结果表明, 使用全数据

集微调模型时的准确率在各个数据集中均高于使用 4 000 条样本微调模型. 然而, 随着训练样本的增加, 模型在分

布内测试场景中的准确率提升小于模型在分布外测试场景中的准确率提升, 进而导致全数据集微调下的 Dec.值较

高. 训练数据的增加而对模型分布内外性能的提升不一致, 同样属于捷径学习的表现之一. 并且, 从表 4 中可以看

出, 仅使用规模大小为 2 000 的数据集微调模型, 即可使模型在分布内场景表现出较为良好的性能 (84.3%), 这表

明即使是小规模数据集也能够有效地激发生成式预训练大模型完成特定任务的能力. 同时, 增加训练样本的规模

反而可能损害模型的泛化能力: 当训练样本规模由 10 000 提升至 50 000 时, 分布外平均准确率 Avg.值由 78.8%

下降到 78.4%. 因此, 结合对训练开销等因素的综合考虑, 我们最终选择基于样本数量为 4 000 的小规模数据集来

缓解模型的捷径学习.

(2) 关于可控性解释数据与原始提示性数据的混合比例对模型的影响, 我们在表 5 中报告了不同的混合比例

设置下的实验结果. 结果表明, 本文使用的等比例混合方案在分布内外测试场景中均具有最高的准确率 (分布内准

确率 85.8%, 分布外 Avg. 79.4%) 以及次低的捷径学习问题表现 (Dec. 6.3%), 这表明等比例混合方案为最优设置.

其次, 无论是使用完全的提示性数据进行微调还是使用完全的解释性数据进行微调, 模型均表现出较为严重的捷

径学习问题, 后者甚至 Avg.值更低且 Dec.值更高 (Avg. 77.1% vs. 74.4%; Dec. 7.7% vs. 8.2%), 这表明训练数据形

式的多样性对缓解模型的捷径学习问题至关重要, 更加验证了我们所提出的混合策略的有效性. 正如第 2.1.1 节所

述, 如果完全使用解释性数据进行微调, 过多的解释数据可能使模型在训练时过度关注解释而非目标标签 , 从而

损害模型的总体性能. 最后, 尽管在提示性与解释性数据混合比例为 1:3 的配置下得到了最小的 Dec.值 (2.8%), 但

这主要是因为在该比例下模型在分布内测试场景中的性能过低 (准确率仅为 74.2%, 显著低于我们设置的 85.8%),

在分布外测试场景中的性能也是最差的 (平均准确率 Avg.也只有 71.4%, 远低于我们设置的 79.4%), 因此这并不

能说明模型在此设置下的捷径学习程度较低.

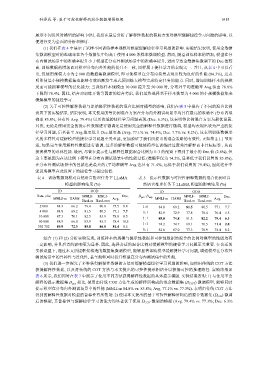

表 4 训练数据规模对自然语言推理任务下 LLaMA 表 5 提示性数据与可控性解释数据的混合比例对自

模型的影响结果 (%) 然语言推理任务下 LLaMA 模型的影响结果 (%)

ID OOD ID OOD

Data_size MNLI- MNLI- Dec. D pro :D exp MNLI- MNLI- Dec.

MNLI-m HANS Avg. MNLI-m HANS Avg.

Hard-m Hard-mm Hard-m Hard-mm

2 000 84.3 66.2 79.4 80.8 75.5 8.8 1:0 84.8 69.2 81.5 80.5 77.1 7.7

4 000 84.8 69.2 81.5 80.5 77.1 7.7 3:1 82.9 72.9 77.8 78.4 76.4 6.5

10 000 87.3 70.1 82.5 83.9 78.8 8.5

1:1 85.8 74.8 81.3 82.2 79.4 6.3

50 000 88.9 66.0 83.9 85.3 78.4 10.5

1:3 74.2 74.7 69.1 70.5 71.4 2.8

392 702 89.9 72.3 85.8 86.0 81.4 8.5

0:1 82.6 67.0 77.3 78.9 74.4 8.2

综合 (1) 和 (2) 分析实验发现, 训练样本的规模与提示性数据和可控性数据的混合的比例对模型的性能均有

一定影响, 并且后者的影响更为显著. 因此, 选择合适的混合比例对缓解模型的捷径学习问题至关重要. 在合适的

实验设置下, 通过本文所提框架构造的数据集微调模型, 能够显著帮助模型缓解捷径学习问题, 增强模型在分布外

测试场景中的鲁棒性与泛化性, 甚至能够同时提升模型在分布内测试集中的性能.

(3) 我们进一步探究了多种获得解释性数据的方法对缓解模型捷径学习问题的影响, 如使用传统的 COT 方法

获得解释性数据, 以及将传统的 COT 方法与本文提出的可控性提示相结合以获得可控的推理路径. 实验结果如

表 6 所示, 我们同时在表 7 中展示了使用不同方法获得解释性数据的具体提示模版. 实验结果表明: 1) 与使用不含

解释的提示数据集 D pr 相比, 使用由传统 COT 方法生成的解释所构成的混合数据集 (D COT ) 微调模型, 能够同时

o

提示模型在分布内外测试场景中的性能 (MNLI-m 84.8% vs. 85.8%; Avg. 77.1% vs. 77.3%). 表明由传统 COT 方法

得到的解释性数据对模型的鲁棒性有所帮助. 2) 使用本文提出的基于可控性解释所构造的混合数据集 (D mix ) 微调

后的模型, 其鲁棒性与缓解捷径学习的能力均显著优于使用 D CO 微调的模型 (Avg. 79.4% vs. 77.3%; Dec. 6.3%

T