Page 336 - 《软件学报》2024年第6期

P. 336

2912 软件学报 2024 年第 35 卷第 6 期

端上执行, 编程软件平台为 PyCharm 2021.3.1. 每个数据集的实验结果都由 10 折交叉验证获得, 交叉验证的具体

次数将在下文给出.

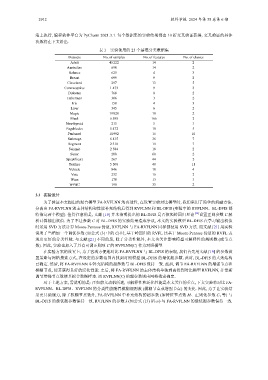

表 1 实验使用的 25 个基准分类数据集

Datasets No. of samples No. of features No. of classes

Adult 45 222 14 2

Australian 690 14 2

Balance 625 4 3

Breast 699 9 2

Cleveland 297 13 5

Contraceptive 1 473 9 3

Diabetes 768 8 2

Haberman 306 3 2

Iris 150 4 3

Liver 345 6 2

Magic 19 020 10 2

Musk 6 598 166 2

Newthyroid 215 5 3

Pageblocks 5 472 10 5

Penbased 10 992 16 10

Satimage 6 435 36 7

Segment 2 310 19 7

Seismic 2 584 18 2

Sonar 208 60 2

Spectfheart 267 44 2

Texture 5 500 40 11

Vehicle 846 18 4

Vote 232 16 2

Wine 178 13 3

33

2

WPBC 198 FA-RVFLNN

3.1 实验设计

为了验证本文提出的混合模型 FA-RVFLNN 的有效性, 在设置实验对比模型时, 我们采用了简单的消融方法,

分离出 FA-RVFLNN 的主体结构和性能补充结构后得到 RVFLNN 和 BL-DFIS (实验中的 RVFLNN、BL-DFIS 都

特指这两个模型). 值得注意的是, 文献 [19] 并未指明提出的 BL-DFIS 是否依照岭回归理论 [35] 设置正则参数 C 解

析计算输出权值. 为了不让参数 C 对 BL-DFIS 的实验结果造成争议, 本文的实验模型 BL-DFIS 在学习输出权值

时采用 SVD 方法计算 Moore-Penrose 伪逆, RVFLNN 与 FA-RVFLNN 同样都使用 SVD 方法. 而文献 [21] 用实验

说明了当增加一个调优参数 (如公式 (3) 中的 C) 时, 基于岭回归的 RVFL 比基于 Moore-Penrose 伪逆的 RVFL 表

现出更好的分类性能. 与文献 [21] 不同的是, 除了分类性能外, 本文也关注影响模型可解释性的规则数 (或节点

数). 因此, 实验也加入了具有可调正则项 C 的 RVFLNN(C) 作为对照模型.

在实验方案的设置上, 为了客观方便地对比 与 BL-DFIS 的表现, 我们首先用文献 [19] 的参数设

置策略与网格搜索方式, 在设定的参数范围内找到对照模型 BL-DFIS 的最优超参数. 此时, BL-DFIS 的大致结构

已确定. 然后, 将 FA-RVFLNN 中补充结构的超参数与 BL-DFIS 保持一致. 最后, 调节 FA-RVFLNN 的增强节点和

模糊节点, 使其获得良好的泛化性能. 之后, 将 FA-RVFLNN 的主体结构单独剥离得到对比模型 RVFLNN, 并重新

调节增强节点数使其拟合数据样本. 而 RVFLNN(C) 的超参数则由网格搜索确定.

对于上述方案, 需说明的是: 正如前文动机所述, 可解释性和泛化性能是本文关注的重点, 下文实验将对比 FA-

RVFLNN、BL-DFIS、RVFLNN 的分类性能随着模糊规则数 (模糊节点或增强节点) 的变化. 因此, 为了让实验结

果更具说服力, 除了模糊节点数外, FA-RVFLNN 中补充结构的超参数 (如特征节点数 M、正则化参数 C 1 等) 与

BL-DFIS 的最优超参数保持一致. RVFLNN 的参数 λ (如公式 (13) 所示) 与 FA-RVFLNN 的最优超参数保持一致.