Page 334 - 《软件学报》2024年第6期

P. 334

2910 软件学报 2024 年第 35 卷第 6 期

的含义, 这对主体结构的可解释性更有利; 第二, 从某种角度来看, FA-RVFLNN 可被当做由分类器 RVFLNN 和分

类器 BL-DFIS 构成的集成系统, 原始数据和预处理数据的设置可进一步增强以两者为输入的分类器间的多样性,

由集成学习理论可知, 更强的多样性 (diversity) 有利于提升系统性能.

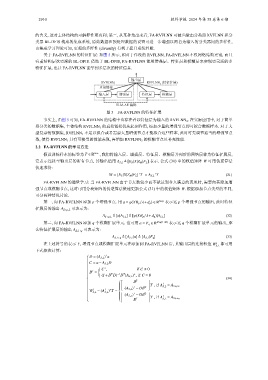

关于 FA-RVFLNN 的特征扩展: 如图 5 所示, 相对于传统的 RVFLNN, FA-RVFLNN 不仅网络结构更宽, 而且

有着结构层次更深的 BL-DFIS. 借助于 BL-DFIS, FA-RVFLNN 能用增强层、特征层和模糊层来实现更灵活的多

特征扩展, 也让 FA-RVFLNN 能学到多层次的特征信息.

输出层

RVFLNN 2 (特征扩展)

RVFLNN 1

直接链接

输入层 增强层 特征层 模糊层

ELM-AE 编码

图 5 FA-RVFLNN 的特征扩展

事实上, 由图 5 可知, FA-RVFLNN 的结构中也存在着以特征层为输入的 RVFLNN 2 . 在实际应用中, 对于简单

易分类的数据集, 主体结构 RVFLNN 1 的直接链接优先起到作用, 添加少量的增强节点即可拟合数据样本. 对于大

型复杂的数据集, RVFLNN 1 不足以拟合或者需要大量增强节点才能拟合这些样本, 此时可先调节适当的增强节点

数, 使得 RVFLNN 1 具有可接受的性能表现, 再增加 RVFLNN 2 的模糊节点以补充性能.

2.2 FA-RVFLNN 的学习方法

T ∈ R N×c , 我们将输入层、增强层、特征层、模糊层并列后的网络层称为特征扩展层,

假设训练样本的标签为

它表示连接至输出层的所有节点, 其输出值用 A S,L ≜ [E S |X|Z M |F L ] 表示. 公式 (30) 中的权值矩阵 W 可用伪逆算法

快速求得:

+

+

W = [E S |X|Z M |F L ] T = A S,L T (31)

FA-RVFLNN 的增量学习: 当 FA-RVFLNN 由于节点数较少而不能达到令人满意的表现时, 需要向其添加增

强节点或模糊节点, 这时可用分块矩阵的伪逆算法快速更新公式 (31) 中的权值矩阵 W. 根据添加节点类型的不同,

可分两种情况讨论. T

第一, 向 FA-RVFLNN 添加 p 个增强节点. 用 a = φ(XB p /λ+d p ) ∈ R N×p 表示这 p 个增强节点的输出, 此时特征

扩展层的输出 A S+p, 可表示为:

L

A S +p,L ≜ [a|A S,L ] ≜ [φ(XB p /λ+d p )|A S,L ] (32)

第二, 向 FA-RVFLNN 添加 q 个模糊扩展单元. 也可用 a = F q ∈ R N×q(1+M) 表示这 q 个模糊扩展单元的输出, 那

么特征扩展层的输出 A S,L+ 可表示为:

q

A S,L+q ≜ [A S,L |a] ≜ [A S,L |F q ] (33)

在上述符号的表示下, 增强节点或模糊扩展单元在添加到 FA-RVFLNN 后, 其输出层的连接权值 W S,L 都可用

1

下式依次计算:

+

D = (A S,L ) a

C = a− A S,L D

+

C ,

if C , 0

T

B =

T −1 +

(I + D D) D (A S,L ) , if C = 0

(34)

T

B

T , if A 1

= A S +p,L

+ T S,L

(A S,L ) − DB

1 1 +

W

S,L

S,L = (A ) T = [ ]

+

(A S,L ) − DB T

1

T , if A

T S,L = A S,L+q

B