Page 164 - 《软件学报》2024年第4期

P. 164

1742 软件学报 2024 年第 35 卷第 4 期

方法上进行参数量 500 的实验; 原始任务 [16] 中的参数量是 500). 对于批量大小的设置, 本文按照 Few-shot 的

有关设定, 设计批量大小与分类任务的类别数成比例(即在 SST-2 上的批量大小为 8, 在 AG’s News 上的批量

大小为 16). 类似地, 在 LightGBM 模型上进行了两个多分类任务和一个回归任务, 数据集大小涉及 3 个不同

的数量级.

在基于语言模型即服务的黑盒微调(BBT)任务上, 使用预训练的 RoBERTa LARGE 模型 [16] , 通过优化器

对维度为 500 或 50 的提示词进行微调优化, 进而完成一系列自然语言处理任务(见表 1). 在机器学习

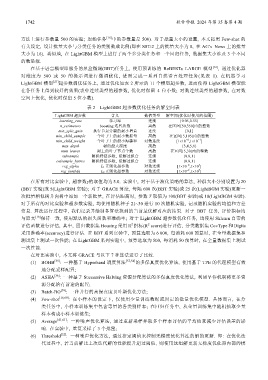

LightGBM 模型 [21] 超参数调优任务上, 通过优化如表 2 所示的 11 个模型超参数, 进而使得 LightGBM 模型能

在各任务上得到较好的效果(表中连续类型的超参数, 优化时保留 4 位小数; 对数连续类型的超参数, 在对数

空间上优化, 优化时保留 5 位小数).

表 2 LightGBM 超参数优化任务的解空间表

LightGBM 超参数 含义 数值类型 解空间(优化时使用的范围)

learning_rate 学习率 连续 [0.05,0.55]

n_estimators boosting 迭代次数 离散 在区间[50,350]内的整数

min_split_gain 执行节点分裂的最小增益 连续 [0,1]

min_child_sample 一个叶子上的最小数据量 离散 在区间[5,105]内的整数

−4

−1

min_child_weight 一个叶子上的最小海森和 对数连续 [1×10 ,1×10 ]

max_depth 树的最大深度 离散 {3,4,5,6}

num_leaves 树上的叶子节点个数 离散 在区间[5,30]内的整数

subsample 随机特征参数, 缓解过拟合 连续 [0.8,1]

colsample_bytree 随机特征参数, 缓解过拟合 连续 [0.8,1]

3

−2

reg_alpha L 1 正则化超参数 对数连续 [1×10 ,1×10 ]

−2

3

reg_lambda L 2 正则化超参数 对数连续 [1×10 ,1×10 ]

在所有对比实验中, 超参数γ的取值均为 5.0. 实验中, 对于基于演化策略的算法, 种群大小分别设置为 20

(BBT 实验)或 5(LightGBM 实验); 对于 GRACE 算法, 每隔 600 次(BBT 实验)或 25 次(LightBGM 实验)更新一

次批量相似树并向树中添加一个新批量, 在评估距离时, 参数 T 取值为 100(BBT 实验)或 10(LightBGM 实验).

对于所有的对比实验和超参数实验, 均使用随机种子 21~30 进行 10 次随机实验, 记录随机实验的均值和方差

信息. 算法运行过程中, 我们记录并绘制各算法找到的当前最优解对应的结果. 对于 BBT 任务, 评价指标均

与原文 [16] 保持一致, 使用默认的损失函数和准确率; 对于 LightGBM 超参数优化任务, 均使用 Sklearn 自带的

2

2

评估函数进行评估, 其中, 回归数据集 Housing 采用 R 指标(R score)进行评估, 分类数据集 CovType 和 Digits

采用准确率(accuracy)进行评估. 在 BBT 系列实验中, 预算选取为 6 000, 每消耗 600 预算时, 在全量数据集和

测试集上测试一次性能; 在 LightGBM 系列实验中, 预算选取为 500, 每消耗 50 预算时, 在全量数据集上测试

一次性能.

在对比实验中, 本文将 GRACE 与以下 7 种算法进行了比较.

(1) BOHB [35] : 一种基于 Hyperband 调度算法 [57,58] 的多保真度优化算法, 使用基于 TPE 的代理模型有效

地分配采样配置;

(2) ASHA [36] : 一种基于 Successive Halving 资源分配算法的多保真度优化算法, 利用早停机制将更多资

源分配给有前途的配置;

(3) Batch-BO [59] : 一种并行的高保真度贝叶斯优化方法;

(4) Few-shot [16,60] : 在小样本的设定下, 仅使用少量训练数据或固定的批量优化模型. 具体而言, 在分

类任务中, 小样本训练集中包含等量的各类别样本; 在回归任务中, 从全量训练集中随机抽取少量

样本构成小样本训练集;

(5) Average [41,61] : 一种噪声优化算法, 通过重新采样并取多个样本评估的平均值来减少评估误差的影

响. 在实验中, 重复采样了 3 个批量;

(6) Threshold [32] : 一种噪声优化方法, 通过指定阈值来控制无梯度优化算法的解的更新. 即: 在优化迭

代过程中, 若当前解比上次迭代解的性能提升超过阈值, 则使用这组解更新无梯度优化器内部的模