Page 163 - 《软件学报》2024年第4期

P. 163

钱鸿 等: 基于动态批量评估的绿色无梯度优化方法 1741

4.3 批量索引选择策略

在构建的批量相似树后, 本节阐述如何根据批量相似树选择优化过程中需要被评估的批量, 即批量索引

选择策略. 上一节中介绍了批量相似树的两种节点: 叶节点表示批量, 非叶节点存储其两个子节点之间的相

似度信息. 显然, 在批量相似树中, 如果处于同一个父节点下的两个子节点距离根节点较远, 则表明它们之间

的相似度很大(如图 5 步骤 4 中的叶节点 1 和叶节点 2). 由于本文所考虑的优化任务的昂贵性, 因此评估时选

取批量的原则应该是: 在实现尽可能高的评估准确性的同时, 用尽可能少的批量样本进行评估. 换句话说,

应该用尽可能少的批量来代表全体样本, 达到类似于评估全体样本的评估效果. 本文方法的基本想法是: 避

免选择相似度高的批量. 相似度高的批量对解的评估值是高度相似的, 选择它们可能不能为模型提供多样的

样本、探索更大的样本空间, 进而导致优化陷入局部极小值.

在选择批量时, 批量相似树被分割成多个子树, 并认为同一子树中的叶节点相似度很高, 不同子树中的

叶节点表现较大的差异性. 这是因为批量相似树是根据批量的相似性构建的, 具有更高相似度的节点会较早

地分配给同一个父节点. 随后, 可以从每个子树中随机选择节点, 这样便可以确保选择出具有较大差异的批

量进行评估. 通过上述过程可以发现, 基于批量相似树选择优化过程中使用的批量需要解决两个问题: 首先,

需要确定如何将批量相似树分割为包含高度相似叶节点的多个子树; 其次, 需要确定从这些子树中选择出需

要评估的批量方法. 这两个问题即是批量索引选择策略的关键. 对于第 1 个问题, 通过引入超参数γ来将二叉

树分割成子树, 即: 如果一个节点是叶节点或其存储的距离小于γ, 而其父节点存储的距离大于γ, 则以该节点

为根的子树将被视为选择的子树. 通过这种方法, 可以将批量相似树分割成多个子树, 且每个子树中的叶节

点相似度很高. 对于第 2 个问题, 通过随机游走策略可以从每个子树中找出合适的节点来代表该子树. 随机游

走策略从每个子树的根节点开始, 每次以等概率选择其左右节点之一. 这个过程重复进行, 直到到达一个叶

节点, 则选择该叶节点对应的批量作为代表该子树的批量. 随机游走方法旨在增加选择树的上层节点的概率,

因为这些节点与子树中的其他节点的差异更大. 因此, 使用该策略会返回更具差异性的批量. 图 6 展示了使用

批量索引选择策略的一个示例. 首先, 根据最左侧的批量相似树的结构, 将分离超参数γ应用于树的符合分离

条件的边, 得到由多个子树组成的森林; 然后, 与原始树结构的根节点连接的子树被移除; 最后, 从每个剩余

子树的根节点执行随机游走策略, 选择表示该子树的叶节点, 得到需要评估的批量索引集合.

5 实验分析

5.1 实验设置

实验部分, 本文分别在基于语言模型即服务的黑盒微调(BBT)任务(使用 RoBERTa LARGE 作为基础大模

型, 该模型的参数量为 355 M) [16] 和机器学习 LightGBM 模型 [21] 超参数调优任务上进行了对比实验、消融实验、

超参数分析等实验, 并对算法运行过程和实验结果进行分析.

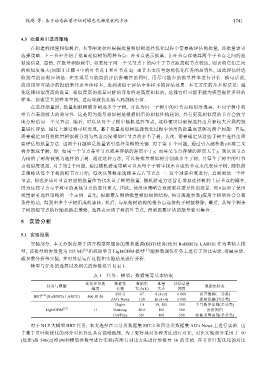

模型与任务的选择以及相关的参数设置见表 1.

表 1 任务、模型、数据集等基本情况

优化任务的 数据集 数据集 批量 评估总量

任务与模型 数据集特点

维度 名称 大小(K) 大小 预算

SST-2 67 8 (4×2) 6 000 语言情感(二分类)

[16]

BBT (RoBERTa LARGE) 500 和 50

AG’s News 120 16 (4×4) 6 000 新闻话题(四分类)

Digits 1.8 50, 100 300 手写数字识别(多分类)

LightGBM [21] 11 Housing 20.6 100 500 房价回归

CovType 581 100 500 植被类型识别(多分类)

对于 NLP 大模型 BBT 任务, 本文选择在二分类数据集 SST-2 和四分类数据集 AG’s News 上进行实验. 由

于基于贝叶斯优化的部分对比算法具有高维瓶颈, 为了更好地对各种方法进行对比, 对比实验部分采用了 50

(低维)和 500(高维)两种模型参数量进行实验(在所有对比方法进行参数量 50 的实验, 在非贝叶斯优化的对比