Page 158 - 《软件学报》2024年第4期

P. 158

1736 软件学报 2024 年第 35 卷第 4 期

而形成新一代的种群. 与自然进化类似, 由于变异和杂交产生的新个体并不总是适应环境的, 自然选择在这

个过程中发挥了关键作用, 即: 一般只允许适应性强的个体(评估值较好的解)存活, 淘汰适应性较差的个体

(评估值较差的解). 幸存的个体形成一个新的种群代(子代), 循环迭代上述过程, 直至收敛到满意的解.

相较于普通的演化策略, 协方差矩阵自适应演化策略(covariance matrix adaptation evolution strategy,

CMA-ES) [45] 是一种考虑解空间各维度相关性的高效演化策略, 具有更快的收敛速度和更好的收敛效果. 演化

策略通常使用高斯分布建模采样模型, 从由均值向量和协方差矩阵表示的多元高斯分布中采样, 进而生成新

的候选解种群. 普通的演化策略常通过将随机变异向量与均值向量相加, 并使用固定不变的协方差矩阵来控

制搜索种群的分布. CMA-ES 算法对这一过程进行改进, 使用随迭代自适应变化的协方差矩阵控制搜索分布,

通过动态的协方差矩阵表示搜索空间中不同变量之间的相关性, 使优化算法能够更快收敛找到优质解. 此外,

CMA-ES 算法在保留种群高质量候选解的同时, 还会生成特征丰富多样的候选解, 进而有效地权衡对解空间

的探索与对已有解信息的利用. CMA-ES 算法还具有处理高维优化和噪声优化问题的潜力. 因此, 在本文实验

部分, 我们选用 CMA-ES 算法作为 GRACE 框架中无梯度优化的具体实施算法.

3 问题定义

3.1 使用全量样本进行解评估的优化

在介绍本文提出的算法框架之前, 首先对要解决的问题进行形式化描述. 基于语言模型即服务的提示词

黑盒微调 [15,16] 、模型超参数优化等任务可抽象为如下优化问题:

θ * = argmin d ((θ), train ) = argmin d f(θ, train ),

Θ

Θ

θ ∈⊆ θ ∈⊆

其中, (⋅)为模型训练过程中使用的损失函数, ((θ), train )是解θ配置下的模型(θ)在全量训练集 train =

N

x

y

{( , )} 上的损失. 简便起见, 可以将上述损失写成 f(θ, train )的形式, f(θ, train )即是优化问题的目标函数, 优

i

i

1

i=

*

化的目标为找到能够在全量训练集 train 上表现最好的解θ .

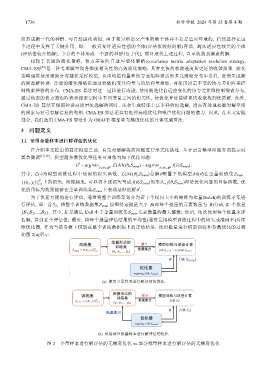

为了快速方便地进行评估, 通常将整个训练集划分为若干个相同大小的被称为批量(batch)的训练子集进

行评估, 即: 首先, 将整个训练数据集 train 按照特定批量大小 B(即每个批量的元素数量为 B)分成 K 个批量

{ 1 , 2 ,…, K }, 其中, K 是满足 K×B 小于全量训练集 train 元素数量的最大整数; 然后, 依次使用每个批量来评

估解, 得到 K 个评估值; 最后, 将每个批量评估结果的平均值(通常是指模型训练过程中的损失或准确率)反馈

给优化器, 作为当前参数下模型在整个训练数据集上的评估结果. 使用批量进行模型训练和参数优化的过程

如图 2(a)所示.

(a) 使用全量样本进行解评估的优化

(b) 使用部分批量样本进行解评估的优化

图 2 全量样本进行解评估的无梯度优化 vs.部分批量样本进行解评估的无梯度优化