Page 164 - 《软件学报》2021年第11期

P. 164

3490 Journal of Software 软件学报 Vol.32, No.11, November 2021

个方面对本文 UDAN 方法的实现细节进行介绍.

(1) 基础 CNN 模型:本文采用 ResNet50 网络模型 [20] 作为基础 CNN 模型.为了获得更好的细粒度视频分

类准确率,本文在 ResNet50 网络模型的基础上作了一些改动.具体地,将输入图片的裁剪尺寸(crop

size)设置为 448×448,在最后一层卷积层后面加一个平均池化层(average pooling layer),其内核尺寸为

14,步长为 1.

(2) 视频处理:对于 YouTube Birds 和 YouTube Cars 这 2 个视频数据集,本文实验部分仅对其 RGB 视频帧

进行分析处理.具体地,在图像到视频帧和图像到视频的适应任务中,对于每个训练视频,本文等间隔

地抽取 5 帧作为训练视频帧数据.在测试过程中,两个适应任务的设置有所不同:对于图像到视频帧适

应任务,本文抽取测试视频的中间帧作为测试数据;对于图像到视频适应任务,本文对每个测试视频

等间隔地抽取 25 帧作为测试数据.

(3) 训练细节:为了获得最好的细粒度视频分类效果,在训练过程中,本文采用了两次迭代来进行伪标签

的生成.对于伪标签生成的阈值τ,本文设置为 0.99 和 0.9.在本文 UDAN 网络模型的训练过程中,采用

梯度下降算法 SGD 进行优化,设置批尺寸(batch size)大小为 8,权值衰减系数(weight decay)为 0.0005,

冲量系数(momentum)为 0.9.本文设置初始学习率(learning rate)为 1e-5,每训练 6 个 epoch 学习率以 0.5

的系数减小.

3.4 源域数据与目标域数据之间的差异

本节展示了源域数据与目标域数据之间的差异,以 CUB-200-2011 和 YouTube Birds 两个数据集为例.与文

献[18]一样,首先利用源域数据对模型进行训练,然后将训练好的模型迁移到目标域进行测试.为了充分验证源

域与目标域之间的差异,本文执行了两种适应任务:图像到视频帧适应任务(I→F)和图像到视频适应任务(I→V).

结果见表 3(其中两个数据集分别用 S 和 T 表示),其中,源域和目标域分别表示为 S 和 T.

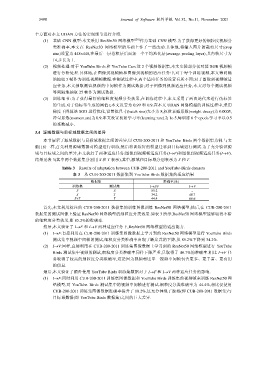

Table 3 Results of adaptation between CUB-200-2011 and YouTube-Birds datasets

表 3 从 CUB-200-2011 数据集到 YouTube Birds 数据集的适应结果

数据集 准确率(%)

训练集 测试集 I→I/F I→V

S S 85.2 −

S T 34.2 40.7

S+T T 44.4 60.6

首先,本文利用标注的 CUB-200-2011 数据集的训练图像训练 ResNet50 网络模型;然后,在 CUB-200-2011

数据集的测试图像上验证 ResNet50 网络模型的细粒度分类效果.如表 3 所示,ResNet50 网络模型能够取得不错

的细粒度分类效果,即 85.2%的准确率.

然后,本文验证了 I→F 和 I→V 两种适应任务下,ResNet50 网络模型的适应能力.

(1) I→F:直接利用在 CUB-200-2011 训练集图像数据上学习到的 ResNet50 网络模型进行 YouTube Birds

测试集中视频中间帧的测试,细粒度分类准确率出现了断崖式的下降,从 85.2%下降到 34.2%.

(2) I→V:同样,直接利用在 CUB-200-2011 训练集图像数据上学习到的 ResNet50 网络模型进行 YouTube

Birds 测试集中视频的测试,细粒度分类准确率同样下降严重,只取得了 40.7%的准确率.相比 I→F 任

务取得了较高的细粒度分类准确率,这是因为视频相比单一视频中间帧包含更多、更丰富、更有用

的信息.

最后,本文验证了额外使用 YouTube Birds 训练集数据对于 I→F 和 I→V 两种适应任务的影响.

(1) I→F:同时利用 CUB-200-2011 训练集图像数据和 YouTube Birds 训练集的视频帧来训练 ResNet50 网

络模型,对 YouTube Birds 测试集中的视频中间帧进行测试.细粒度分类准确率为 44.4%,相比仅使用

CUB-200-2011 训练集图像数据准确率提升了 10.2%.这充分体现了源域(即 CUB-200-2011 数据集)与

目标域数据(即 YouTube Birds 数据集)之间的巨大差异.