Page 162 - 《软件学报》2021年第11期

P. 162

3488 Journal of Software 软件学报 Vol.32, No.11, November 2021

特征,有效避免了 RoI Pooling 的量化损失.

经过辨识性生成网络,可以获得源域数据和目标域数据对应的辨识性联合分布 (PR 1 S ,...,R S ||L ) 和 (QR 1 T ,...,

R T ||L ) .因此,公式(1)中第 2 项 Loss JDMMD 对应的定义为

Loss JDMMD || C R S ,1:| | ( )P − C R T ,1:|| ( ) ||Q 2 ⊗ ||L I 1 = H l (4)

L

L

与 JAN 方法 [22] 一样,本文采用其相似线性时间估计来适应随机梯度下降算法 SGD,以进行端到端的网络模

型训练.

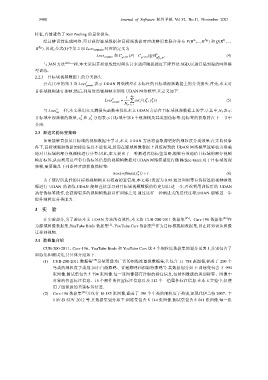

2.2.3 目标域视频数据上的分类损失

公式(1)中的第 3 项 Loss T pseudo 表示 UDAN 网络模型在未标注的目标域视频数据上的分类损失.首先,本文对

目标域视频进行抽帧;然后,利用这些视频帧来训练 UDAN 网络模型.其定义如下:

1 N T

T

Loss T pseudo = ∑ ce (( f x y T k )) (5)

,

k

N T k = 1

S

与 Loss 一样,本文采用交叉熵损失函数来优化本文 UDAN 方法在目标域视频数据上的学习.其中,N T 表示

cls

T

T

目标域中视频帧的数量, x 和 y 分别表示目标域中第 k 个视频帧及其类别伪标签.伪标签的获取将在下一节中

k

k

介绍.

2.3 渐进式伪标签策略

如果能够直接从目标域的视频数据中学习,本文 UDAN 方法将会取得更好的细粒度分类效果.在无监督条

件下,目标域视频数据的标注信息不能使用,然而在源域图像数据上训练得到的 UDAN 网络模型能够较为准确

地对目标域的部分视频帧进行分类.因此,本文提出了一种渐进式伪标签策略,能够有效地给目标域的部分视频

帧打标签,从而利用这些带有伪标签信息的视频帧数据对 UDAN 网络模型进行微调(fine-tune).对于目标域的视

频帧,需要满足下列条件才能获取伪标签:

max(softmax (x T K )) τ> (6)

为了使得所选择的目标域视频帧具有较高的置信度,本文将τ设置为 0.99.通过利用带有伪标签的视频帧数

据进行 UDAN 的训练,UDAN 能够直接学习到目标域视频数据的特定知识.进一步,再次利用训练后的 UDAN

执行伪标签操作,会获得更多的视频帧数据以作训练之用.通过这样一种渐进式的迭代过程,UDAN 能够进一步

提升细粒度分类能力.

3 实 验

在实验部分,为了验证本文 UDAN 方法的有效性,本文将 CUB-200-2011 数据集 [25] 、Cars-196 数据集 [26] 作

[1]

[1]

为源域图像数据集,YouTube Birds 数据集 、YouTube Cars 数据集 作为目标域视频数据集,旨在将知识从图像

迁移到视频.

3.1 数据集介绍

CUB-200-2011、Cars-196、YouTube Birds 和 YouTube Cars 这 4 个细粒度数据集的划分见表 1,分别包含了

训练集和测试集,其具体介绍如下.

(1) CUB-200-2011 数据集 [25] 是使用最为广泛的细粒度图像数据集,共包含 11 788 张图像,涵盖了 200 个

鸟类的细粒度子类别,如小白额燕鸥、普通燕鸥和福斯特燕鸥等.其数据划分如下:训练集包含 5 994

张图像,测试集包含 5 794 张图像.每一张图像都有详细的标注信息,包括图像级的类别标签、图像中

对象的位置标注信息、15 个部件的位置标注信息以及 312 个二值属性标注信息.在本文实验中,仅使

用了图像级的类别标签信息.

(2) Cars-196 数据集 [26] 共包含 16 185 张图像,涵盖了 196 个车类的细粒度子类别,如现代伊兰特 2007、丰

田红杉 SUV 2012 等.其数据集划分如下:训练集包含 8 144 张图像,测试集包含 8 041 张图像.每一张