Page 137 - 《软件学报》2020年第12期

P. 137

王振晗 等:融合句法解析树的汉-越卷积神经机器翻译 3803

I=[(e 1 +p 1 +s 1 ),…,(e m +p m +s m )] (4)

由于原有 CNN 编码器在嵌入层中对于单词的 embedding 向量是上下文无关的,对于给定单词在不同句子

中均由相同的 embedding 表示,无法表示词语的语义信息.通过以上方法得到的词向量是上下文相关的,相同单

词在不同上下文环境最终会得到不同的 embedding 表示,这样将位置信息、句法信息有效地融入到神经机器翻

译模型,得到的译文更符合语法规则.

3 实验与分析

3.1 实验设置

为验证本文提出的融合句法解析树的汉-越神经机器翻译方法,我们分别在汉-越、英-越两种语言对上进行

了实验,其中,汉-越语料是由实验室通过互联网爬取、人工翻译等方式收集得到的 136K 平行句对,从中随机抽

取训练集、开发集与测试集;英-越训练数据是由 IWSLT 提供的并从中抽取 132K 平行句对作为训练集,使用其

提供的开发集、测试集.

在实验数据预处理中,首先利用 JIEBA(https://github.com/jieba)中文分词工具对汉语进行分词,然后使用

MOSES 对全部训练数据进行 tokenization,lowercase 以及 clean 最终保留长度在 80 个词以内的句对.本实验使

用的基准系统是 FaceBook 的开源神经机器翻译模型 fairseq,采用卷积神经网络进行编码、LSTM 进行解码.以

及 Google 开源的 nmt 模型,采用基于 RNN 的编码器与解码器.所有实验均使用 132K 的双语平行语料作为训练

集.所使用的实验数据见表 1.

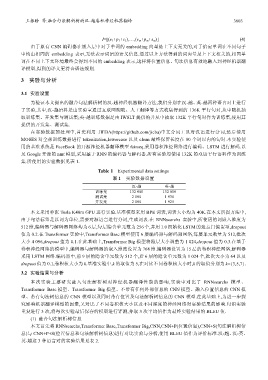

Table 1 Experimental data settings

表 1 实验数据设置

汉-越 英-越

训练集 132 000 132 000

测试集 2 000 1 930

开发集 2 000 1 925

本文采用单张 Tesla K40m GPU 进行实验.基准模型采用 BPE 词表,词表大小均为 40K.在本文所提方法中,

由于句法标签是以词为单位,需要对源语言进行分词,生成词表.在 RNNsearchs 实验中,所使用的词嵌入维度为

512 维,编码器与解码器网络均为 6 层,每层隐含单元数为 256 个,并用 1.0 初始化 LSTM 的遗忘门偏置项,dropout

值为 0.2.在 Transformer 实验中,Transformer Base 模型使用 6 层编码器与解码器网络,每层单元数量为 512,批次

大小 4 096,dropout 值为 0.1.在此基础上,Transformer Big 模型将隐层大小调整为 1 024,dropout 值为 0.3.在基于

卷积神经网络的模型中,编码器与解码器的嵌入维度设置为 768 维.编码器设置为 15 层的卷积神经网络,解码器

采用 LSTM 网络.编码器中,前 9 层的隐含单元数为 512 个,后 6 层的隐含单元数为 1 024 个,批次大小为 64 以及

dropout 值为 0.1,卷积核大小为 k.基准实验中,k 的取值为 5,在对比不同卷积核大小时,k 的取值分别为 k={3,5,7}.

3.2 实验结果与分析

本次实验主要研究融入句法解析树对神经机器翻译性能的影响,实验中对比了 RNNsearchs 模型、

Transformer Base 模型、Transformer Big 模型、不带有任何外部信息的 CNN 模型、融入位置信息的 CNN 模

型、带有句法树信息的 CNN 模型以及同时带有位置及句法解析树信息的 CNN 模型.在此基础上,为进一步探

究影响机器翻译模型的因素,又对比了不同卷积核大小以及不同深度的神经网络对实验结果的影响.每组实验

重复进行 3 次,将每次实验最后保存的模型进行评测,并取 3 次平均值作为最终实验结果的 BLEU 值.

(1) 融合句法解析树信息

本文首先将 RNNsearchs,Transformer Base,Transformer Big,CNN,CNN+P(位置信息),CNN+S(句法解析树信

息)与 CNN+P+S(位置信息和句法解析树信息)进行对比实验与分析,使用 BLEU 值作为评价标准.汉-越、汉-英、

英-越这 3 种语言对的实验结果见表 2.