Page 135 - 《软件学报》2020年第12期

P. 135

王振晗 等:融合句法解析树的汉-越卷积神经机器翻译 3801

w 2 ,…,w t }初始化为{0.1,0.2,…,0.1×t}.在本文中,我们将句法标签向量定义为 64 维的向量表征,采用自左向右的

填充方式,空白处用 0 表示.生成的句法标签向量如图 5 所示.

Fig.5 Syntactic tag sequence generation diagram

图 5 句法标签向量化

对于单词“可爱的”有句法标签对应的编码{(ROOT,1),(IP,2),(VP,3),(NP,7),(NP,7),(JJ,12)},则有

g 可爱的={(0.1×1),(0.2×2),(0.3×3),(0.4×7),(0.5×7),(0.6×12)}.

最终得到单词“可爱的”句法标签向量化表示为 g 可爱的=(0,0,0,…,0.1,0.4,0.9,2.8,3.5,7.2).

2.3 基于CNN的神经机器翻译模型

我们在实验过程中发现:由于卷积神经网络权值共享及可并行的特点,基于 CNN 的神经机器翻译模型与基

于 RNN 的神经机器翻译模型相比参数更少、收敛速度更快.同时,考虑到句法解析树是具有多层的树状结构与

卷积神经网络的结构相似,所以选择 Gehring 等人 [11] 提出的基于卷积神经网络编码器的神经机器翻译模型作为

基准模型开展实验.

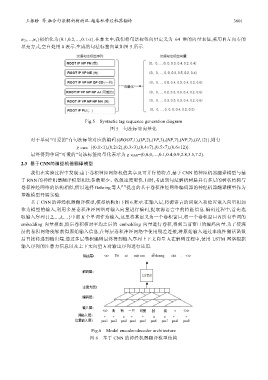

基于 CNN 的神经机器翻译模型,模型结构如下图 6 所示.在输入层,将源语言的词嵌入和位置嵌入向量相加

作为模型的输入,利用多层卷积神经网络对输入向量进行编码,提取源语言中的特征信息.编码过程中,首先选

取输入序列{1,2,…,k,…}中前 K 个单词作为输入,这里将其定义为一个卷积窗口,将一个卷积窗口内所有单词的

embedding 向量相加,然后卷积核对平均之后的 embedding 向量进行卷积,得到当前窗口的编码向量.为了使深

层的卷积网络能够获得原始输入信息,在每层卷积神经网络中使用残差连接,将原始输入通过非线性激活函数

后直接转递到输出端.通过多层卷积编码最终得到输入序列上下文向量 h.在解码过程中,使用 LSTM 网络根据

输入序列的注意力信息以及上下文向量 h 对输出序列进行还原.

Fig.6 Model encoder-decoder architecture

图 6 基于 CNN 的神经机器翻译模型结构