Page 321 - 《软件学报》2026年第1期

P. 321

318 软件学报 2026 年第 37 卷第 1 期

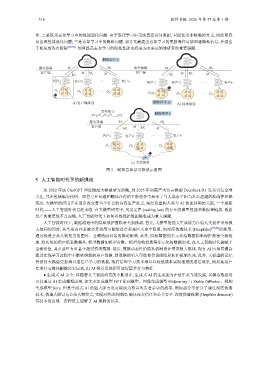

作; 二是联邦忘却学习中的性能退化问题. 由于联邦学习中无法直接访问数据, 只能使用非精确的方式, 因此更容

易出现性能退化问题; 三是忘却学习中的隐私问题. 部分文献提出忘却学习的更新操作可能泄露隐私信息, 并提出

了相应的攻击框架 [85,86] . 如何提高忘却学习的隐私性能也将成为未来该领域研究的重要课题.

删除客户 k

服务器端 M M n 服务器端 M M n

客户端 M M 2 M 客户端 M M 2

M 1 M′ 1 M

客户1 客户2 ··· 客户n 客户 1 客户 2 ··· 客户n

1 1 2 2 n n

x 1 x 2 x 1 x 2 x 1 x 2 1 1

D 1 D 2 x 1 x 2 2 2 n n

1 1 ··· D n 1 x 1 x 2 x 1 x 2

n

x 3 x 4 2 2 x 3 x 4 n D 1 \x 2 D 2 ··· D n

x 3 x 4 1 1

n

x 3 x 4 x 3 2 x 4 2 x 3 x 4 n

···

(a) 客户端级别 删除样本 x 2 1 (b) 样本级别

类型集合

Y={y , y , y ,..., y } 删除类型 k

(3)

(j)

(1)

(2)

服务器端 M M′ n

客户端 M

M′ 2 M

M′ 1

客户1 客户2 ··· 客户n

1 1 2 2 n n

x 1 x 2 x 1 x 2 x 1 x 2

D 1 D 2 ··· D n

1 1 2 2 n

x 3 x 4 x 3 x 4 x 3 n x 4

···

y (k)

(c) 类型级别

图 5 联邦忘却学习框架示意图

5 人工智能时代下的新挑战

从 2022 年底 ChatGPT 问世掀起大模型研究热潮, 到 2025 年初国产大语言模型 DeepSeek-R1 发布引发全球

关注, 其在包括编写代码、回答专业问题和翻译在内的下游任务中展示了与人类水平相当甚至超越的准确性和熟

练度. 大模型的应用正在逐步改变着当今社会的内容生产范式, 深层次重构人类与 AI 智能体间的关联, 一个崭新

时代——人工智能时代已经来临. 在大模型研究中, 尺度定律 (scaling law) 的存在将模型性能和数据量链接, 数据

资产的重要性不言而喻, 人工智能时代下如何有效保护数据隐私成为重大课题.

人工智能时代下, 数据流通中的隐私保护面临着全新挑战. 首先, 大模型的强大生成能力在给人类创作带来极

大便利的同时, 其生成内容若被恶意利用可能给社会带来巨大安全隐患, 如深度伪造技术 (Deepfake) [87,88] 的滥用,

通过伪造公众人物发言的图片、音频造成恶劣的舆论影响. 此外, 隐私数据的多元化给数据隐私保护拓宽全新维

度. 除传统的用户隐私数据外, 模型数据如模型参数、模型架构信息等多元化的数据形式, 在人工智能时代被赋予

全新价值, 其重要性有时甚至超过传统数据. 最后, 数据动态性给隐私机制设计带来极大挑战. 现有 AI 应用普遍会

通过在线学习过程中不断吸纳新的用户数据, 新数据的引入可能使得旧的隐私防护机制失效. 此外, 大模型的记忆

性使得大模型更加难以遗忘已学习的数据, 现有忘却学习技术难以以较低成本实现理想的遗忘效果, 例如某用户

要求社交媒体删除历史记录, 但 AI 推荐系统仍可能保留其行为特征.

● 生成式 AI 安全: 伴随着人工智能研究的不断进步, 生成式 AI 的生成能力在近年来飞速发展, 多模态数据均

可以通过 AI 生成理想成果, 如文本生成模型 GPT 系列模型、图像生成模型 Midjourney 与 Stable Diffusion、视频

生成模型 Sora. 但是生成式 AI 的强大能力也可能成为恶意攻击者手中的武器. 例如部分不法分子通过深度伪造

技术, 伪造人脸冒充公众人物发言, 实现对舆论的操控, 破坏社会信任和公共安全. 深度伪造检测 (Deepfake detection)

等技术的出现一定程度上缓解了 AI 换脸的危害.