Page 316 - 《软件学报》2026年第1期

P. 316

刘立伟 等: 数据要素流通全流程隐私关键技术: 现状、挑战与展望 313

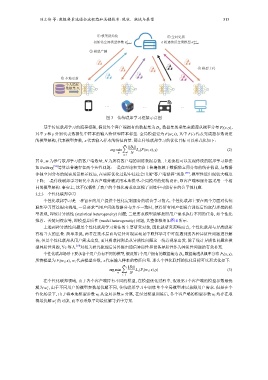

① 模型初始化 ⑤ 全局更新

1 k 轮通信后全局模型 θ k+1

初始化全局模型参数 θ global global

② 模型广播

④ 模型上传

③ 本地更新

个人隐私

数据集 D 1

··· ··· ···

图 3 传统联邦学习框架示意图

基于传统联邦学习的流程框架, 假设每个客户端拥有的数据集为 D i , 数据集的采集来源遵从概率分布 P i (x,y),

y

其中 x 和 分别代表数据集中样本的输入特征和样本标签. 全局模型记为 F(w; x), 其中 F(·) 代表完成超参数设定

的模型架构, 代表模型参数, x 代表输入样本的特征向量. 那么传统联邦学习的优化目标可以形式化如下:

||D i ||

m ∑

argmin L s (F(w; x),y) (2)

w N

i=1

其中, m 为参与联邦学习的客户端数量, N 为所有客户端的训练数据总数. 上述流程可以发现传统的联邦学习算法

如 FedAvg [52] 等算法普遍存在两个共性问题: 一是在理论和实验上普遍依赖于数据独立同分布的统计假设, 与数据

非独立同分布的现实场景相差较远, 在实际优化过程中往往会出现“客户端漂移”现象 [58] , 模型性能出现较大幅度

下降; 二是传统联邦学习研究中各客户端普遍采用本地模型-全局模型的架构设计, 即客户端和服务器采用一个相

同的模型架构. 事实上, 这不仅牺牲了客户的个性化需求也忽视了训练中可能存在的公平性问题.

3.2.3 个性化联邦学习

个性化联邦学习是一种旨在向用户提供个性化定制服务的联合学习范式. 个性化联邦主要在两个方面对传统

联邦学习算法提出挑战, 一是要求当用户间的数据分布并不一致时, 使得所有用户在联合训练后均取得理想的模

型表现, 即统计异质性 (statistical heterogeneity) 问题; 二是要求模型能够按照用户需求执行不同的任务, 如个性化

推荐、关键词搜索等, 即模型异质性 (model heterogeneity) 问题, 其整体框架如图 4 所示.

上述两种异质性问题是个性化联邦学习算法的主要研究对象, 因此就研究范畴而言, 个性化联邦与异质联邦

有相当大的重叠. 简单来说, 两者在技术层面均是针对现实场景中联邦学习中可能遇到的各种异质性问题进行解

决, 但是个性化联邦从用户需求出发, 而异质联邦则是从异质性问题这一统计现象出发. 除了统计异质性问题和模

型异质性问题, Ye 等人 [59] 对相关研究梳理后另外提出通信异质性和设备异质性作为异质性问题的有效补充.

个性化联邦场景下要求各个用户持有不同的模型, 假设第 i 个用户拥有的数据集为 D i , 数据集遵从概率分布 P i (x,y),

,

所持模型为 F i (w i ; x) w i 代表模型参数, x 代表输入样本的特征向量. 那么个性化联邦的优化目标可以形式化如下:

m ∑

||D i ||

argmin L s (F i (w i ; x),y) (3)

w N

i=1

i 个客户端的模型参数最优

在个性化联邦领域, 由于各个客户端持有不同的模型, 在模型优化过程中, 假设第

∗

解为 w , 由于不同用户的模型参数最优解不同, 传统联邦学习中训练单个全局模型难以兼顾用户需求. 但是在个

i

性化场景下, 由于将本地模型参数 w i 从全局参数 w 分离, 在经过模型训练后, 各个客户端的模型参数 w i 均存在取

w 的可能, 而不必采取平均最优解等折中方案.

∗

得最优解 i