Page 175 - 《软件学报》2026年第1期

P. 175

172 软件学报 2026 年第 37 卷第 1 期

提升. 此外, 为提高测试的效率和准确率, 各种测试优化方案受到关注. 综上所述, 当前研究正呈现出以下趋势: 从

手工定义简单场景, 过渡到利用人工智能构建复杂场景; 从只关注漏洞挖掘的效果, 过渡到效率与效果并重; 从发

生碰撞行为等简单的测试预言, 过渡到处理交通规则间复杂逻辑的测试预言.

5 面向整车系统的自动驾驶安全测试评估

5.1 常用评价指标

研究人员使用多种评价指标评估实验的效果和效率. 由于部分指标服务于研究工作的特定需求, 适用性有限,

因此本文仅总结了具备较强通用性的评价指标, 涉及的文献如表 5 所示.

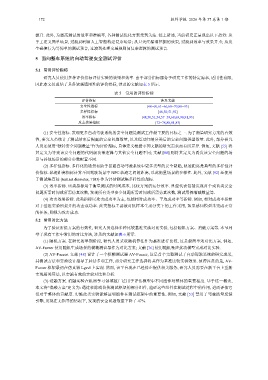

表 5 常用的评价指标

评价指标 涉及文献

安全性指标 [48−60,61−66,68−70,88−93]

多样性指标 [48,50,51,92]

效率指标 [48,50,51,54,57−59,68,69,90,91,93]

攻击效果指标 [72−78,80,81,83]

(1) 安全性指标. 发现更多自动驾驶系统的安全问题是测试工作最主要的目标之一. 为了衡量研究方案的有效

性, 研究人员统计了测试结束后揭露的安全问题数量, 以及经过归纳分类后的安全问题类型数量. 此外, 部分研究

人员还使用“独特安全问题数量”作为评价指标, 具体定义根据不同文献的研究需求而有所差异. 例如, 文献 [55] 将

其定义为导致该安全问题的代码级决策逻辑与其他安全问题不同; 文献 [60] 则将其定义为诱发该安全问题的场

景与其他场景的部分参数配置不同.

(2) 多样性指标. 多样化的场景有助于暴露自动驾驶系统中更多类型的安全缺陷, 轨迹距离是典型的多样性评

价指标. 轨迹距离指标计算不同驾驶场景中 NPC 轨迹之间的距离, 以此衡量场景的多样性. 此外, 文献 [92] 还使用

了测试集直径 (test set diameter, TSD) 作为评估测试集多样性的指标.

(3) 效率指标. 该类指标用于衡量测试的时间成本, 比较方案的运行效率. 典型代表包括发现首个或首类安全

问题所需时间或所需仿真次数, 发现所有类型安全问题所需时间或所需仿真次数, 测试用例缩减数量等.

(4) 攻击效果指标. 此类指标以攻击成功率为主, 包括相对成功率、平均成功率等指标. 例如, 相对成功率指相

对于基准实验所提升的攻击成功率. 此类指标主要被对抗样本生成分类下的工作采用, 如果感知模型未完成正常

的任务, 则视为攻击成功.

5.2 常用对比方法

为了验证所提方案的有效性, 研究人员选择多种比较基准实施对比实验, 包括随机方案、消融方案等. 本节列

举了现有工作中常用的对比方法, 涉及的文献如表 6 所示.

(1) 随机方案. 在研究的早期阶段, 研究人员采取随机算法作为基准进行比较, 这是最简单的对比方案. 例如,

AV-Fuzzer 使用随机生成场景的模糊测试器作为对比方案; 文献 [76] 使用随机噪声扰动模型完成对比实验.

(2) AV-Fuzzer. 文献 [48] 设计了一个模糊测试器 AV-Fuzzer, 这是首个完整测试了自动驾驶系统的研究成果,

其测试方法和实验设计指导了后续多项工作, 部分研究工作选择将其作为基准比较实验效果. 值得注意的是, AV-

Fuzzer 框架最初在仿真器 Lgsvl 上实现. 然而, 该平台现在已经停止提供相关服务, 研究人员需要在新平台上重新

实现相关算法, 以实施有效的实验对比和分析.

(3) 消融方案. 消融实验在机器学习领域被广泛用于评估模型中不同组件对整体的重要程度. 基于这一概念,

本文将“消融方案”定义为: 通过移除或替换测试框架的部分组件, 验证这些组件在测试过程中的作用, 进而评估它

们对于整体的贡献度. 实施此类实验能够证明组件在测试框架中的重要性. 例如, 文献 [53] 禁用了驾驶质量反馈

引擎, 发现在无指导的情况下, 发现的安全问题数量下降了 47%.