Page 64 - 《软件学报》2025年第12期

P. 64

李春奕 等: 基于时序逻辑的需求文本隐含语义解析与推理 5445

如公式 (7) 所示:

h i = η(W ·[h i−1 , x i ]+b)⊙tanh(Z i ) (7)

其中, η 为输出门的 Sigmoid 激活函数, ⊙ 是逐元素乘积, W 和 b 是输出门的权重和偏置. Z i 是记忆单元. 在反向

LSTM 中, ¯ 信息按照序列 x i 到 x 1 的反向顺序处理. 双向 LSTM 的每个时间步 i 的输出是 e, 通过加权系数 a 拼接

h i

i ∑

LSTM 的隐藏状态得到, 即 e = a j ∗h j ∗ 为标量乘法). 编码器可以同时利用过去和未来的上下文信息, 更有利于

(

j=1

捕捉需求长文本的语义. 本模块将输入的时序特征进行编码, 使用 LSTM 结构保留其时序特征. 此编码器与胶囊

网络和关系模块紧密结合, 使得编码后的时序信息能够在后续的关系计算和分类过程中持续发挥作用, 通过对时

序特征的精准编码, 也保证了高阶需求文本和低阶向量文本的语义一致性要求.

3.2.2 归纳模块

该模块主要由胶囊网络和动态路由算法组成. 胶囊网络是一种改进于传统 CNN 的深度学习架构, 其使用矢量

方向和模长共同表示特征及状态, 这种结构更适用于保留编码后的时序逻辑信息, 这对于 PPTL 时序标签分类尤

为重要. 动态路由算法允许胶囊网络在特征层次之间动态调整连接权重, 这种动态性使得网络能够更灵活地捕捉

和强调时序特征在不同网络层和神经元之间的相关性, 使得网络能够更精准捕获到时序逻辑排列组合信息, 识别

和区分复杂时序依赖.

s

e

根据编码器模块得到嵌入表示 e, 从支持集 S 中获得的样本向量为 , 查询集 Q 中获得的向量作为查询向量

q s 到

e , 那么从样本向量 e i,j one-hot 类向量 Υ i 的非线性映射可表示为:

s 2u 2u C

{e ∈ R } i=1,...,C,j=1,...,k 7→ {Υ i ∈ R } i=1 (8)

i,j

LSTM 的隐藏状态 h n 的大小为 u, 隐藏状态中门控单元的权重矩阵决定了 x i 和 u 之间的映射关系. 对每一个

类别的样本应用胶囊网络中的动态路由算法 [29] , 每个类别中的胶囊将负责捕捉该类别的特征, 并通过动态路由算

法完成信息传递. 为了使模块能够支持不同规模的输入, 支持集中的所有样本向量共享相同的变换权重 W s ∈ R 2u×2u .

其中每个样本的预测向量 ˜ e s 的计算公式可表示为:

i,j

s

s

˜ e = ϑ(W S e +b s ) (9)

i,j i,j

其中, ϑ 是非线性压缩函数 squash, 它可以使向量方向保持不变, 但是压缩了向量大小. 然后, 模块继续将样本嵌入

向量映射到对应的类向量, 动态路由算法设置了 ϖ i 是耦合系数的 logits 值, 该系数确定了不同胶囊之间的关系和

联系强度, 动态路由算法可在每次迭代过程中自动调整连接强度. 通过 Softmax 归一化路由机制, 确保每个类别 i

与该类中所有支持样本之间的耦合系数 d i = Softmax(ϖ i ) 的总和为 1. 接下来, 每个类别样本的预测结果是类 i 中所

有样本预测向量的加权和:

∑

Υ i = d i,j · ˜e s (10)

e

i,j

j

ˆ Υ i = ϑ(Υ i ), 确保其长度不会超过 1. 每轮迭代的最后, 使用一致

使用非线性压缩函数得到路由过程的矢量输出 e

s

性路由方法调整耦合系数的值 d i,j = Softmax(ϖ i,j + ˜e · ˆ Υ i ). 当生成的类别预测向量在某一样本预测呈现较高的标

i,j

量输出时, 会触发自上而下的反馈, 更新该样本的耦合系数, 并相应地降低其他样本的耦合系数, 这种调整策略增

强了小样本学习的分类准确率. 根据以上描述, 本文将其总结到了算法 2 中进行展现.

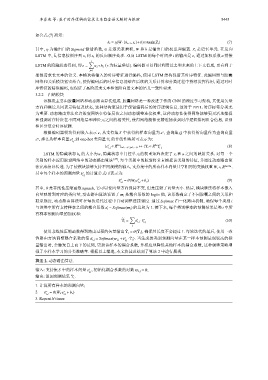

算法 2. 动态路由算法.

s

输入: 支持集 S 中的样本向量 e , 初始化耦合系数的对数 ϖ i,j = 0;

i,j

ˆ Υ i .

输出: 返回预测结果

1. 计算所有样本的预测向量;

s

s

2. ˜ e = ϑ(W S e +b s )

i,j i,j

3. Repeat N times: