Page 63 - 《软件学报》2025年第12期

P. 63

5444 软件学报 2025 年第 36 卷第 12 期

(v i ,v j ,γ i,j ) 来描述句子单词之间的依赖关系, 此关系可以捕捉到

中单词之间的语义关联关系. 给定句子 V 中, 使用

单词间语法和语义的连接.

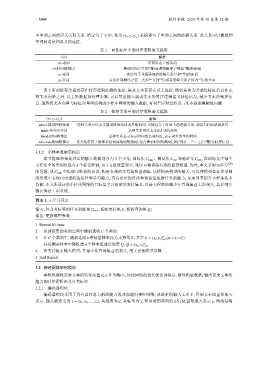

表 1 词性标注中的时序逻辑语义提取

Γ(v) 解释

vb-动词 不同时态下的动词

rb-时间修饰语 表达时间 (“立即”等)或逻辑顺序 (“因此”等)的副词

cc-连词 表达句子或短语间的逻辑关系 (“和”等)的连词

in-介词 表达时间顺序 (“在…之前”“直到”等)或者逻辑关系 (“因为”等)的介词

表 2 所列依存关系是存在时序逻辑依赖的连接, 需求文本若存在以上连接, 则将其作为关联性特征信息补充

到文本向量之后. 以上的数据预处理步骤, 可以突出输入需求文本的时序逻辑语义特征信息, 减少文本的噪声信

息. 最终将文本向量与特征向量串联构成小样本网络的输入数据, 有利于应对自然语言文本描述模糊性问题.

表 2 依存关系中的时序逻辑语义提取

(v i ,v j ,γ i,j ) 解释

advcl-副词性修饰语 这种关系可以表示副词修饰动词或其他谓词, 可能包含了时间上的逻辑关系, 通常为时间状语从句

mark-从句引导词 这种关系可以表示if引导的从句

tmod-时间修饰语 这种关系表示表示时间的名词短语, 表示动作发生的时间

advmod-副词修饰语 这类通常用于修饰形容词或动词的副词, 包含表示时间的副词, 如(“现在…”“…之后”等)含时序信息

3.1.2 小样本数据集构造

本节继续将预处理后的输入数据划分为 3 个子集, 训练集 C train 、测试集 C test 和验证集 C dev , 在训练集中每个

支持集中的类别仅包含 k 个标记样例, 由于 k 值设置较小, 难以直接训练有效的监督模型. 为此, 本文采用元学习 [28]

C train 中提取可转移的知识, 构造有效的支持集和查询集. 这样构造模型的输入, 可以使模型在标签受限

的思想, 从

的情境中表现出更强的适应性和学习能力, 具有更好的泛化和快速适应新任务的能力, 从而显著提升小样本技术

性能. 本文所设计的小样本网络的目标是学习给定的支持集 S , 以最大程度地减少在查询集 Q 上的损失, 其详细步

骤在算法 1 中呈现.

算法 1. 元学习算法.

S

输入: 包含有标签的样本训练集 C train , 初始支持集 , 初始查询集 Q;

输出: 更新模型参数.

1. Repeat N times:

C 个类别

2. 从训练集的类别空间中随机选取

S

m

3. 在 C 个类别中, 随机选取 k 带标签样本作为支持集 , 其中 S = (x s ,y s ) (m = k ×C)

s=1

Q Q = (x q ,y q )

并从剩余样本中随机选 n 个样本组成查询集 , n

q=1

4. 将支持集 S 输入模型, 并最小化查询集 Q 的损失, 用于更新模型参数

5. End Repeat

3.2 神经网络架构模块

本模块接收需求文本的特征向量表示作为输入, 经过网络的迭代优化训练后, 最终模型收敛, 输出需求文本所

蕴含的时序逻辑语义分类标签.

3.2.1 编码器模块

编码器模块采用了具有自注意力机制能力的双向递归神经网络, 从给定的输入文本 V, 得到文本向量化嵌入

表示. 输入被定义为 x = {x 1 , x 2 ,..., x i }, 其维度为 d, 其标签为 y, 然后使用双向的 LSTM 提取嵌入表示 e, 网络结构