Page 156 - 《软件学报》2025年第9期

P. 156

马杰 等: 基于相关性提示的知识图谱问答 4067

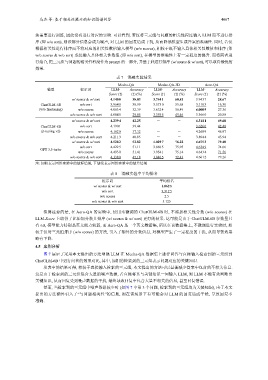

法需要进行训练, 因此没有进行对应的实验. 可以看到, 若仅将三元组与问题的相关性程度输入 LLM 而不进行排

序 (即 w/o sort), 则该部分信息会成为噪声, 对 LLM 的回复造成干扰, 从而降低模型生成答案的准确性. 同时, 若仅

根据相关性进行排序而不将对应的相关性数值输入模型 (w/o scores), 相较于既不输入具体相关性数值和排序 (即

w/o scores & w/o sort) 或仅输入具体相关性数值 (即 w/o sort), 在模型的准确性上有一定程度的提升. 而将两者进

行结合, 把三元组与问题的相关性程度作为 prompt 的一部分, 并基于此进行排序 (w/ scores & w/ sort), 可以取得最优的

效果.

表 7 消融实验结果

Mecha-QA Mecha-QA-3D Aero-QA

模型 提示词 LLM- Accuracy LLM- Accuracy LLM- Accuracy

Score (↑) (↑) (%) Score (↑) (↑) (%) Score (↑) (↑) (%)

w/ scores & w/ sort 4.140 8 38.03 3.754 1 60.81 3.943 7 28.67

ChatGLM-6B w/o sort 3.964 8 30.99 3.573 0 55.68 3.110 3 16.38

(w/o finetuning) w/o scores 4.063 4 32.39 3.632 4 56.49 4.000 9 27.36

w/o scores & w/o sort 4.084 5 29.85 3.359 5 49.46 3.366 0 20.88

w/ scores & w/ sort 4.239 4 42.25 - - 4.311 1 49.60

ChatGLM-6B w/o sort 4.190 1 39.44 - - 3.626 0 42.48

(p-tuning v2) w/o scores 4.162 0 37.32 - - 4.268 9 46.97

w/o scores & w/o sort 4.211 3 40.85 - - 3.894 4 45.94

w/ scores & w/ sort 4.528 2 52.82 4.029 7 76.22 4.675 3 79.40

w/o sort 4.422 5 51.11 3.886 5 75.95 4.634 9 74.66

GPT 3.5-turbo

w/o scores 4.493 0 51.41 3.954 1 75.14 4.643 4 71.56

w/o scores & w/o sort 4.338 0 47.18 3.840 5 72.43 4.661 2 79.26

注: 加粗表示同组实验中的最好结果, 下划线表示同组实验中的最差结果

表 8 消融实验中平均排名

提示词 平均排名

w/ scores & w/ sort 1.062 5

w/o sort 3.312 5

w/o scores 2.5

w/o scores & w/o sort 3.125

值得注意的是, 在 Aero-QA 的实验中, 使用未微调的 ChatGLM-6B 时, 不添加相关性分数 (w/o scores) 在

LLM-Score 上取得了比添加分数且排序 (w/ scores & w/ sort) 更好的结果. 这可能是由于 ChatGLM-6B 参数量只

有 6B, 模型能力特别是英文能力较弱, 而 Aero-QA 是一个英文数据集, 所以在该数据集上, 不微调进行实验时, 相

较于仅对三元组排序 (w/o scores) 的方法, 引入了额外的分数信息, 对模型产生了一定程度的干扰, 从而导致效果

略有下降.

4.5 案例分析

图 7 展示了采用本文提出的方法增强 LLM 在 Mecha-QA 数据集上进行问答与直接输入检索到的三元组到

ChatGLM-6B 中进行问答的效果对比, 其中, 加粗的检索到的三元组表示问题对应的关键知识.

从表中的结果可得, 相较于直接输入检索的三元组, 本文提出的方法可以显著减少答案中包含的不相关信息.

这是由于检索到的三元组包含大量的噪声数据, 若直接将其与关键知识一同输入 LLM, 则 LLM 不能有效判断出

关键知识, 从而回复受到噪声数据的干扰, 最终导致回复中包含大量不相关的信息, 甚至回复错误.

然而, 当检索到的三元组中噪声数据较少时 (如图 7 中第 3 个问题, 检索到的三元组均为关键知识), 由于本文

提出的方法额外引入了“与问题相关性”的信息, 则在该场景下有可能会对 LLM 的回复造成干扰, 导致回复不

准确.