Page 146 - 《软件学报》2025年第9期

P. 146

马杰 等: 基于相关性提示的知识图谱问答 4057

LLMs in knowledge graph question answering in vertical domains.

Key words: large language model (LLM); knowledge graph (KG); vertical domain; question answering system; knowledge retrieval

智能问答要求机器对用户的自然语言问题进行正确作答 [1,2] . 这一过程需要机器对问题语义有较强的理解能

力且具备丰富的知识储备和逻辑推理能力, 以便准确把握问题的含义并生成准确的回答 [3] . 近年来, 大语言模型

(large language model, LLM) 呈现井喷式发展, 例如 ChatGPT (https://chat.openai.com)、ChatGLM [4,5] , 并在越来越

多的自然语言处理任务上取得出色表现 [6] . 业界开始使用 LLM 作为智能问答的“基石”, 利用其强大的语义理解能

力、逻辑推理能力以及知识储备, 构建功能强大的智能问答模型. 得益于开放域大规模语料上的预训练, 上述

LLM 对开放域知识拥有强大的理解与应用能力, 能够处理复杂性高且多样化的问题, 进而为智能问答提供更为全

面与精准的支持.

然而, 在垂直领域, 由于缺乏相应的训练数据, LLM 的表现与其在开放领域的表现差距较大, 常会产生“幻觉” [7]

现象. 针对这一问题, 研究者通过微调 LLM 或是引入外部知识 (如知识图谱) 的方式, 提升垂直领域 LLM 的问答

性能, 减少“幻觉”现象 [8] . 相对于后者, 微调 LLM 需要大量数据作为支撑, 在低资源场景下难以实现. 知识图谱作

为一种组织和表示信息的结构化方式 [9] , 用于捕获实际场景下实体之间的关系, 由大量形如“(subject, relation,

object)”形式的三元组构成, 它可以提供丰富的精细化知识. 因此, 越来越多的研究尝试将 LLM 与知识图谱进行结

合 [10−13] , 利用知识图谱中的知识, 减少 LLM 的“幻觉”现象, 进而提升智能问答模型的性能.

已有研究 [14−17] 主要针对医疗、金融、法律等相关领域, 在保持国家经济活力、带动国民经济和科技发展至关

重要的机械制造、航空航天等领域进行深入探索较少. 此外, 已有研究主要采用“检索-问答”框架进行答案预测.

为了确保关键知识条目被输入大模型, 它们通常会设置较大的知识召回量, 从而不可避免地引入噪声数据, 导致其

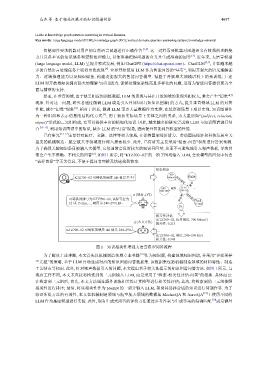

常会产生不准确、不相关的回答 [6] . 如图 1 所示, 将“KTZ700--02”的一阶子图均输入 LLM, 会使模型的回复中包含

“试样直径”等无关信息, 不便于提问者理解及快速找到答案.

知识检索

700

2

KTZ700--02 可铸铁的硬度 HB 值是多少? N/mm 抗拉强度 可铸铁

牌号

240– 硬度 KTZ ···

290 HB 700--02

(现有工作)

··· 试样直径 12或

可铸铁的牌号为 KTZ700--02, 试样直径为 伸长率

12 或 15 mm,…, 硬度为 240–290 HB。 15 mm

2%

相关性评估

[KTZ700--02, 抗拉强度, 700 N/mm ] 2

(本文方法)

相关性: 0.213

KTZ700--02 可铸铁的硬度 HB 值是 240–290。

···

[KTZ700--02, 硬度, 240–290 HB]

相关性: 0.948

图 1 知识相关性增强大语言模型问答流程

为了解决上述难题, 本文首先以机械制造领域专业书籍 [18] 作为知识源, 构建领域知识图谱, 并采用“多轮采样

三元组”的策略, 基于 LLM 自动生成对应的知识图谱问答数据集. 该数据集包括机械制造领域的材料特性、制造

工艺特点等知识. 此外, 针对噪声数据引入的问题, 本文提出基于相关性提示的知识图谱问答方法. 如图 1 所示, 与

现有工作不同, 本文未直接将检索到的三元组输入 LLM, 而是采用了“检索-相关性评估-问答”的框架. 具体而言:

在检索到三元组后, 首先, 本文方法通过额外训练相关性计算模型进行相关性评估; 其次, 将检索到的三元组按照

相关性进行排序; 最后, 将该相关性作为 prompt 的一部分输入 LLM, 帮助其选择合适的知识进行问题作答. 为了

验证所提方法的有效性, 本文在机械制造领域与航空航天领域的数据集 Mecha-QA 和 Aero-QA [19] 上使用不同的

LLM 作为基座模型进行实验. 此外, 现有生成式问答的评价方法通过参考答案与生成答案的精确匹配 [10] 或是额外