Page 405 - 《软件学报》2025年第5期

P. 405

王晨旭 等: 基于半监督和自监督图表示学习的恶意节点检测 2305

98

AUC (%) 96

+

CAMD (ours) CAMD (ours)

94 GHRN PC-GNN

APPNP

1 5 10 15 20 30 40

Label rate (%)

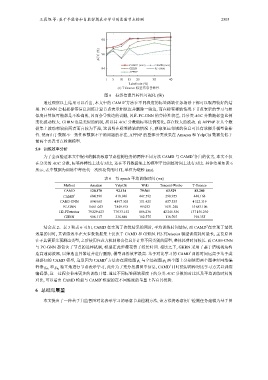

(e) T-finance 标签信息鲁棒性

图 6 标签信息鲁棒性可视化 (续)

+

通过观察以上结果可以看出, 本文中的 CAMD 方法在不同程度的标签稀缺任务场景下都可以取得较好的结

果. PC-GNN 会根据标签信息训练计算节点表示相似度并删除一些边, 而在标签稀缺情况下节点表示的学习与相

似度计算很可能都是不准确的, 因而会导致边的误删, 因此 PC-GNN 的鲁棒性较差, 其分类 AUC 分数随标签比例

变化波动较大. GHRN 也是类似的机制, 所以其 AUC 分数随标签比例变化, 存在较大的波动. 而 APPNP 在几个数

据集上波动相较前两者而言较为平稳, 这说明在标签稀缺的情况下, 获取更远邻域的信息可以有效提升模型鲁棒

性. 然而由于数据不一致性和数据不平衡问题的存在, APPNP 的整体分类效果在 Amazon 和 YelpChi 数据集低于

前两个恶意节点检测模型.

5.8 训练效率分析

为了全面验证本文中提出的解决恶意节点检测任务的两种不同方法 CAMD 与 CAMD 各自的优劣, 本文不仅

+

在分类的 AUC 分数, 标签鲁棒性上进行对比, 还在不同数据集上的模型平均训练时间上进行对比. 具体结果如表 6

所示, 表中数据为训练中每迭代一次所花费的时间, 单位为毫秒 (ms).

表 6 每 epoch 平均训练时间 (ms)

Method Amazon YelpChi Wiki Tencent-Weibo T-finance

CAMD 120.370 92.134 79.561 63.529 83.280

CAMD + 684.591 418.946 447.592 298.955 440.168

CARE-GNN 894.965 4 897.303 151.425 657.535 4 322.319

PC-GNN 1 661.053 7 849.918 99.032 1 031.240 15 683.106

H2-FDetector 79 229.423 77 033.152 806.236 42 246.556 137 156.230

GHRN 908.117 336.880 102.575 118.705 190.355

+

结合表 2、表 3 和表 6 可知, CAMD 在实现了次优结果的同时, 平均训练时间最短, 而 CAMD 在实现了最优

效果的同时, 其训练效率在大多数数据集上仅次于 CAMD 和 GHRN. H2-FDetector 模型训练耗时最长, 主要原因

在于其需要先预测边类型, 之后使用注意力机制聚合信息并计算不同类别的原型, 整体耗费时间较长. 而 CARE-GNN

与 PC-GNN 都包含了节点的选择机制, 模型在此步骤花费了较长时间. 相比之下, GHRN 采用了基于谱域视角构

造高通滤波器, 以筛选出异常边并进行删除, 模型训练效率最高. 基于对比学习的 CAMD 训练时间远高于基于类

+

+

别感知的 CAMD 模型, 这是因为 CAMD 方法会在原始图 ϕ 1 与全局视图 ϕ 2 两个图上分别使用两个图神经网络编

+

独立地进行节点表示学习, 此外为了充分挖掘图中信息, CAMD 同时使用两种对比学习方式以训练

码器 和

g ϕ 1 g ϕ 2

编码器, 这一过程会带来更多的训练开销. 通过不同标签稀缺程度下的分类 AUC 分数的对比以及平均训练时间的

+

对比, 可以看出 CAMD 模型与 CAMD 模型的在不同维度的考量上各有其优势.

6 总结与展望

本文提出了一种基于自监督图对比表示学习的恶意节点检测方法, 该方法将恶意用户检测任务建模为基于图