Page 241 - 《软件学报》2025年第5期

P. 241

贺瑞芳 等: 基于去噪图自编码器的无监督社交媒体文本摘要 2141

面向话题的社交媒体摘要数据集, 其中的帖子均来自 Twitter. 考虑到帖子的实时性, 数据集中帖子的发布时间都

分布于相关事件发生前后特定的一段时间间隔内. TWEETSUM 包含共 44 034 个帖子与共计 11 240 个用户, 以及

用户之间的社交关系. 每一组帖子集合具有 4 个由标注者提取的标准参考摘要, 用于对抽取摘要结果进行评估. 在

本文的实验中, 链接以及其他特殊符号均被移除, 同时对帖子的文本内容进行了词干提取, 并去除停用词, 最终过

滤掉长度小于 3 的帖子. Weibo 数据集中的帖子来自新浪微博社交媒体平台, 该数据集中包含 130k 帖子以及

126k 用户, 共分为 10 个热点话题. 其中的帖子根据帖子之间的社交关系以树状结构组织. 每个话题下具有 3 个由

标注者构造的标准参考摘要, 用于对摘要结果的质量进行评估. 在实验中使用人们常用的 ROUGE [69] 评估标准对

摘要结果进行评估. 该方法通过对比模型产生摘要与标准参考摘要之间 n-gram 的重合度来评估生成摘要的质量.

本文实验中汇报 ROUGE-1, 2, L 以及 ROUGE-SU*这 4 个评估标准, 在后文中分别记为 R-1, R-2, R-L 以及 R-SU*.

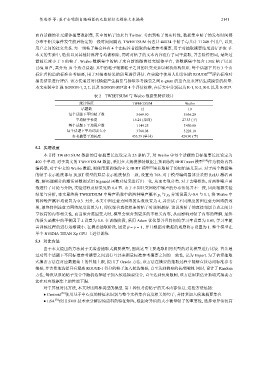

表 2 TWEETSUM 与 Weibo 数据集特征统计

统计特征 TWEETSUM Weibo

话题数 12 10

每个话题下平均帖子数 3 669.50 5 636.20

平均帖子长度 16.24 (单词) 27.33 (字)

每个话题下平均用户数 1 144.25 5 450.80

每个话题下平均词表大小 3 760.08 3 228.10

参考摘要平均长度 453.79 (单词) 424.90 (字)

5.2 实现设置

本节将 TWEETSUM 数据的目标摘要长度设定为 25 条帖子, 对 Weibo 中每个话题的目标摘要长度设定为

400 个单词. 对于英文的 TWEETSUM 数据, 采用在大规模推特数据上预训练的 BERTweet 模型 [68] 作为初始内容

编码器, 对于中文的 Weibo 数据, 则使用预训练的中文 BERT 模型 [8] 来获取帖子的初始语义表示. 对于两个数据集

的帖子表示维度都与 BERT 模型的隐层表示维度保持一致, 设置为 768. 对于模型编码器部分采用 ReLU 激活函

数, 解码器部分的激活函数则采用 Sigmoid 函数对结果进行归一化, 从而实现分类. 对于去噪模块, 对两种噪声函

数进行了讨论与分析, 实验过程及结果见第 6.4 节. 由于不同社交网络中噪声的分布情况并不一致, 因此根据实验

结果与分析, 本文最终将 TWEETSUM 中噪声函数中的两种噪声概率 p i 与 p d 分别设置为 0.4 与 0.1, 将 Weibo 中

两种噪声概率均设置为 0.3. 另外, 本文中图注意力网络的头数设置为 4, 并尝试了不同深度的图注意力网络的效

果, 最终将图注意力网络深度设置为 1, 即仅聚合直接相连的帖子时效果最好. 这说明帖子的直接邻居节点之间共

享较高的内容相关性, 而当聚合范围变大时, 模型会聚合到更多的不相关内容, 从而影响对帖子内容的理解. 最终

的损失函数中的平衡因子 λ 设置为 0.8. 在训练阶段, 采用 Adam 优化器并且将初始学习率设置为 0.01, 学习率随

η 设置为 1. 整个模型在

着训练过程的进行逐渐减小. 在摘要抽取阶段, 固定 β = γ = 1 , 并且根据对数据的观察将

单个 NVIDIA TITAN Xp GPU 上进行训练.

5.3 对比方法

由于本文提出的方法属于无监督抽取式摘要模型, 因此这里主要选取相同类型的对比模型进行比较. 首先通

过对每个话题下不同标准参考摘要之间进行互评来衡量标准参考摘要之间的一致性, 记为 Expert. 为了估算抽取

式摘要方法在对应数据集上的性能上限, 提出了 Oracle 方法, 该方法在摘要的抽取过程中能够直接访问标准参考

摘要, 并贪婪地选择具有最高 ROUGE-1 得分的帖子加入候选摘要, 直至达到摘要的长度限制. 同时, 设计了 Random

方法, 每次从原始帖子集合中随机选择帖子加入候选摘要集合, 直至达到长度限制, 该方法用来估计抽取式摘要方

法在对应数据集上的性能下限.

对于其他对比方法, 本文对比两种类型的模型. 第 1 种仅考虑帖子的文本内容信息, 这些方法包括:

● Centroid [70] 使用基于中心度的特征来识别与整个文档集合高度相关的句子, 并将其加入候选摘要集合.

● LSA [71] 使用 SVD 技术来分解原始语料的特征矩阵, 根据奇异值的大小衡量帖子的重要性, 选择奇异值较高