Page 240 - 《软件学报》2025年第5期

P. 240

2140 软件学报 2025 年第 36 卷第 5 期

需要注意的是, 由于原始帖子中存在较多的噪声内容与不规范表达, 在重构的过程中忽略了无意义与噪声的内

容 (如停用词、拼写错误的单词、缩写、链接等), 这样能够保持一个较小的词表大小. 采用这种重构方式, 一

方面能够保持解码器部分的参数量尽可能少, 另一方面能够限制内容解码器的能力, 从而将重构的压力更多地

聚焦于主体的编码部分. 由于我们的主要训练目标是训练一个能力较强的编码器, 而非重构模块. 因此, 实验中

对文本重构模块采用了较为简单的设计, 从而将文本重构的压力聚集到主体的编码器模块, 尽可能提升编码器

的编码能力.

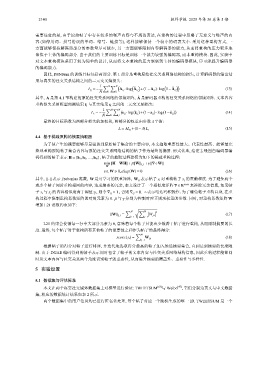

因此, DSNSum 的训练目标包括两部分. 第 1 部分是重构原始社交关系网络结构的损失, 计算解码器的输出结

果与真实的社交关系结构之间的二元交叉熵损失:

1 ∑ ∑ ( ( ) ( ) ( ))

N

N

L g = − A i j ·log ˆ A i j + 1−A i j ·log 1− ˆ A i j (13)

N i j

其中, A 是第 4.1 节构建的原始社交关系网络的邻接矩阵, ˆ A 是解码器重构的社交关系网络的邻接矩阵. 文本内容

重构损失采用模型预测结果 ˆ s i 与真实结果 s i 之间的二元交叉熵损失:

1 ∑ ∑ N ( ( ) ( ) ( ))

N

L c = − s ij ·log ˆ s ij + 1−s i j ·log 1− ˆ s i j (14)

N i j

最终的目标函数为两部分损失的加权和, 两部分的权重由参数 λ 平衡:

(15)

L = λL g +(1−λ)L c

4.4 基于稀疏重构的摘要抽取器

为了使产生的摘要能够尽量覆盖到原始帖子集合的主要内容, 本文抽取重要性最大、代表性最高、能够最完

整地重构原始帖子集合内容与原始社交关系网络结构的帖子作为最终的摘要. 形式化地, 给定去噪图自编码器编

码得到的帖子表示 H = [h 1 ,h 2 ,...,h N ] , 帖子的抽取过程建模为如下的稀疏重构过程:

min||H−WH||+β||W|| 2,1 +γ||∇◦W||

W

s.t. W ⩾ 0,diag(W) = 0 (16)

||·|| 表示 s j 的贡献程度. 为了避免两个

其中, Frobenius 范数, W 是可学习的权重矩阵, W ij 表示帖子 s i 对重构帖子

或多个帖子同时重构相同的内容, 造成摘要的冗余, 本文设计了一个相似度矩阵 ∇ ∈ R N×N 来移除冗余信息, 如果帖

∇ i j = 0. ◦ 表示哈达玛积操作. 为了避免帖子重构自身, 在重

子 s i 与 s j 的内容相似度高于阈值 η , 则令 ∇ ij = 1 , 否则

构过程中限制重构系数矩阵的对角元素为 0. β 与 γ 分别为控制对应正则项权重的参数. 同时, 对重构系数矩阵 W

增加 L21 范数约束如下:

√

∑ N ∑ 2

N

||W|| 2,1 = W j,i (17)

i=1 j=1

L21 约束会使得每一行中大部分元素为 0, 意味着每个帖子只能由少数若干帖子进行重构, 从而限制摘要的长

度. 最终, 每个帖子对于重构所有其他帖子的重要性之和作为帖子的最终得分:

∑

N

score(s i ) = W j,i (18)

j=1

根据帖子的得分对帖子进行排序, 并迭代地选取得分最高的帖子加入候选摘要集合, 直到达到摘要的长度限

制. 由于 DGAE 编码得到的帖子表示同时包含了帖子的文本内容与社交关系网络结构信息, 因此重构过程能够同

时从文本内容与社交关系两个角度识别帖子的重要性, 从而提升摘要的覆盖性、重要性与多样性.

5 实验设置

5.1 数据集与评估标准

本文在两个真实社交媒体数据集上对模型进行验证: TWEETSUM [63] 与 Weibo [47] , 它们分别为英文与中文数据

集, 相应的数据统计结果如表 2 所示.

两个数据集中的用户信息均已进行匿名化处理, 每个帖子对应一个随机生成的唯一 ID. TWEETSUM 是一个