Page 410 - 《软件学报》2025年第4期

P. 410

1816 软件学报 2025 年第 36 卷第 4 期

在 ST-Conv block 中, 作为时间学习模块的两个 TCN 模块和作为空间学习模块的一个 GCN 模块像“三明治”

结构串联堆叠, 其中 TCN 模块的通道数是 64, GCN 模块的通道数是 16. 然而, STGCN 仅捕获了空间静态相关性,

而忽视了节点和边的特征可能会因为周期相关性而发生动态变化, 因此在性能上仍有提升的空间.

由于以往的方法中在空间层面上定义了固定的邻接矩阵来表示静态图, 而这对实际场景中真实的空间依赖关

系建模不足, 此外, 时间层面中使用循环神经网络处理长期依赖具有固有限制. 基于此, Wu 等人 [18] 提出的 Graph

WaveNet 分别使用了融合自适应邻接矩阵的空域 GCN [19] 和基于门控机制的扩张因果卷积 [20] , 并将这两个模块串

行连接进行时空集成来解决以上两个主要问题.

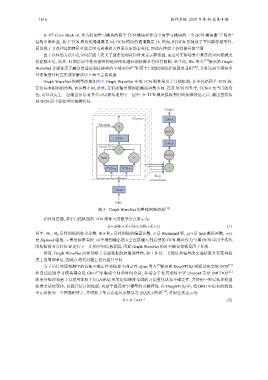

Graph WaveNet 的模型结构如图 3. Graph WaveNet 中的 TCN 组件采用了门控机制, 其中包括两个 TCN 块,

它们共享相同的结构, 而参数不同, 此外, 它们的输出使用的激活函数不同. 在该 TCN 组件中, TCN-b 充当门的角

色, 可以决定上一层输出信息有多少可以被传递到下一层中. 在 TCN 模块提取到时间依赖特征之后, 输出直接传

到 GCN 层中提取空间依赖特征.

Output

H 进行下一步的空间信息提取, 因此

K layers Linear

Residual

+

ReLU

GCN

Linear

Gated TCN

×

ReLU

tanh σ

TCN-a TCN-b +

Skip

connections

Linear

Input

图 3 Graph WaveNet 的整体网络架构 [18]

在时间层面, 基于门控机制的 TCN 组件可用数学公式表示为:

h = g(Θ 1 ∗X+b)⊙σ(Θ 2 ∗X+c) (1)

c

,

其中, Θ 1 Θ 2 是待训练的权重参数, 而 b 和 是待训练的偏置参数, ⊙ 是 Hadamard 积, g(·) 是 tanh 激活函数, σ(·)

是 Sigmoid 函数, ∗ 表示标准卷积. 由于得到输出的 h 会直接输入到后续的 GCN 模块作为空域 GCN 中用于迭代

的初始的节点特征 Graph WaveNet 的时空融合架构是因子化的.

然而, Graph WaveNet 同样忽略了交通数据的周期规律性, 如工作日、节假日和每周的交通状况具有某种程

度上的周期重复, 因此在相关问题上仍有提升空间.

为了估计交通预测中的认知不确定性和任意不确定性, Qian 等人 [8] 提出的 DeepSTUQ 则通过将空域 GCN [19]

和自适应图学习模块耦合进 GRU 中集成空间和时间信息, 并结合了使用蒙特卡罗 dropout 方法 (MCDO) [21]

[9]

的变分推理和基于自适应加权平均 (AWA) 用来近似深度集成的方法量化认知不确定性, 并使用一种后处理模型

校准方法的变体, 以提升估计的性能, 有助于提高时空模型的可解释性. 在 DeepSTUQ 中, 将 GRU 中原有的线性

单元替换为一个图卷积算子, 并增加了节点自适应参数学习 (NAPL) 模块 [10] , 可用公式表示为:

1 1

ˆ A = D AD − 2 (2)

− 2