Page 375 - 《软件学报》2025年第4期

P. 375

俞诗航 等: 神经形态计算: 从脉冲神经网络到边缘部署 1781

很大程度上取决于训练算法, 而且在所有情况下, 准确率都会随着故障率的增加而迅速下降.

文献 [243] 利用大规模故障注入实验的观察结果, 确定了关键故障类型和位置. 故障模拟显示, 发生在网络中

任何位置的饱和神经元故障都可能是致命的, 而所有其他类型的故障如果发生在最后几层的神经元中, 都会影响

分类的准确性. 为了解决关键神经元的故障, 该工作为 SNN 提出了一种神经元容错策略. 该策略分为两步, 在第 1

个准备步骤中, 使用 dropout [244] 训练 SNN, 使部分层的某些神经元故障类型处于被动状态. 在第 2 步中, 执行主动

容错, 检测所有层中剩余的神经元故障并从中恢复.

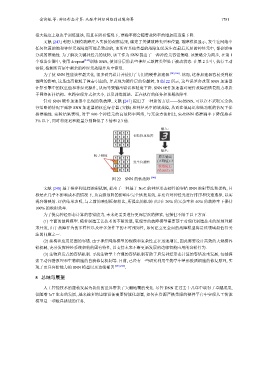

为了使 SNN 性能效率最大化, 很多研究设计并使用了专用的硬件加速器 [245,246] . 然而, 这种加速器容易受到软

故障的影响, 这是由高能粒子撞击引起的, 并表现为硬件层的位翻转, 如图 22 所示, 这些误差会改变 SNN 加速器

计算引擎中的权重值和神经元操作, 从而导致输出错误和精度下降. SNN 硬件加速器对硬件故障的恢复能力取决

于网络拓扑结构、电路实现方式和大小, 以及训练算法、正在执行的任务和预期故障率.

针对 SNN 硬件加速器中出现的软故障, 文献 [247] 提出了一种新的方法——SoftSNN, 可以在不采取冗余执

行策略的情况下减轻 SNN 加速器的权重寄存器 (突触) 和神经元中的软故障, 从而在低延迟和低功耗的情况下保

持准确性. 实验结果表明, 对于 900 个神经元的高故障率网络, 与冗余方法相比, SoftSNN 将准确率下降保持在

[249,250]

3% 以下, 同时将延迟和能量分别降低了 3 倍和 2.3 倍.

输入:

初始权重矩阵

输出:

粒子碰撞 原先输出

发生位翻转 (正确值): 3

软故障后

(错误值): 8

图 22 SNN 的软故障 [248]

文献 [248] 基于排序和选择映射机制, 提出了一种基于 NoC 的神经形态硬件的容错 SNN 映射算法和架构, 目

标是在几乎不影响成本的情况下, 从高级故障的影响中完全恢复系统, 并允许对神经元进行排序和快速选择, 以实

现容错映射. 评估结果表明, 与之前的映射框架相比, 所提出的机制可以在 20% 的冗余率和 40% 的故障率下保持

100% 的映射效率.

为了提高神经形态计算的容错能力, 未来还需要进行更深层次的探索, 包括但不限于以下方面.

(1) 全面的故障模型. 随着制造工艺技术的不断发展, 更现实的故障模型需要基于对现代制造技术的深刻理解

来开发, 由于故障行为的多样性以及许多条件下的不可预知性, 如何建立更全面的故障模型将是该领域最值得关

注的问题之一.

(2) 架构和应用层面的容错. 由于神经网络模型的规模和复杂性正在迅速增长, 因此需要设计高效的大规模容

错机制, 充分发挥神经系统架构的固有特性, 以支持未来不断更新发展的边缘智能应用的容错行为.

(3) 生物启发式的容错机制. 寻找生物学上合理的容错机制有助于启发神经形态计算的容错技术发展, 包括探

索主动容错原理和生物细胞的自我修复机制等. 目前, 已经有一些研究利用生物学中星形胶质细胞的修复原理, 实

现了更具容错能力的 SNN 模型以及边缘部署 .

5 总结与展望

人工智能技术的蓬勃发展为我们的世界带来了天翻地覆的变化. 尽管 DNN 在过去十几年中取得了卓越成果,

但随着 IoT 生态的发展, 越来越多的边缘设备需要智能化部署, 如何在资源严格受限的硬件平台中实现人工智能

模型是一项极具挑战的任务.