Page 293 - 《软件学报》2025年第4期

P. 293

樊铭瑞 等: 基于深度学习的多视图立体视觉综述 1699

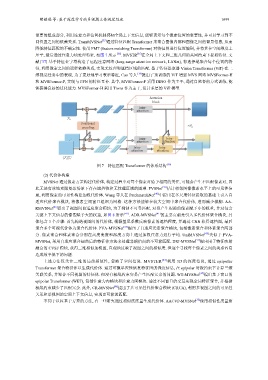

重要的组成部分, 利用注意力和位置机制感知全局上下文信息, 能够表示每个像素位置的重要性, 并可以学习到不

同位置之间的依赖关系. TransMVSNet [35] 通过特征匹配 Transformer 来聚合图像内部和图像之间的背景信息, 从而

降低特征匹配的不确定性. 使用 FMT (feature matching Transformer) 对特征图进行位置编码, 并将其在空间维度上

压平, 最后通过注意力块处理特征, 如图 7 所示 [36] . MVSTR [36] 在全局上下文和三维几何的共同约束下提取特征. 文

献 [37] 基于特征金字塔构造了远程注意网络 (long-range attention network, LANet), 有选择地聚合每个位置的特

征, 利用像素之间的远程依赖关系, 实现无纹理和遮挡区域的匹配. 鉴于特征提取器 Vision Transformer (ViT) 在二

维视觉任务中的表现, 为了更好地学习表示特征, Cao 等人 [38] 提出了预训练的 ViT 增强 MVS 网络 MVSFormer-H

和 MVSFormer-P, 实现与 FPN 的特征互补. 其中, MVSFormer-P 采用 DINO 作为主干, 通过自监督的方式训练, 能

够获得良好的泛化能力. MVSFormer-H 采用 Tiwns 作为主干, 设计多层的 ViT 模型.

Attention

block

... Intra-

attention

上述方法仅关注二维的局部相似性, 忽略了空间信息. MVSTER

0

Positional

encoding ×N a

... ... Intra- Intra-

attention attention

... Intra- Intra-

attention attention

N−1

{ i } i=1

图 7 特征匹配 Transformer 的体系结构 [36]

(2) 代价体构建

MVSNet 通过像素方差构建代价体, 构建过程中对每个像素对给予相同的关注, 可能会产生不匹配像素对, 因

此无法有效地克服复杂场景下存在遮挡物和无纹理区域的困难. PVSNet [39] 估计相邻图像像素水平上的可见性信

息, 利用像素的可见性构建加权代价体. Wang 等人在 PatchmatchNet [40] 中提出在多尺度特征提取的基础上引入自

适应代价聚合模块, 将像素空间窗口组织为网格. 这种方法能够在较大空间中聚合代价体, 进而减少模糊. AA-

RMVSNet [26] 提出了视图间自适应聚合模块, 为了抑制不可靠匹配, 对易产生混淆的像素赋予小的权重, 并对包含

关键上下文信息的像素赋予大的权重, 如图 8 所示 [41] . ADR-MVSNet [41] 的主要贡献是引入多代价体聚合模块, 具

体包含 3 个步骤: 首先构造视图间的代价体, 根据基尼系数反映像素的遮挡程度, 并通过 CNN 获得遮挡图, 最后

聚合多个可视代价体为聚合代价体. PVA-MVSNet [42] 提出了自适应元素聚合模块, 包括像素聚合和体素聚合两部

分. 像素聚合和体素聚合分别在高度宽度和深度方向上通过加权注意力进行平均. UniMVSNet [43] 类似于 PVA-

MVSNet, 采用自适应聚合扭曲后的特征体方法来处理非朗伯面的不可靠匹配. DRI-MVSNet [33] 提出用于特征映射

融合的 CVSF 模块, 获得二维相似加权图, 直观地反映了视图之间的相似度. 但逐个寻找每个像素之间的关系容易

造成效率低下的问题.

[44] 利用 3D 的深度信息, 通过 epipolar

Transformer 聚合特征体以生成代价体. 通过可微单应性恢复特征图的深度信息, 在 epipolar 对极约束下计算三维

关联关系, 并聚合不同视图的特征体. 但没有极线约束容易产生匹配冗余的问题. WT-MVSNet [45] 提出基于窗口的

epipolar Transformer (WET), 包括注意力内模块和注意力间模块. 通过不同窗口的交互实现全局特征聚合, 并根据

极线约束减少了匹配冗余. 此外, CR-MVSNet [46] 提出了共可见性代价聚合模块 (CRCA), 利用多视图之间的可见性

关系和单视图的空间上下文信息, 实现更可靠的匹配.

不同于以往基于方差的方法, 有一些研究通过相似度度量生成代价体. AACVP-MVSNet [32] 使用相似性度量聚