Page 245 - 《软件学报》2025年第4期

P. 245

李梓童 等: 机器遗忘综述 1651

成员推理攻击是一种用于确定某样本是否在模型训练集中出现的攻击方法. 在训练成员推理攻击模型时, 需

构建多个影子模型 (shadow model). 这些模型的行为与被攻击的模型 (目标模型) 类似, 但每个影子模型的训练集

是攻击者构造的, 即能确定某条训练数据是否在其训练集中. 攻击者给影子模型输出打上“在数据集中”和“不在数

据集中”标签, 作为攻击模型的训练集进行监督训练, 训练完成后, 攻击模型可以根据目标模型的输出来区分目标

模型是否使用了某个样本.

n

Chen 等人 [69] 使用成员推理攻击, 若攻击模型能够推理出 x 为 ∗ M unlear 训练数据, 则认为遗忘的完全度较低.

Huang 等人 [73] 进一步发展了成员推理攻击用于遗忘验证的方法, 除成员推理攻击外还使用统计只是加以完善. 假

设用户想查询数据集 Q 中的数据点是否在训练集中, 则首先对 Q 中的数据点分别使用成员推理攻击, 将成员推理

攻击准确率等作为依据, 判断这些数据点是否在训练集中. 接着, 使用统计工具统计单个数据点上的判断结果, 继

而判断整个 Q 是否在训练集中. 这种先个别判断再整体判断的方法增强了判断的稳健性, 既不需要训练额外评估

模型和高质量的校准数据集, 又支持数据集 Q 与训练集相似的情况.

给数据添加“触发器”是指对数据做一定程度的改动, 在改动后数据上训练的模型会有辨识度较高的预测行为,

如会把改动后数据都分到某个特定类别上. 若模型没有在对应数据上训练过, 则模型在这些数据上就不会有期望

∗

的预测行为, 从而可以判断出训练集中是否包含了改动后数据. 若要评估遗忘完成度, 可对 x 添加触发器, 比较

n ∗ x 同样添加了触发器的数据上的预测行为. Goel 等人 [74] 应用了触发器思想, 强调模型从 D 和

∗

M unlear 在 x 或与

D\x 中获取信息的差异, 针对以类为单位进行遗忘的场景, 提出了类间混淆 (interclass confusion) 测试方法: 首先

∗

在原始数据集中要遗忘的多类数据里错误标记一些样本 (添加触发器), 形成 x , 根据 M unlear 在标签错误和标签正

n

∗

确的样本上的预测情况量化机器遗忘完成度.

5.4 小 结

本节介绍了速度、可用性和完成度这 3 个机器遗忘效果的评估角度, 并给出对应的度量指标. 速度是指机器

遗忘相比于重新训练在减少用时上的提升, 可用性是指 M unlear 的准确率, 完成度是指 M retrai 和重新训练模型的相

n

n

似程度. 本文将 3 个角度的常见计算指标和已知条件归纳在表 8 中.

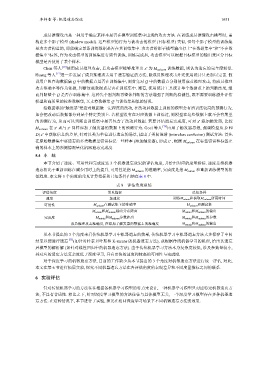

表 8 评估角度总结

对于深度学习的机器遗忘方法, 目前的工作缺少从本节提出的

评估角度 常见指标 已知条件

速度 加速比 训练M retrain 和获取M unlearn 所用时间

可用性 M unlearn 在测试集上的准确率 M unlearn 和测试集

M retrain 和M unlearn 输出分布距离 M retrain 和M unlearn 的输出

完成度 M retrain 和M unlearn 参数距离 M retrain 和M unlearn 的参数

成员推理攻击准确度, 在添加了触发器的数据上的准确度 M retrain 和M unlearn 的输出

从本节提出的 3 个角度来看传统机器学习中机器遗忘的效果, 传统机器学习中机器遗忘方法大多保存了中间

结果以便进行遗忘 [75] (如针对朴素贝叶斯和 K-means 的机器遗忘方法), 或根据传统机器学习的机理, 给出其遗忘

后模型的解析解 (如针对线性回归中的机器遗忘方法). 由于传统机器学习方法本身复杂度较低, 涉及参数量较小,

其对应的遗忘方法复杂度低于深度学习, 具有更快的速度和较高的可用性与完成度.

3 个角度对机器遗忘方法进行统一评估, 对此,

本文在第 6 节进行拓展实验, 探究不同机器遗忘方法在各评估角度的表现差异和不同度量指标之间的联系.

6 实验评估

针对传统机器学习的方法往往根据各机器学习模型的特点来设计, 一种机器学习模型只对应特定机器遗忘方

法, 不具有普适性. 相比之下, 针对深度学习模型的方法往往与具体模型无关, 一个深度学习模型存在多种机器遗

忘方法. 在这种情况下, 本节进行了实验, 探究在相同深度学习场景下不同机器遗忘方法的效果.